En este trabajo se explorarán las técnicas modernas de síntesis de imágenes físicamente realistas basadas en Path-Tracing en tiempo real. Para ello, se utilizarán métodos de integración de Monte Carlo con el fin de disminuir el tiempo de cómputo.

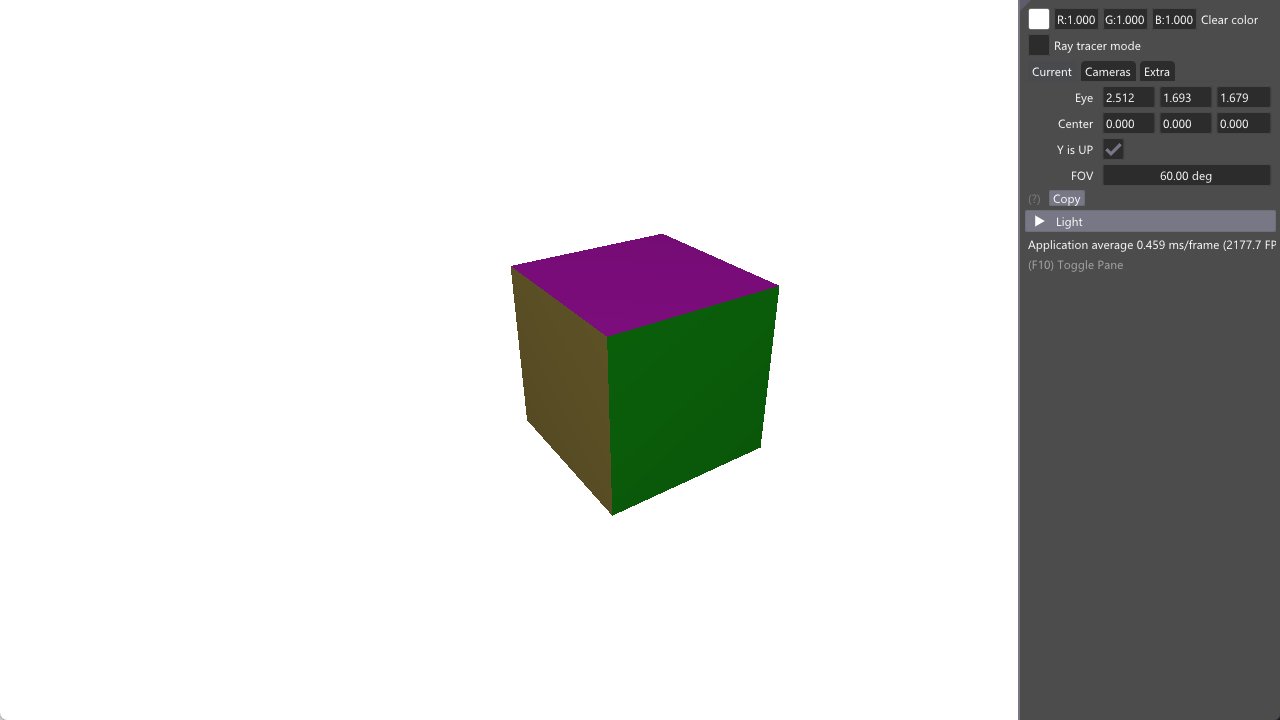

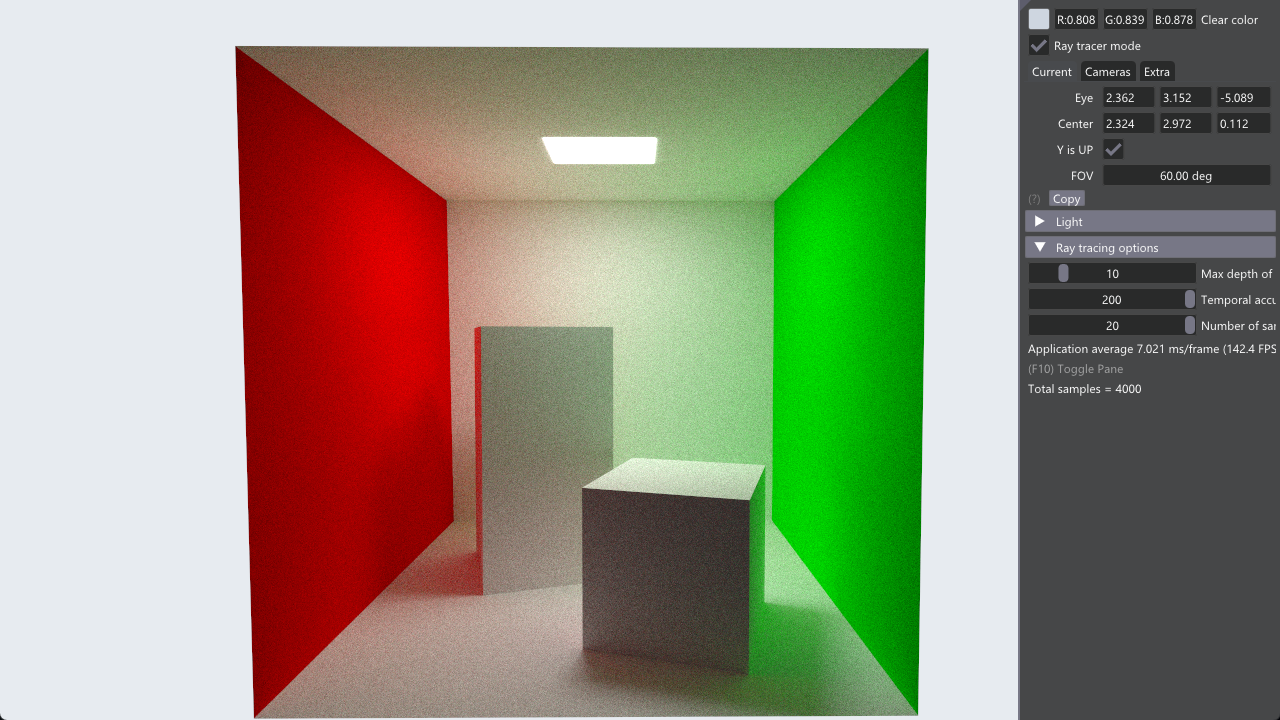

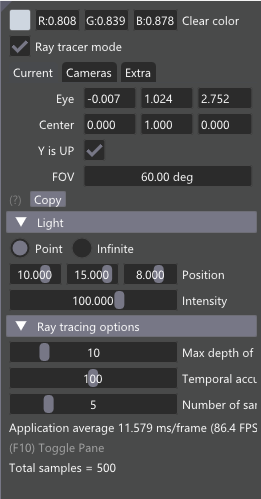

Se diseñará un software basado en la interfaz de programación de aplicaciones gráficas Vulkan, utilizando como soporte un entorno de desarrollo de Nvidia conocido como nvpro-samples (NVIDIA 2022b). El software implementará un motor gráfico basado en path tracing. Este motor será capaz de renderizar numerosas escenas, cambiar los parámetros del algoritmo path tracing y modificar las fuentes de iluminación en tiempo de ejecución.

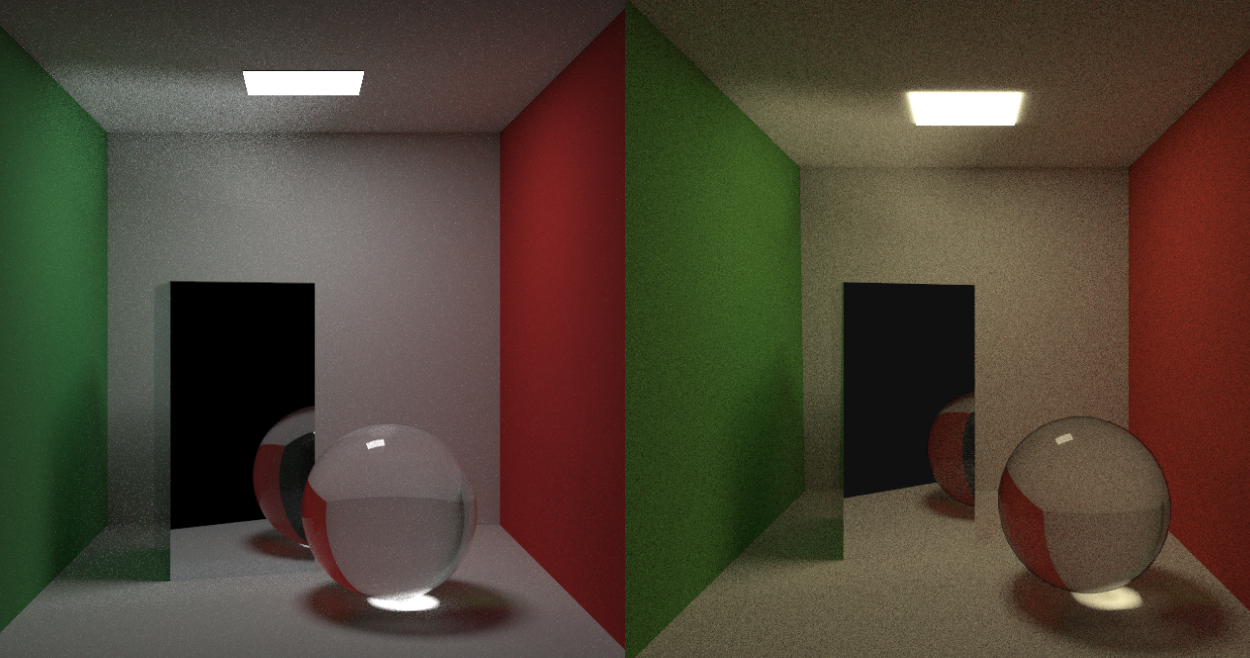

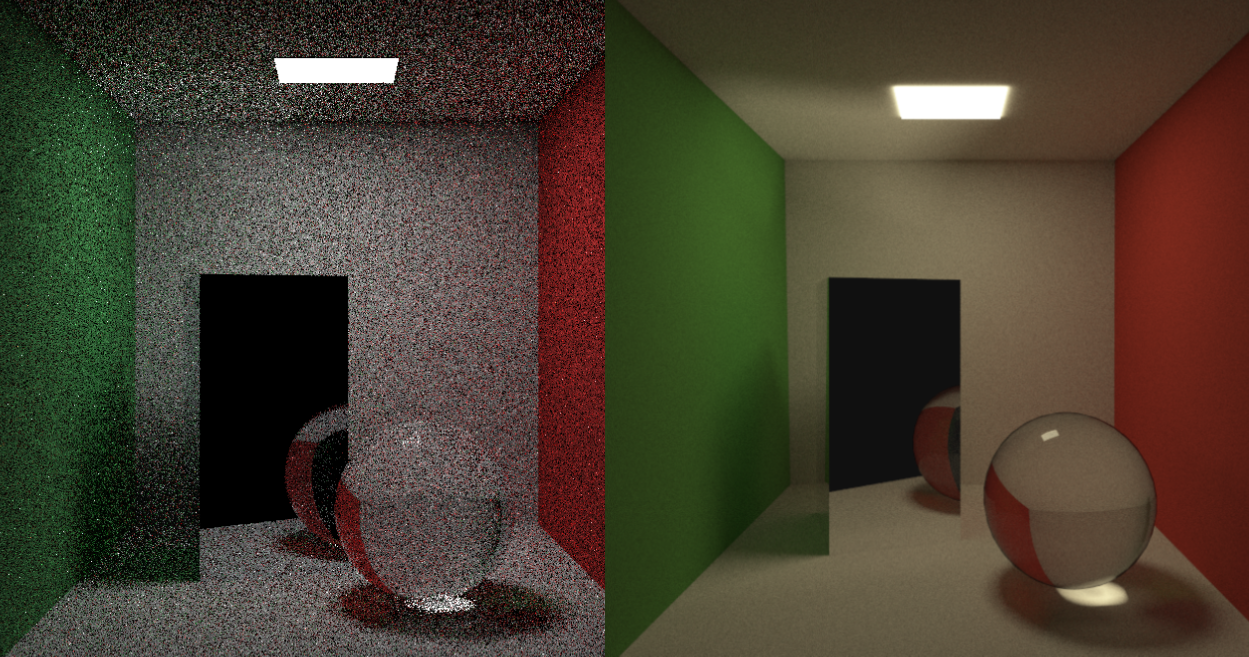

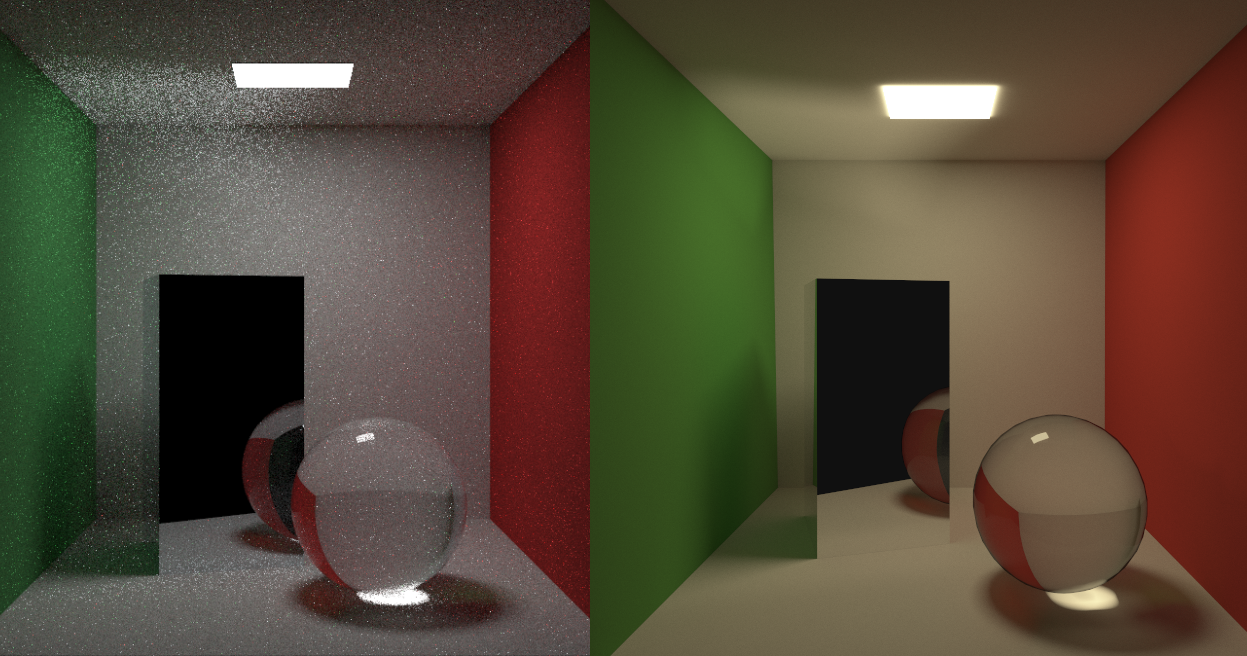

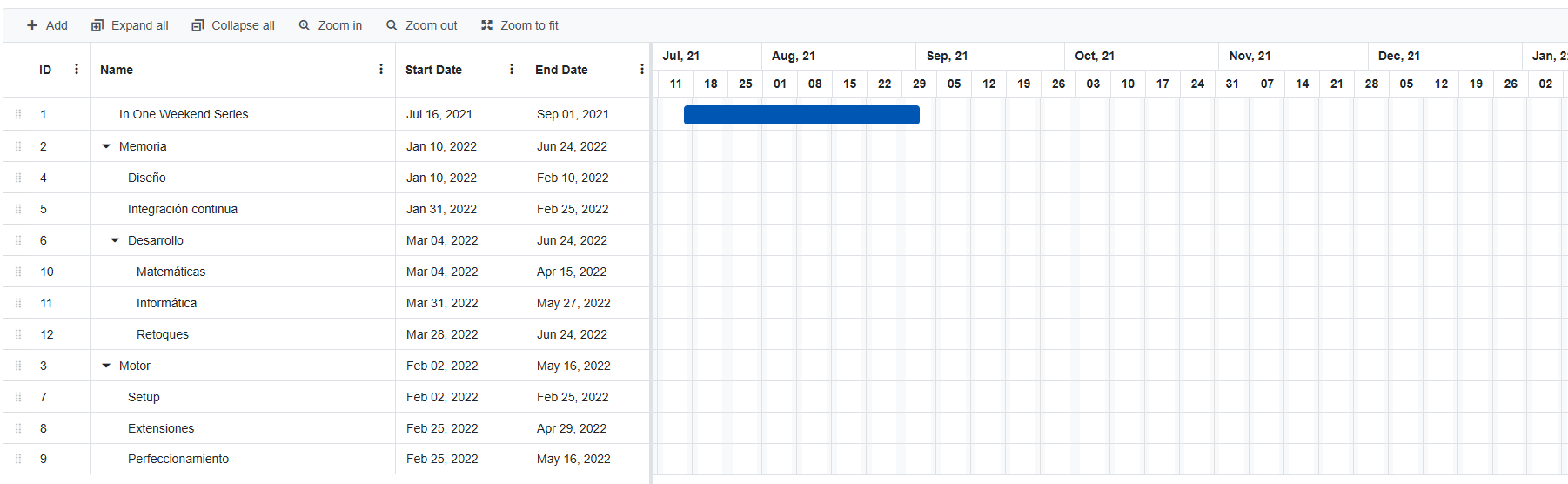

Con el fin de explorar cómo afectan diferentes métodos al ruido final de la imagen, se estudiarán algunas técnicas de reducción de varianza como muestreo directo de fuentes de iluminación, muestreo por importancia, supersampling o acumulación temporal. Además, el motor desarrollado se comparará con una implementación del software creado en los libros de (Shirley 2020a) “Ray Tracing in One Weekend series”, la cual utiliza exclusivamente la CPU. Se comprobarán las diferencias entre ambas versiones, estudiando los puntos fuertes de cada una.

Palabras clave: raytracing, ray tracing, path tracing, métodos de Monte Carlo, integración de Monte Carlo, transporte de luz, iluminación global, Vulkan.

To be able to capture a moment. Every human civilization in record has always found a way to immortalise the idiosyncrasies of its sociecy. We are not immune to this phenomenon, so it is only natural we try to use the lastest technology to achieve the most faithful representation of our world. Computers have the ability to produce realistic images and astonishing simulations. Although there have been tremendous advances in the field, many of the techniques we use today are still based on the old days of computation, especially in 3D rendering.

Rasterization is one of those methods. It allows us to transform a virtual environment to a raster image, which is a set of pixels. It is an extremelly fast method given how it works, which is just a mapping of the scene geometry into a 2D plane. Its simplicity makes it a great quick way of rendering an image, but it comes at the expense of fidelity.

We can solve this issue with Ray tracing. Instead of projecting virtual geometry into a plane, this algorithm tries to simulate how light works by casting rays of light into the scene from the camera. These rays then intersect with objects and collect information about them. This has one key advantage over rasterization: it manages to us parts of the scene which were not visible to the camera.

Path tracing takes this idea to the next level: instead of stopping in the first intersection, it makes the rays bounce freely through the scene. These rays gather information about object materials, light sources and many more elements. Then, the algorithm computes the color of the pixel by considering how much light those rays have acummulated over their traversal. This manner of working results in an improvement over ray tracing, which is often called global illumination.

Global illumination is a physical phenomenon related to indirect lightning that occurs when photons bounce off of objects and are reflected back into a room. In rasterization, it has been traditionally faked by using methods such as ambient occlusion, light maps and so on, since it is crucial in order to get a realistic image. Path tracing naturally solves this issue given the physically accurate nature of the algorithm.

The results it produces are unmatched. But they come with a major problem: rendering times. Rendering times can be crucial depending on the task at hand. Rasterization has been traditionally used in real time applications, such as video games, while path tracing is implemented in offline renderers, like the ones used for movie productions. We then need to ask one question:

Could it be possible to bring path tracing to real time?

In this project we will tackle this problem. We will build a physically based rendering engine based on path tracing with modern hardware in order to produce a software capable of producing realistic images in mere milliseconds.

As one could imagine, this task it not an easy one. In order to achieve it, we will need to understand multiple aspects of different fields: from mathematics to computer imaging, with some light notions from physics.

Chapter 1 will set the fundamentals of what ray tracing is, how a ray works, and how it intersects with an object.

In chapter 2 we will study the basics of radiometry and light transport, the field of physics that deals with the interaction between light and matter. We will introduce how photons work, how they are emitted from light sources and how they travel through the environment. We will also need to understand the mathematical abstractions in which we represent these radiometric quantities. Then, we will need to analyse how light interacts with matter, which, in a nutshell, can be described by the bidirectional scattering distribution function of the material surface and the outgoing direction of photons (since light can be either scattered or transmitted). At the end of the chapter we will obtain the most important equation in computer graphics: the rendering equation, which can be described as

\[ L_o(p, \omega_o) = L_e(p, \omega_o) + \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \cos\theta_i\ d\omega_i} \]

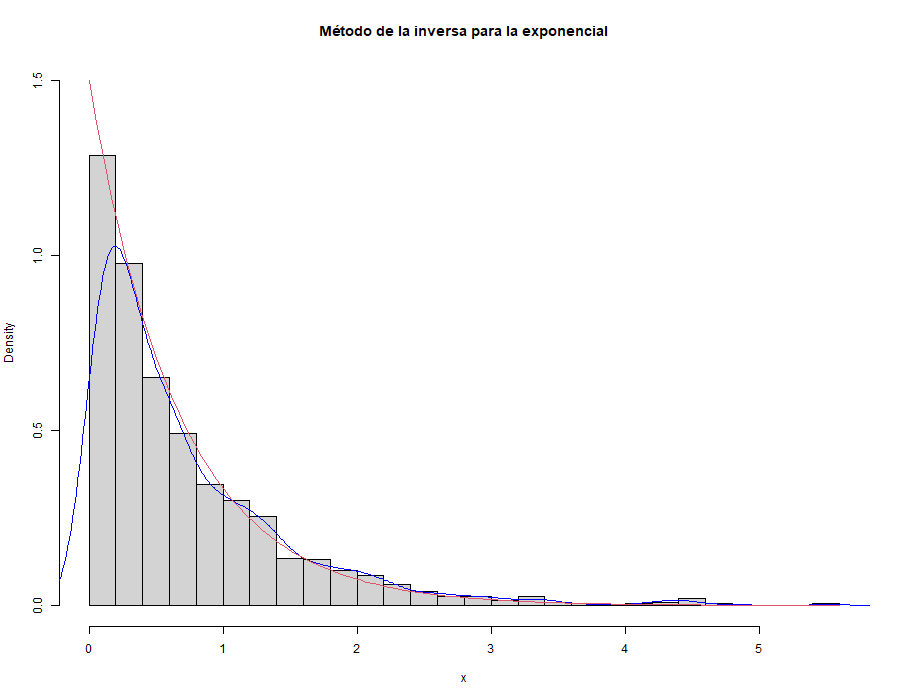

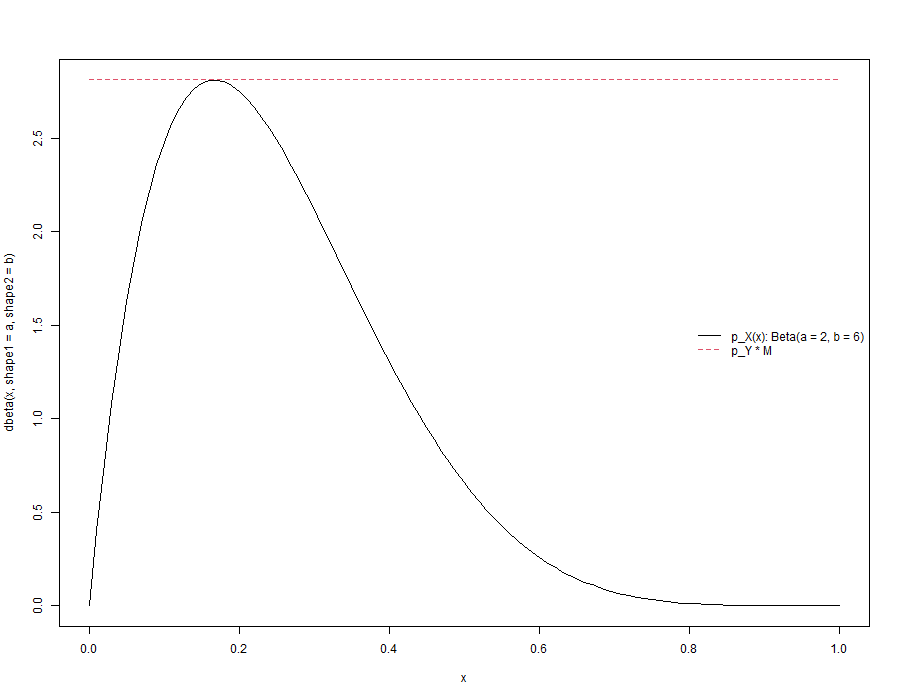

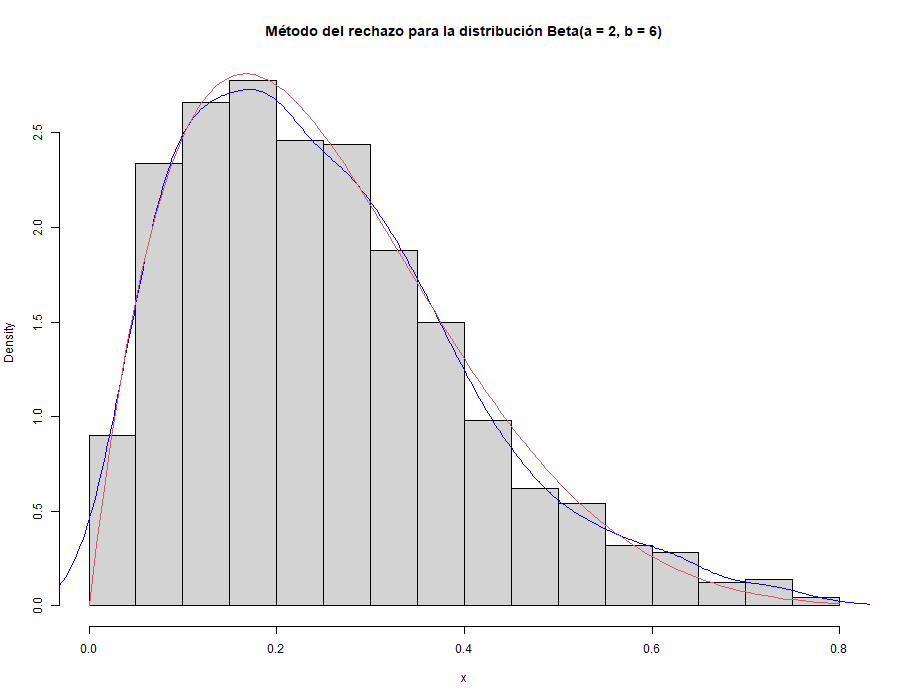

Since reality is an absurdly complex –yet simple– set of rules, we will need to find a way of making the computations viable in real time. That is why in chapter 3 we will explore how random sampling can be used to generate approximations of radiometric integrals. We will start with a brief summary of random variables. Then, we will introduce Monte Carlo techniques, which rely on sampling random variables from certain distributions (usually the uniform between 0 and 1) and averaging these samples to obtain the expected value of some other distribution. This will allow us to compute integrals relatively easily at the cost of some error. In order to improve these estimations, we will study how different methods can be used to reduce the variance of the estimator, such as (multiple) importance sampling, russian roulette, or next-event estimation.

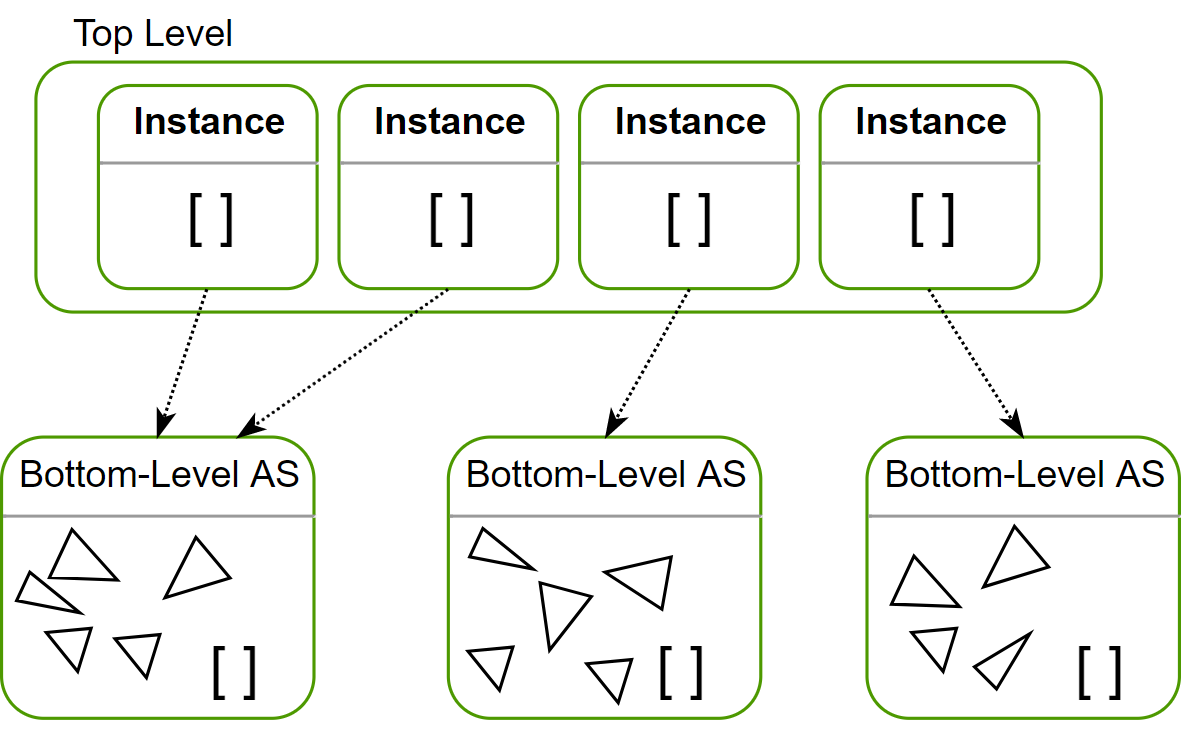

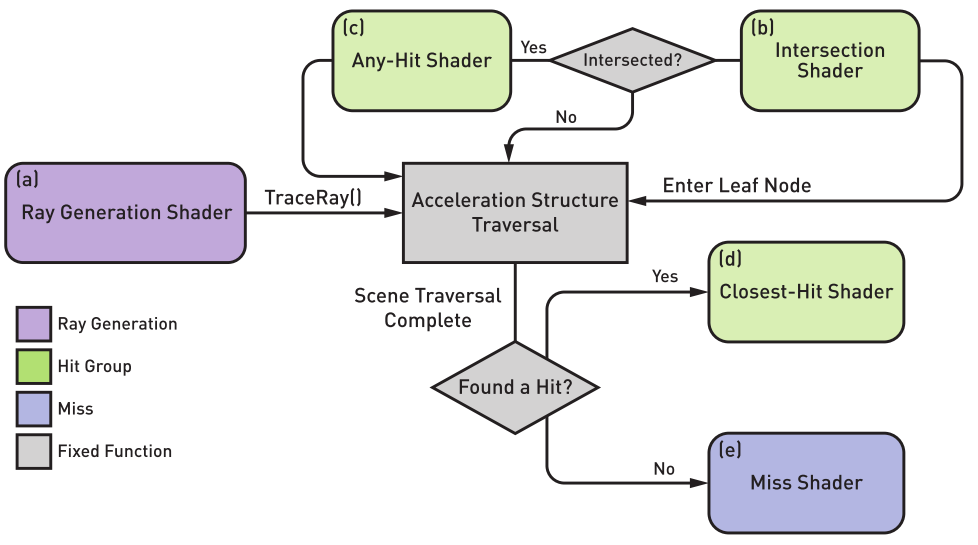

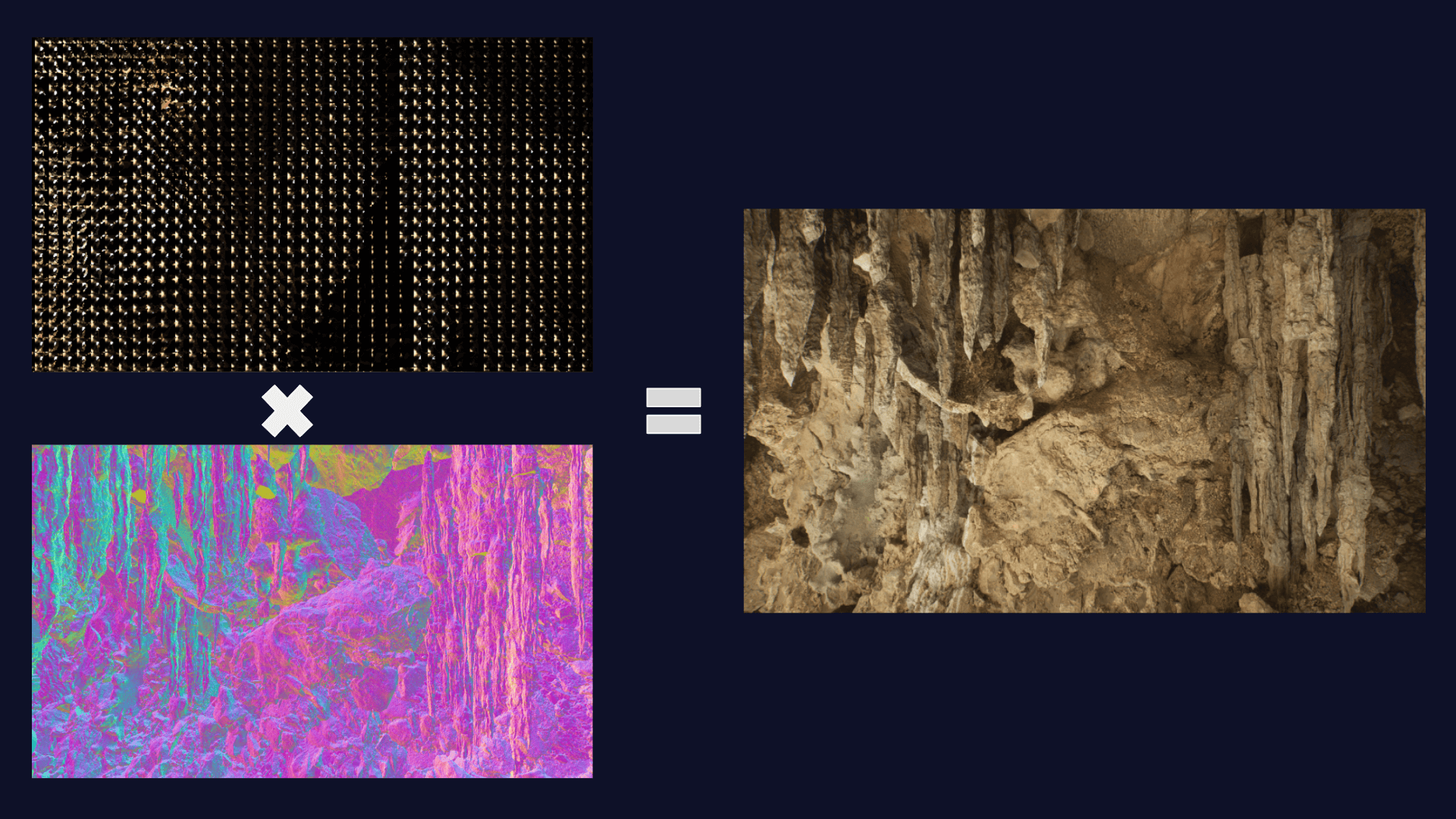

Once the theory is out of the way, it will be time to build an application. Chapter 4 will cover the implementation of the engine. We will first introduce our main set of tools, which will be Vulkan graphics API and Nvidia DesignWorks’ nvpro-samples framework (NVIDIA 2022b). Then, we will learn about the structures that make real time ray tracing possible, such as the Top and Bottom-Level Acceleration Structures (TLAS and BLAS respectively) and the Shader Binding Table (SBT). We will also understand how the ray tracing pipepline works, what types of shaders are there and how we can use them to render a scene. Materials and light sources will also need to be explained since they are a key component of the scene. Finally, we will implement some techniques which allow us to reduce the noise of the final image, such as gamma correction and temporal accumulation of frames.

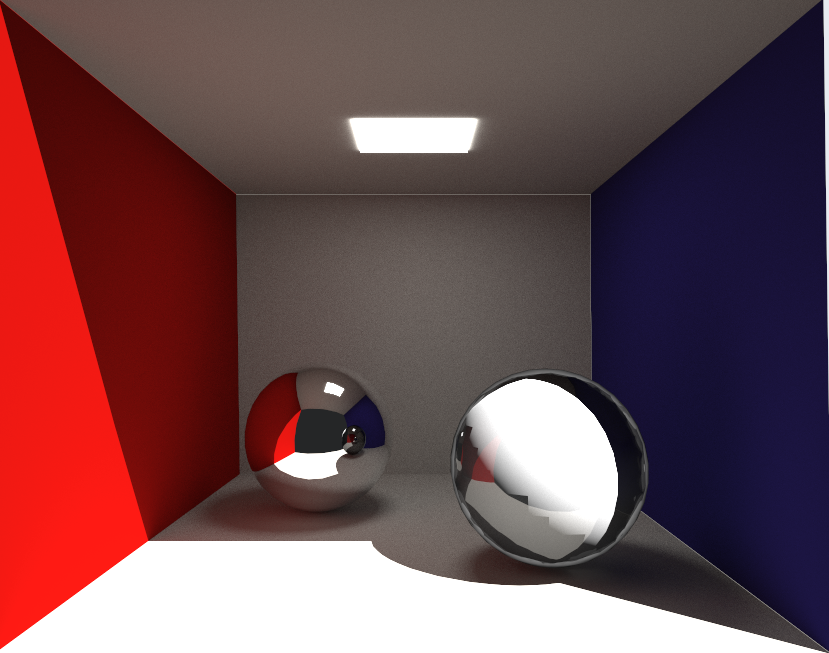

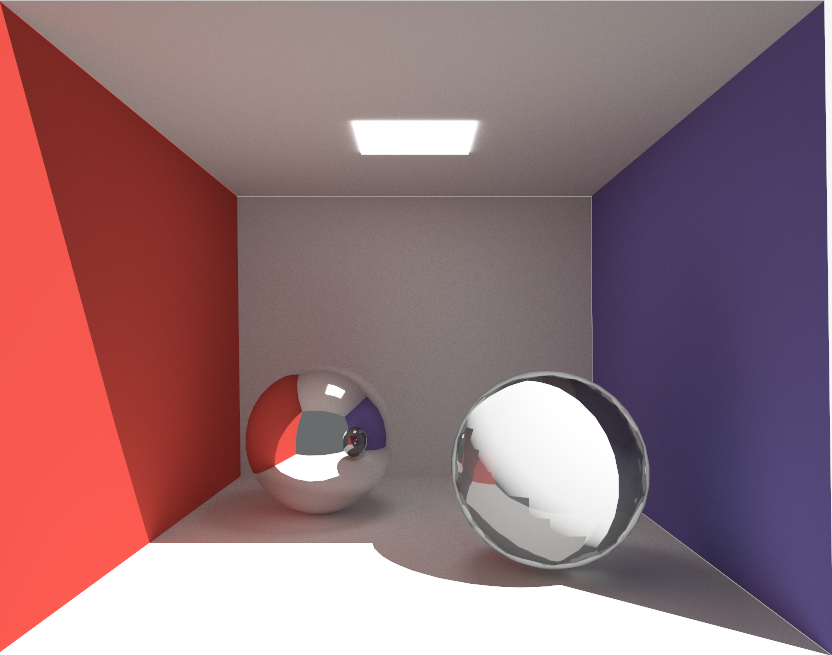

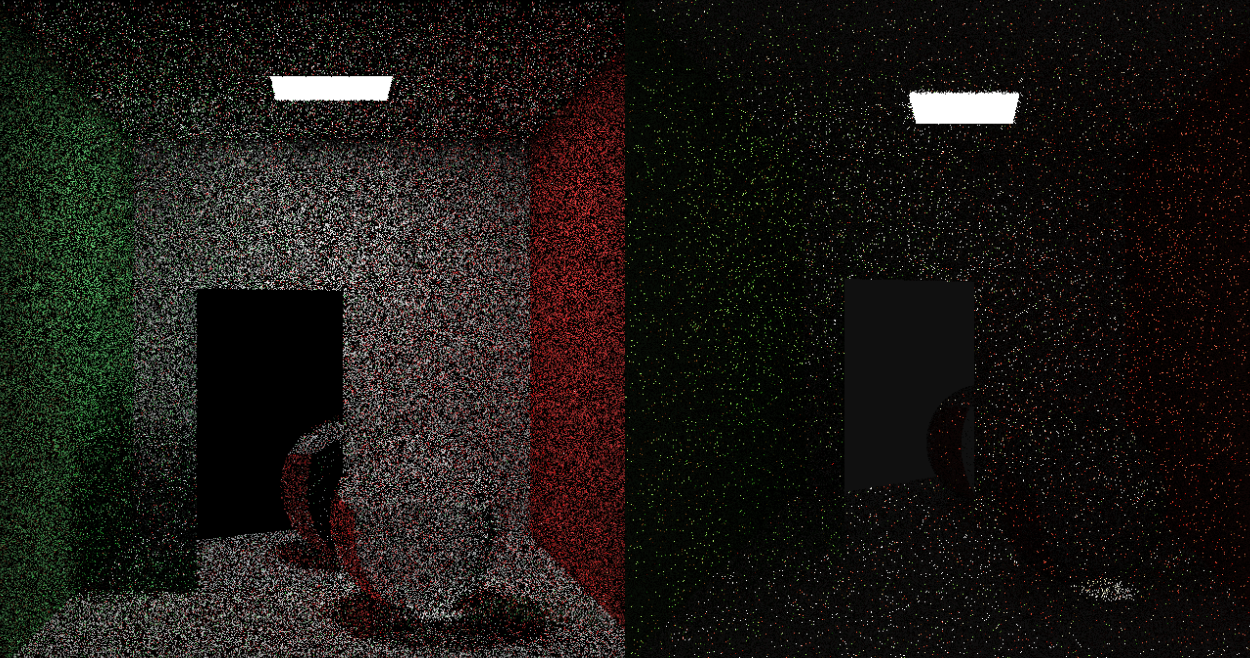

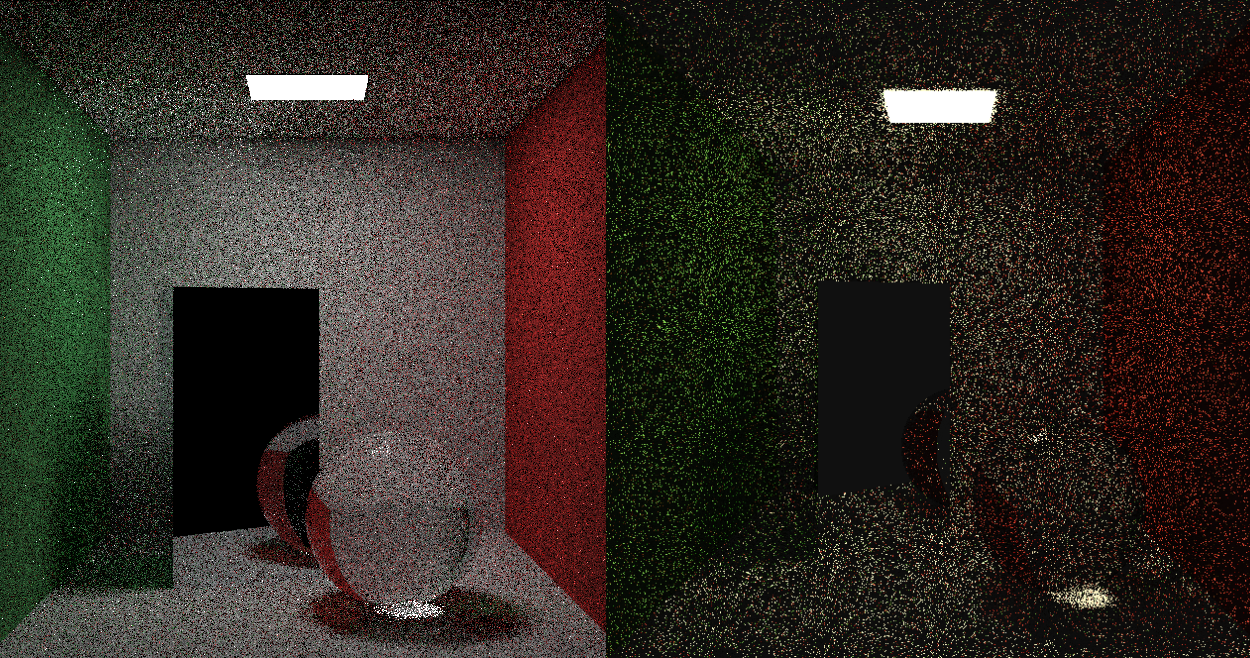

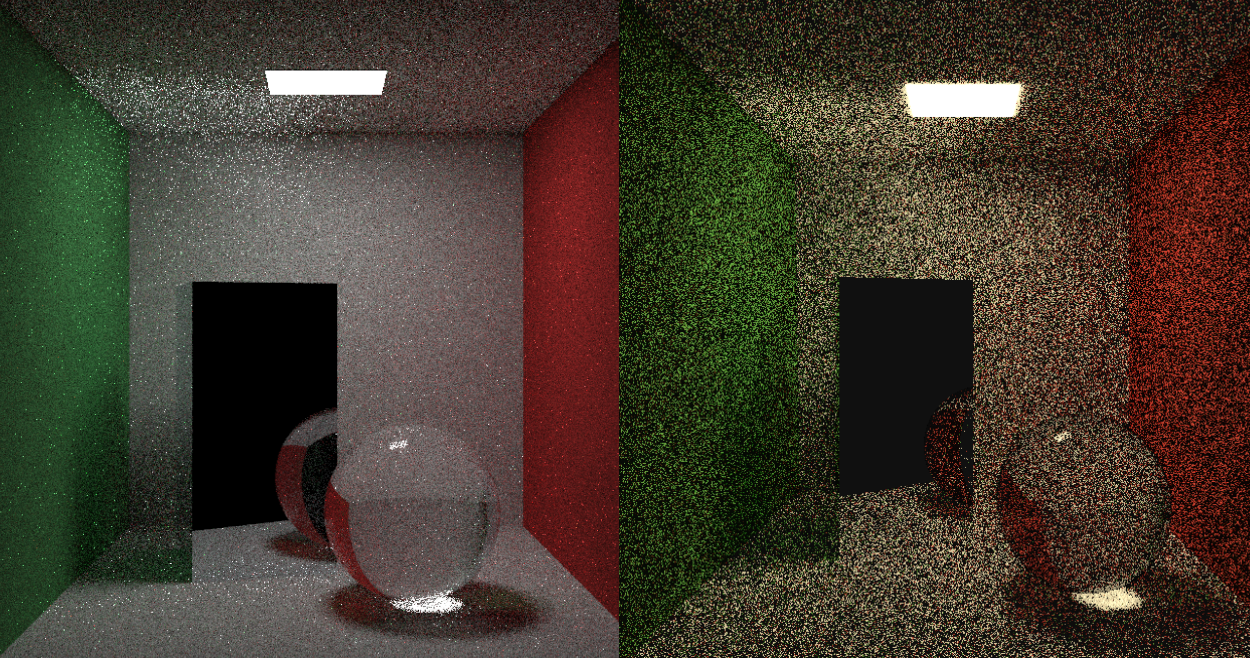

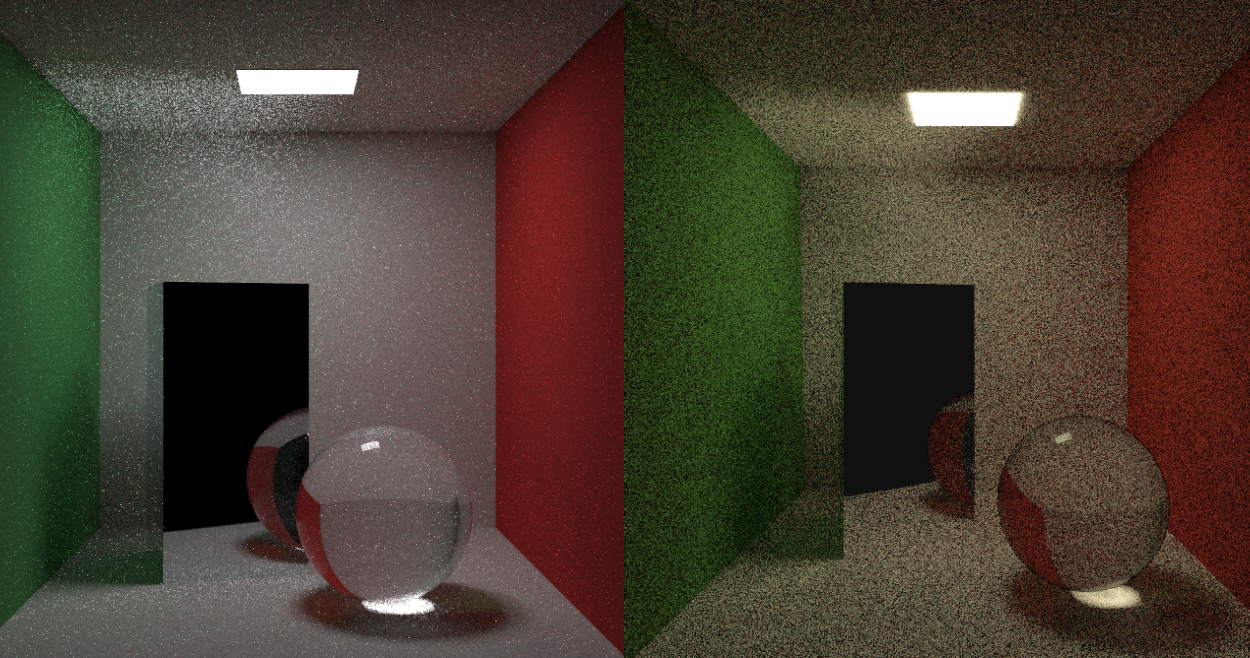

Now that we have a working engine, it is time to play with it. Chapter 5 will exhibit the results of our work, comparing different scenes that showcase a variety of physical phenomena. We will also analyse how it performs in terms of image quality and frame time based on a set of parameters, like ray depth, number of samples taken on each frame, and resolution. Finally, we will compare our implementation with Peter Shirley’s engine developed in Ray Tracing In One Weekend series (Shirley 2020a) (Shirley 2020b) (Shirley 2020a).

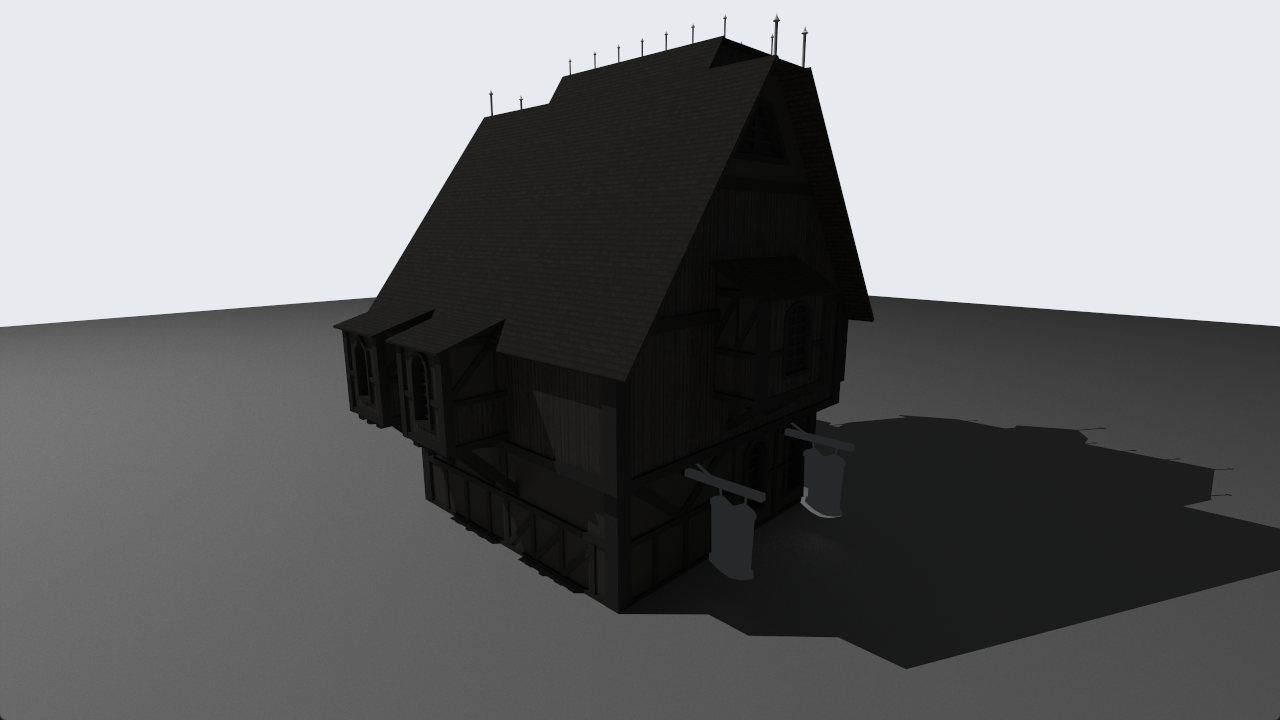

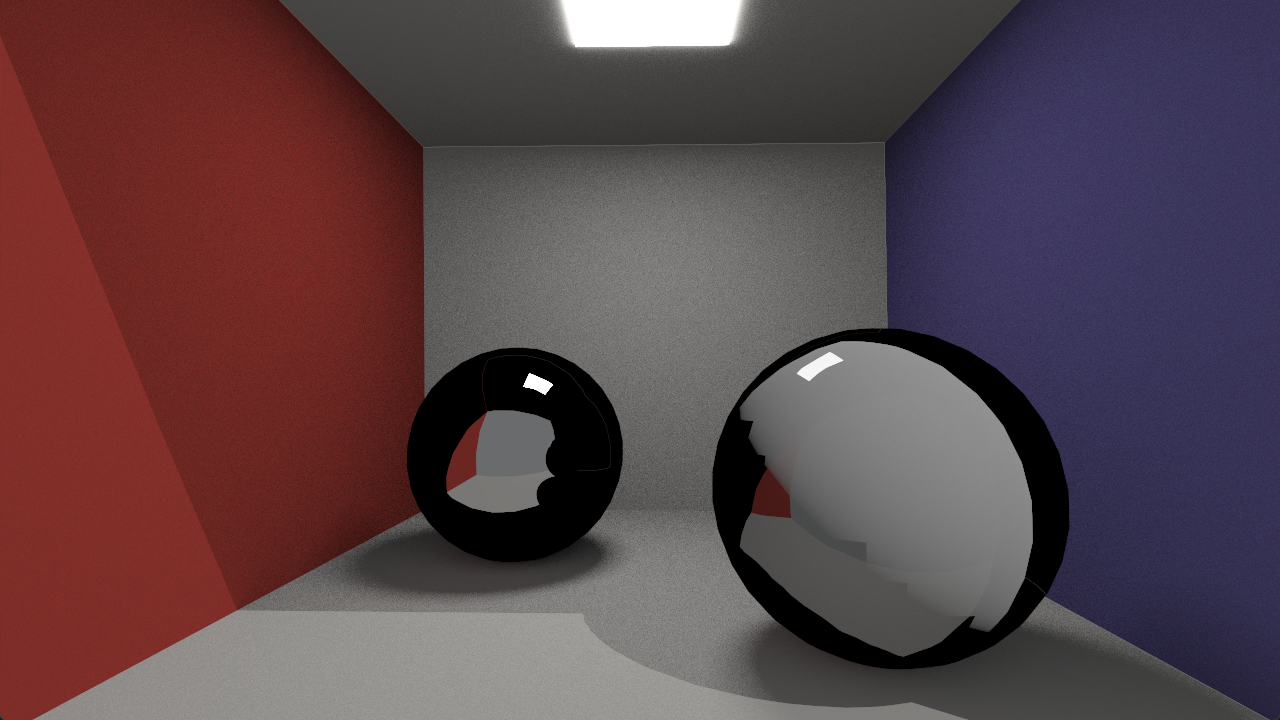

We will end the project with the conclusions that can be drawn from the results of our work, as well as show what could be done to improve the engine in the future. To summarize, we’ve found that the engine could improve its sampling stategy. The images it produces are very noisy and need a considerable amount of samples to become sharp. This is mainly due to the weak light interface that has been implemented, since it doesn’t take into account emissive materials found in the scene. Nevertheless, the combination of how fast it can render a frame and the ability to mix multiple accumulated frames over time manages to overcome this issue. Other areas that could be further improved include the material interface and the main engine class, which presents a high degree of coupling.

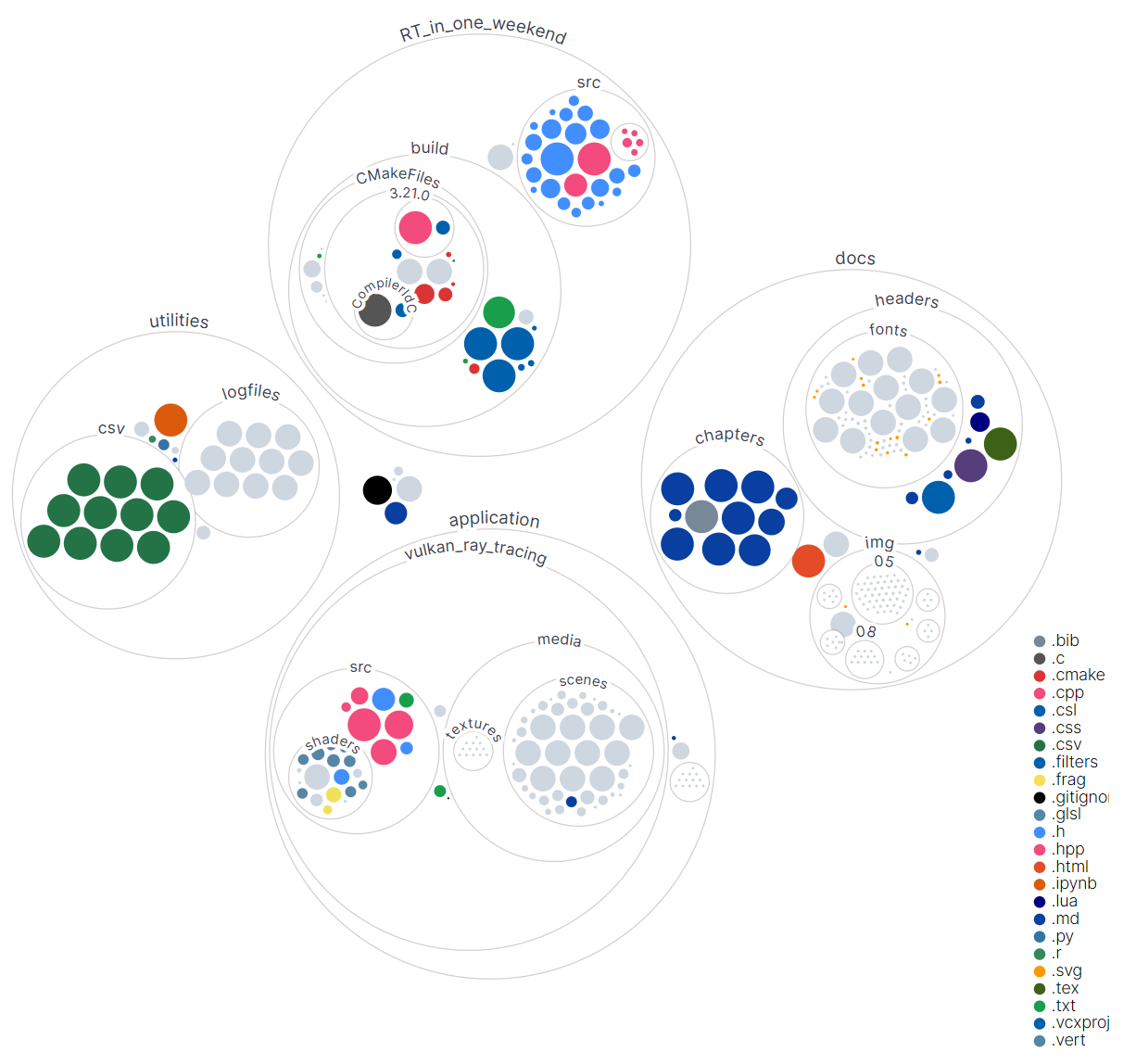

The contents of this document, the Vulkan project, an In One Weekend implementation, as well as other utilities can be found in the following repository:

https://github.com/Asmilex/Raytracing

Keywords: raytracing, ray tracing, path tracing, Monte Carlo methods, Monte Carlo integration, light transport, global illumination, Vulkan.

A mi familia por su apoyo constante y permitirme empezar una carrera que ni siquiera sabía que quería.

A Augusta, Blanca, Cristina, Jorge, José “OC”, Juan Antonio, Lucas, Manu “Nomad”, Mari, Marina, Mapachana, Paula, Sarah, y Sergio por el apoyo, así como por ayudarme con el contenido, feedback del desarrollo y diseño de la documentación.

Este trabajo puede visualizarse en la web asmilex.github.io/Raytracing o en el PDF disponible en el repositorio del trabajo github.com/Asmilex/Raytracing. La página web contiene recursos adicionales como vídeos.

Ser capaces de capturar un momento.

Desde tiempos inmemoriales, este ha sido uno de los sueños de la humanidad. La capacidad de retener lo que ven nuestros ojos comenzó con simples pinturas ruprestres que nuestros ancestros dejaron enmarcadas en las paredes de sus hogares.

Con el tiempo, la tecnología evolucionó; lo cual propició formas más realistas de representar la realidad. El físico árabe Ibn al-Haytham, a finales de los años 900, describió el efecto de la cámara oscura (Encyclopedia 2022), un efecto óptico mediante el cual se puede proyectar una imagen invertida en una pared. A inicios del siglo XVIII, Nicéphore Niépce consiguió arreglar una imagen capturada por las primeras cámaras. Era una impresión primitiva, por supuesto; pero funcional. A finales de este siglo, sobre los años 1890, la fotografía se extendió rápidamente en el espacio del consumidor gracias a la compañía Kodak. Finalmente, a mediados del siglo XX la fotografía digital, la cual simplificaría muchos de los problemas de las cámaras tradicionales.

Una vez entró de lleno la era digital, los ordenadores personales se volvieron una herramienta indispensable. Con ellos, los usuarios eran capaces de mostrar imágenes en pantalla, que cambiaban bajo demanda. Naturalmente, debido a nuestro afán por recrear el mundo, nos hicimos una pregunta: ¿Podríamos simular la vida real?

Como era de esperar, este objetivo es complicado de lograr. Para conseguirlo, hemos necesitado crear abstracciones de conceptos que nos resultan naturales, como objetos, luces y seres vivos. “Cosas” que un ordenador no entiende, y sin embargo, para nosotros funcionan. Así, nació la geometría, los puntos de luces, texturas, sombreados, y otros elementos de un escenario digital. Pero estas abstracciones por sí mismas no son suficientes. Necesitamos visualizarlas.

Para solventar este problema existen diferentes algoritmos. El más primitivo es rasterización, una técnica utilizada para convertir objetos tridimensionales de una escena en un conjunto de píxeles. Proyectando acordemente el entorno a una cámara, conseguimos colorear una región del espacio, de forma que en conjunto representan un punto de vista de un mundo digital. Su simplicidad lo convierte en una manera extraordinariamente rápida de conseguir una imagen. Sin embargo, su gran inconveniente es la fidelidad. Debido a su naturaleza (que se basa en una simple proyección), este algoritmo está extremadamente limitado. Para aumentar el realismo del producto final, con el tiempo se idearon métodos como shadow mapping, precómputo de luces, o reflection cubemaps, los cuales intentan solventar el problema subyacente de rasterización: conocer el entorno de la escena.

Como era de esperar, se buscaron vías alternativas a rasterización para producir una imagen. La que más destacó fue ray tracing. Su primer uso documentado data de los años 60, en un artículo de Appel (Freniere and Tourtellott 1997). Parte de una idea increíblemente simple: consiste en disparar un rayo desde una cámara para comprobar si un objeto está ocluído. De esta forma, se resuelve el problema de conocer qué es lo que se ve desde la cámara.

Un par de décadas más tarde, sobre 1980, comienzan a ser publicadas imágenes hechas por ray tracing muy realistas. En estos años también se experimenta un crecimiento en el número de publicaciones sobre cómo hacer más rápido ray tracing. Uno de los puntos clave fue reducir el tiempo requerido para calcular intersecciones con objetos, pues suponen hasta el 95% del cómputo total. Kay y Kajiya publican un tipo de estructura denominada bounding box que simplifica este problema de manera considerable.

En 1986 Kajiya introdujo la denominada rendering equation (Kajiya 1986). Esta es una ecuación que modela analíticamente la cantidad de luz de un cierto basándose en las propiedades del material y la luz que llega a dicho punto.

\[ L_o(p, \omega_o) = L_e(p, \omega_o) + \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \cos\theta_i\ d\omega_i} \]

Debido a la complejidad de esta ecuación, se diseñó un algoritmo denominado path tracing, el cual es capaz de estimar numéricamente su valor. Su idea principal se basa en hacer rebotar rayos por la escena una y otra vez, de forma que en cada impacto se adquiera nueva información.

Los métodos de Monte Carlo proliferaron debido a su fundamento teórico, el cual es idóneo para las diferentes formas de ray tracing. Estas técnicas se basan en el uso de muestras de alguna distribución para calcular un valor determinado. En este caso, aproximan el valor que toma la integral de la rendering equation. Comenzaron siendo utilizados en 1960 para el cálculo de la radiancia generada por los fotones en simulaciones físicas, por lo que transicionaron fácilmente a ray tracing.

A finales del siglo XX path tracing penetra de lleno en la industria. Numerosas empresas comienzan a desarrollar motores de renderizado basado en dicho algoritmo, abandonando así rasterización. Las productoras de cine empiezan a utilizar exclusivamente medios digitales para crear películas, una forma de crear arte nunca vista hasta la fecha.

La elegancia de path tracing reside en su naturaleza tan intuitiva. Pues claro que la respuesta a “¿Cómo simulamos fielmente una imagen en un ordenador?” es “Representando la luz de forma realista”. Gracias a la física sabemos que los fotones emitidos por las fuentes de iluminación se mueven por el espacio impactando en los diferentes objetos. Y, como ocurre a menudo, la respuesta a muchos de nuestros problemas ya existe en el mundo exterior. Aprendiendo sobre cómo funciona nuestro alrededor nos permitirá modelar nuevos mundos a nuestro gusto. De esta manera, podemos dejar atrás los hacks que utilizábamos en rasterización; no habrá necesidad de falsificar los efectos de iluminación, puesto que path tracing los solventa de manera natural.

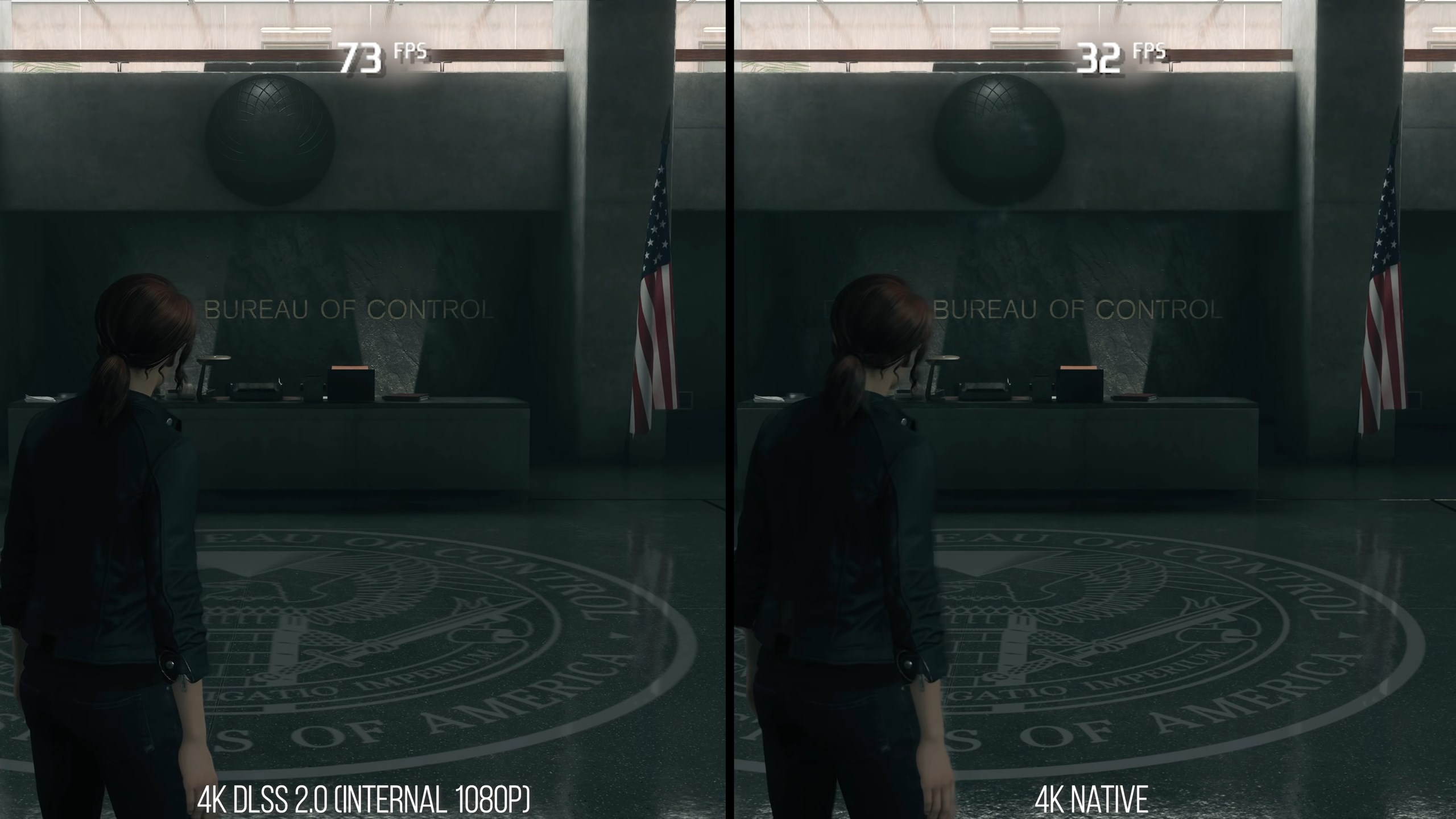

Aún con todos los avances del medio, el elefante en la sala seguía siendo el rendimiento. Producir una única imagen podría suponer horas de cómputo; incluso días. A diferencia del universo, nosotros no podemos permitirnos el lujo de usar un elevado número de fotones, ni hacer rebotar la luz tantas veces como queramos. Nos pasaríamos una eternidad esperando. Y para ver una imagen en nuestra pantalla necesitaremos estar vivos, claro. En la práctica, esto supuso que no todos los medios pudieron pasarse a path tracing. Aquellas industrias como la de los videojuegos, en las que se prioriza la rapidez sobre fidelidad tuvieron que continuar usando rasterización. A fin de cuentas, solo disponen de unos escasos milisegundos para renderizar una imagen.

Sin embargo, el paso del tiempo es imparable. Las pinturas rupestres dieron paso al óleo sobre lienzo, mientras que las cámaras digitales reemplazaron a las oscuras. Es natural esperar que, en algún momento, rasterización se convierta en un algoritmo del pasado. Y ese momento es la actualidad.

En 2018 Nvidia introdujo la arquitectura de tarjetas gráficas Turing (Emmett Kilgariff 2018). Aunque por estos años ya existían implementaciones de ray tracing en gráficas (tan temprano como (Purcell et al. 2002), (Ertl et al. 2022)), esta arquitectura presenta la capacidad de realizar cómputos específicos de ray tracing acelerados por hardware en gráficas de consumidor. Esto significa que path tracing se vuelve viable en tiempo real. En lugar de horas, renderizar una imagen costará milisegundos.

Se da el pistoletazo de salida a una nueva transición.

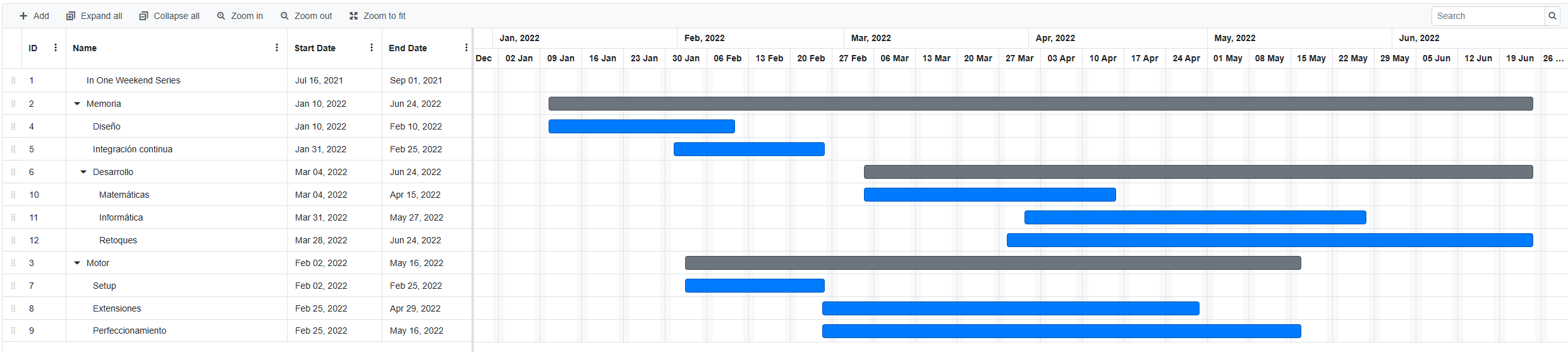

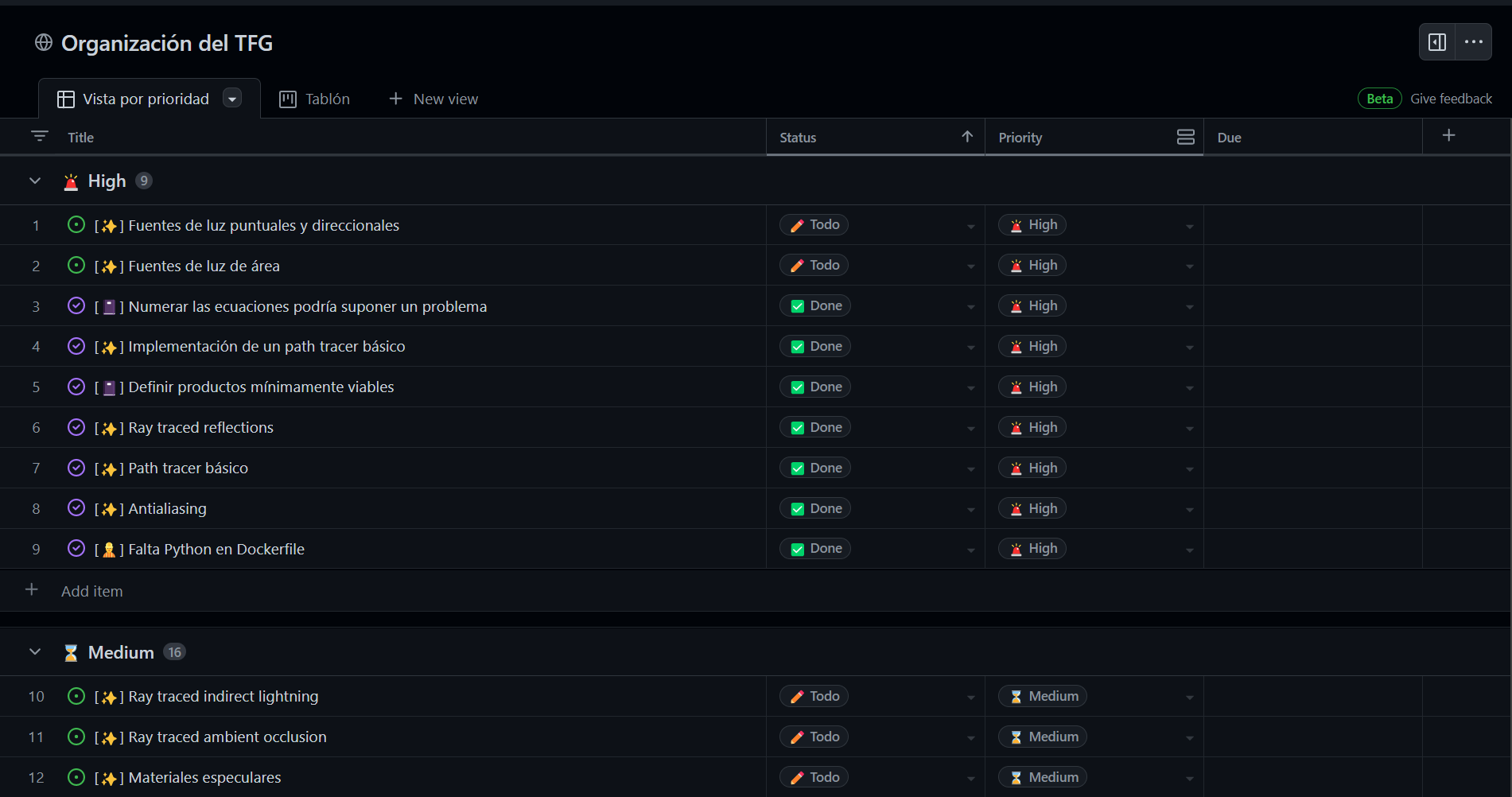

En este trabajo se estudiarán los fundamentos de ray tracing y path tracing en tiempo real. Para conseguirlo, se han propuesto los siguientes objetivos:

Afortunadamente, se ha conseguido realizar exitosamente cada uno de los objetivos. Esta memoria cubrirá todo el trabajo que ha sido necesario realizar para lograrlo.

Esta memoria recapitulará todas las técnicas utilizadas para resolver el problema propuesto. En los primeros capítulos, estudiaremos los fundamentos teóricos, mientras que en los posteriores construiremos una implementación de ray tracing, la cual analizaremos con detalle para finalizar.

El capítulo 1 sentará las bases de ray tracing: qué es un rayo exactamente, cómo podemos representarlo matemáticamente y cuáles son las ecuaciones que nos permiten modelar la propagación e impacto con diferentes objetos.

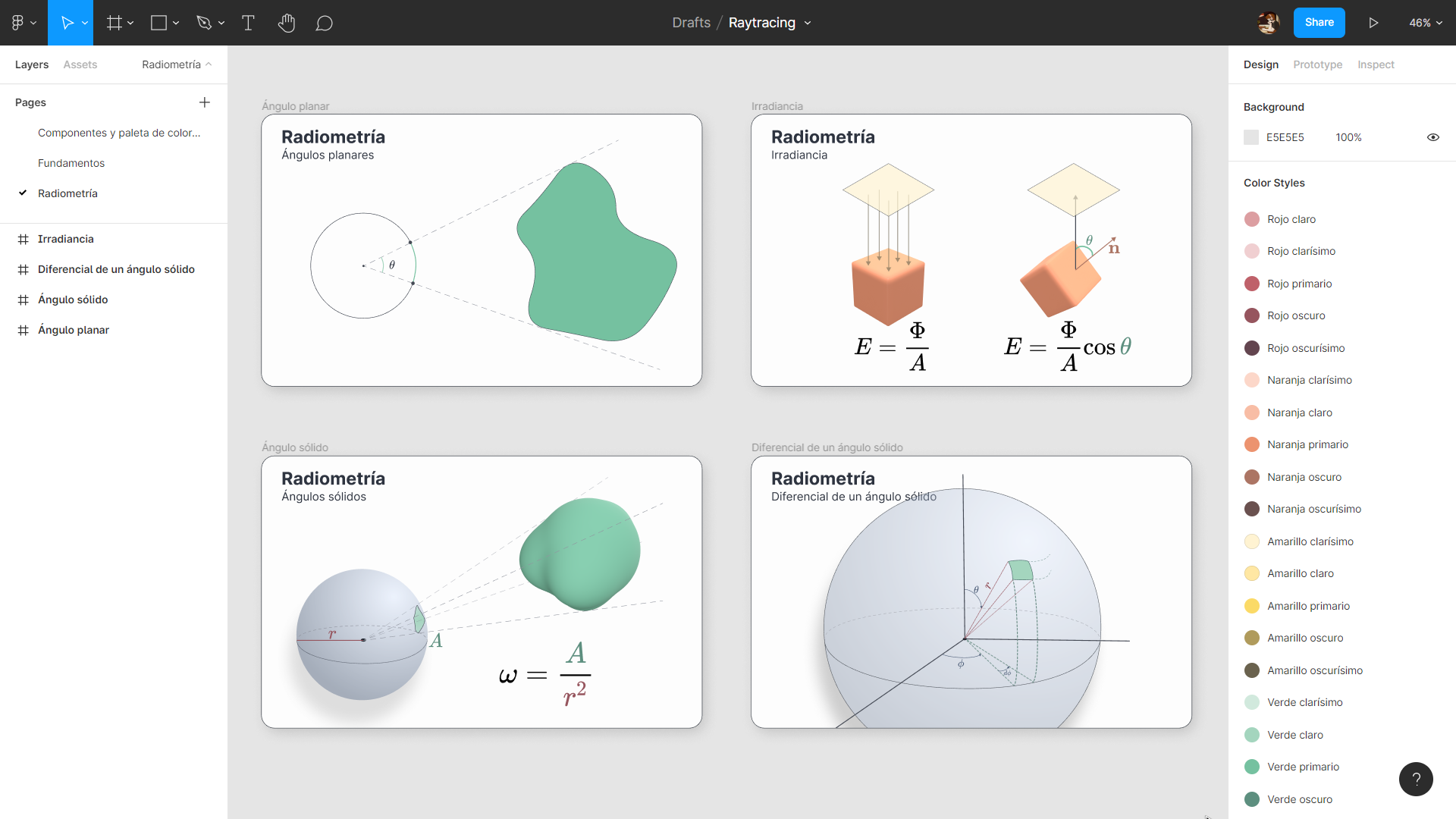

En el capítulo 2 introduciremos los fundamentos de la radiometría y el transporte de luz, el área de la física que se encarga de la interacción entre la luz y la materia. Estudiaremos cómo funcionan los fotones, cómo son emitidos desde las denominadas fuentes de iluminación, y cómo se propagan por el medio. Para conseguirlo, necesitaremos construir ciertas abstracciones que representen propiedades radiométricas. Entre las más importantes se encuentran la potencia, la intensidad radiante y la radiancia. También será necesario el concepto de ángulos sólidos, los cuales generalizan la concepción clásica de ángulo planar.

Será entonces cuando aprendamos cómo interacciona la luz con la materia. Esto nos llevará a crear una familia específica de funciones denominadas bidirectional distribution functions, las cuales describen como se reflejan los fotones cuando impactan con una superficie. Asimismo, será importante conocer la dirección de salida de estos, por lo que habrá que estudiar los fenómenos de reflexión y refracción. Al final del capítulo obtendremos la ecuación del transporte de luz o rendering equation.

Esta ecuación modela fielmente cuánta luz existe en un punto dependiendo de su entorno. Sin embargo, es prácticamente imposible resolverla analíticamente. Por ello, con el fin de poder realizar los cálculos en tiempo real, en el capítulo 3 exploraremos las técnicas de Monte Carlo. Estas técnicas se basan en el uso de muestreo aleatorio. A partir de promediar muestras de una variable aleatoria seremos capaces de determinar, primero, la media de una transformación de una v.a.; y después, el valor de una integral. Esto nos permitirá estimar el valor de la ecuación del transporte de luz.

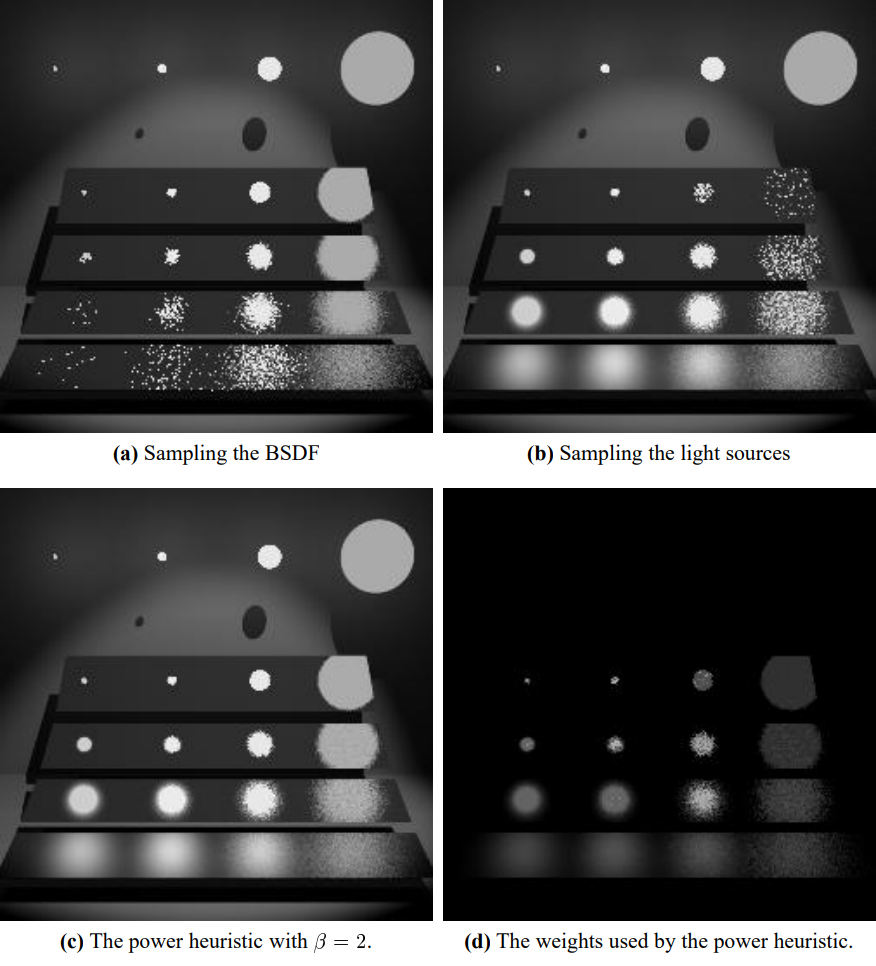

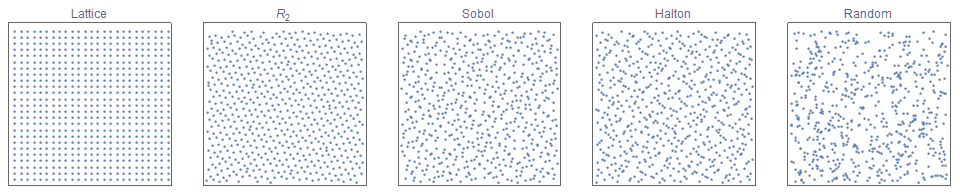

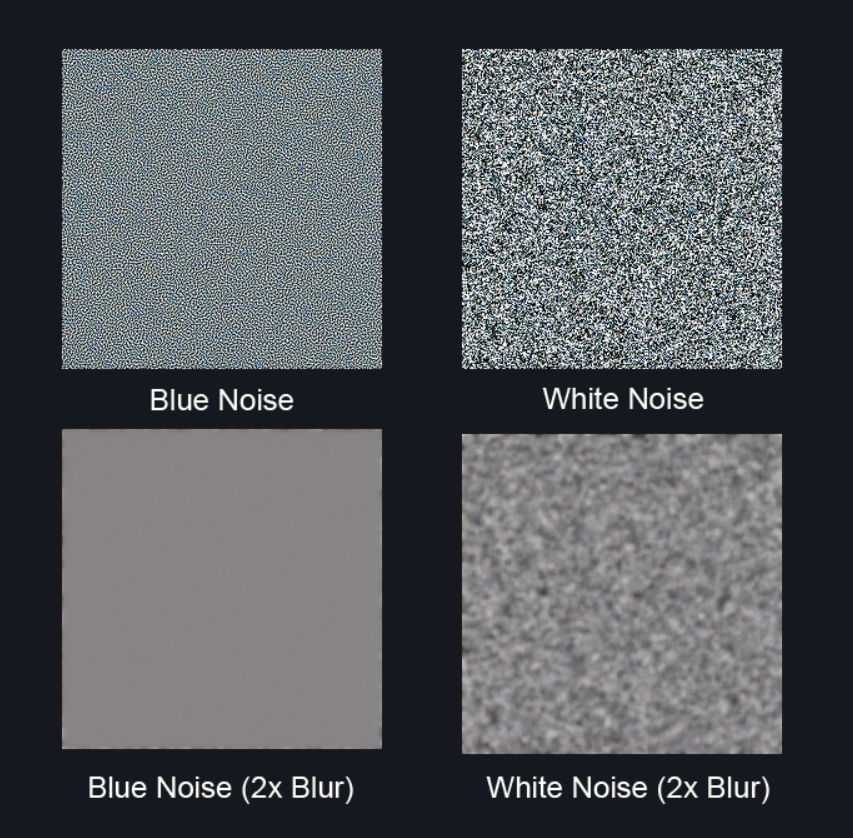

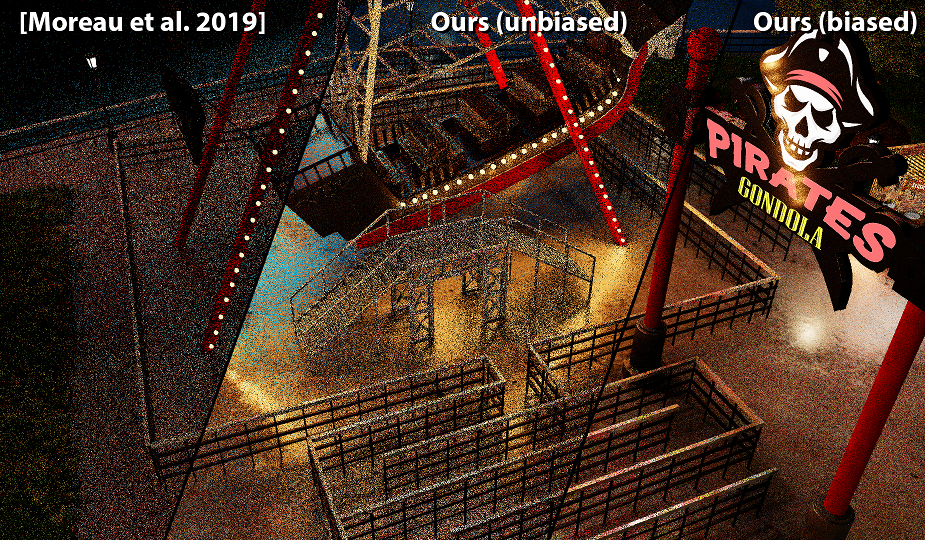

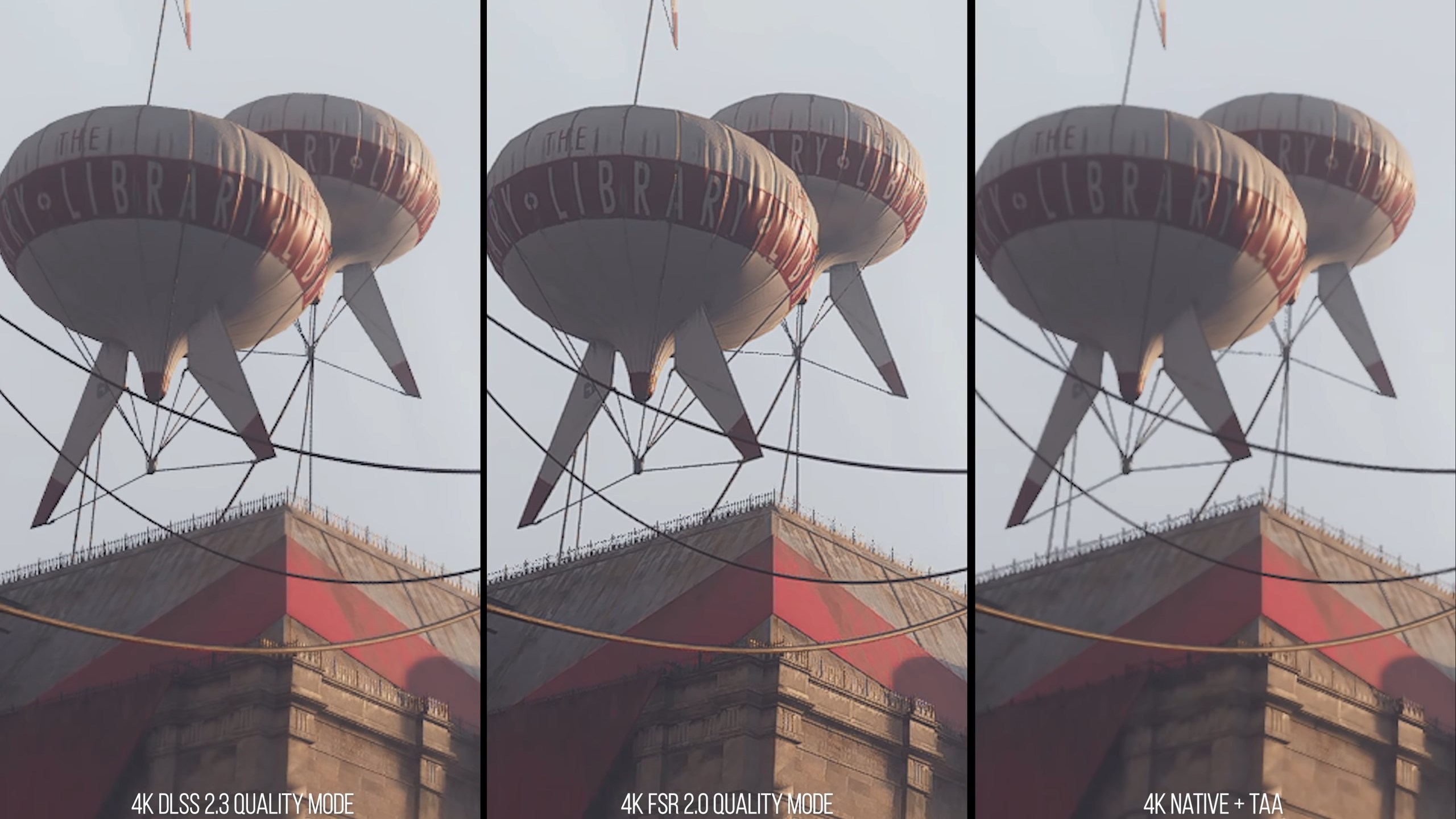

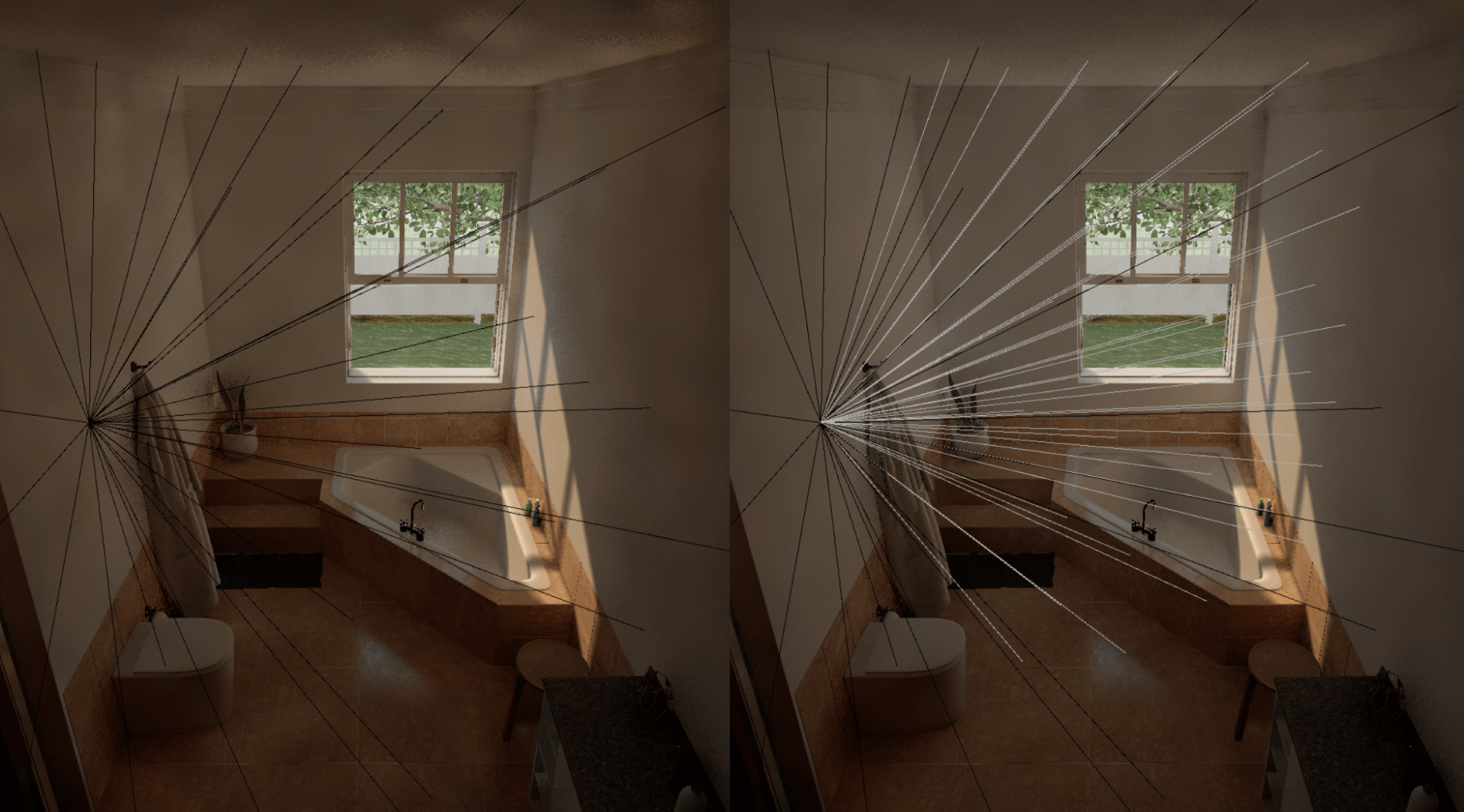

Sin embargo, muestrear sin cabeza no producirá resultados especialmente buenos. Por ello, comprobaremos cómo algunas técnicas reducen la varianza del estimador de Monte Carlo; y con ello, el ruido de la imagen final. Entre los métodos estudiados se encuentran el muestreo (múltiple) por importancia, la ruleta rusa, el muestreo directo de fuentes de iluminación o los métodos de Quasi-Monte Carlo. Todos estos los acabaremos enfocando al área que estamos explorando.

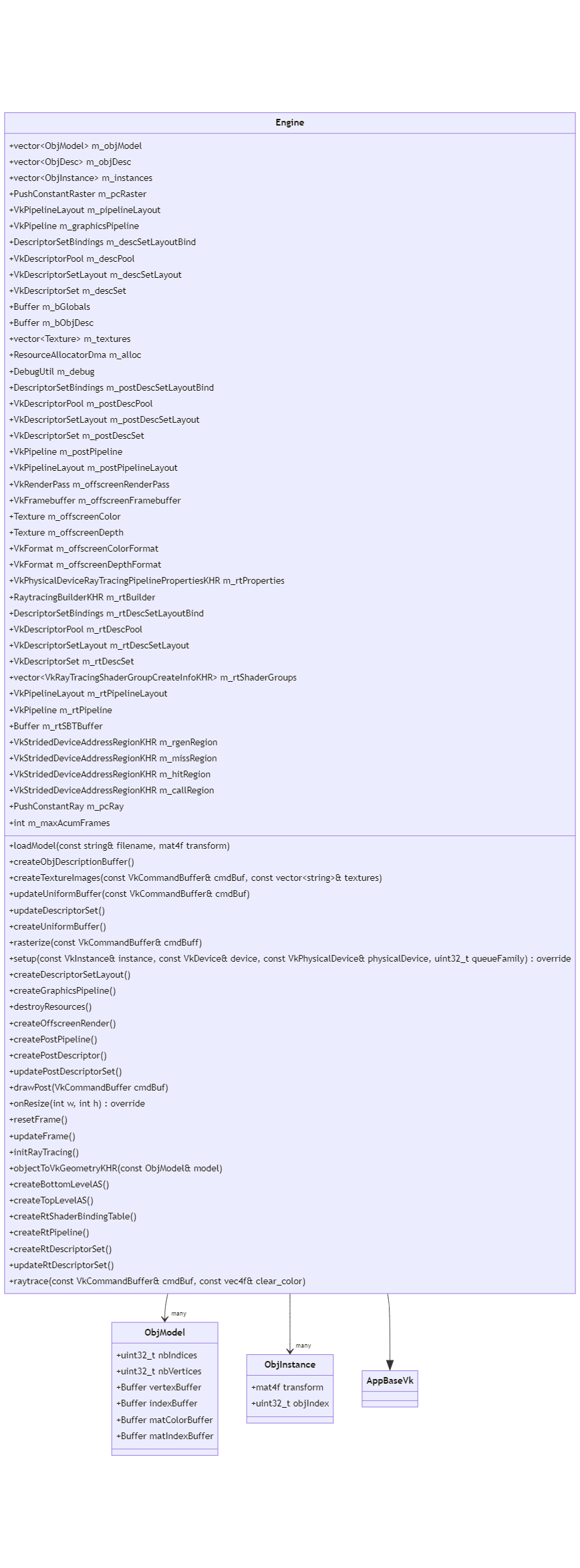

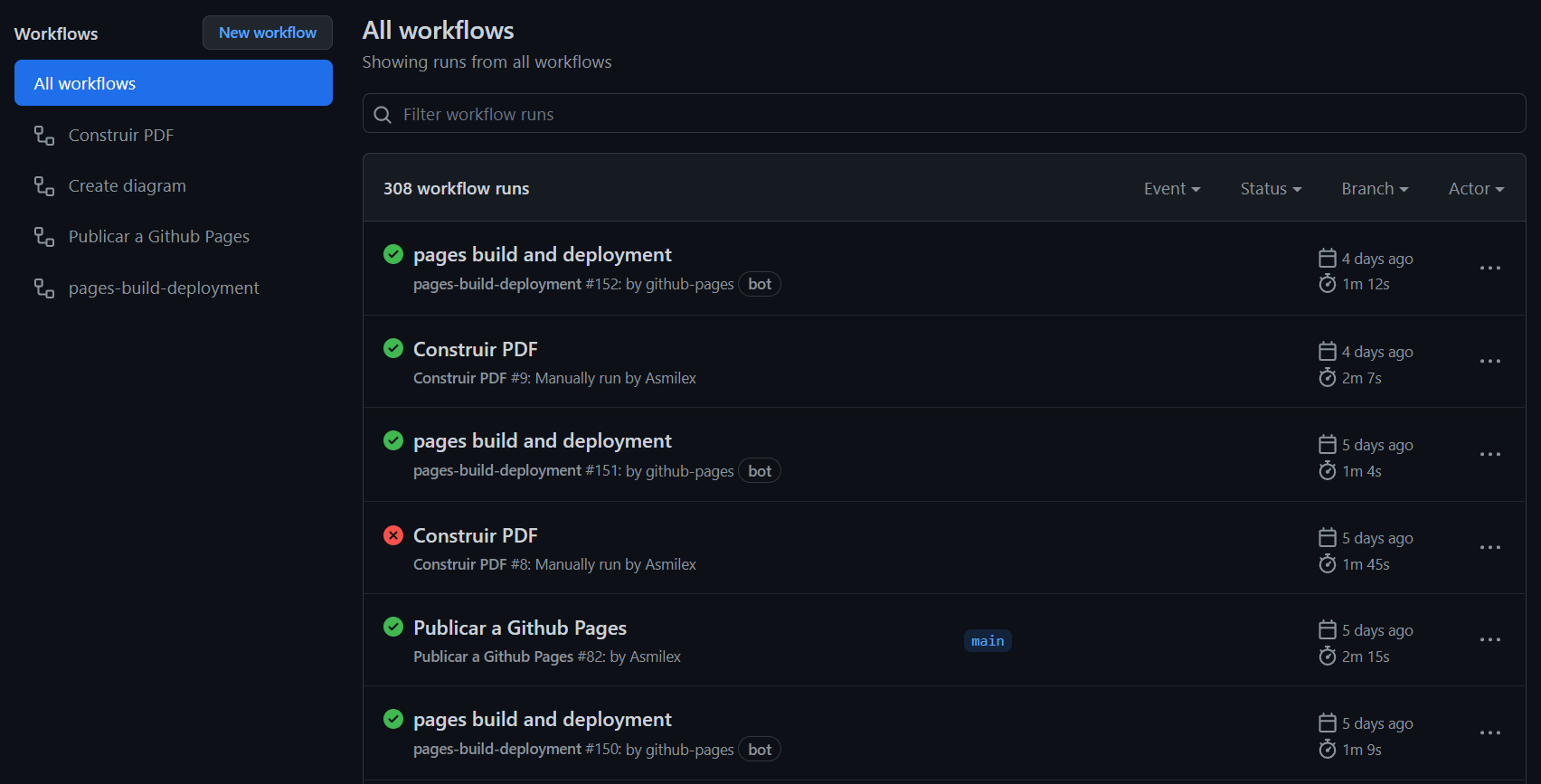

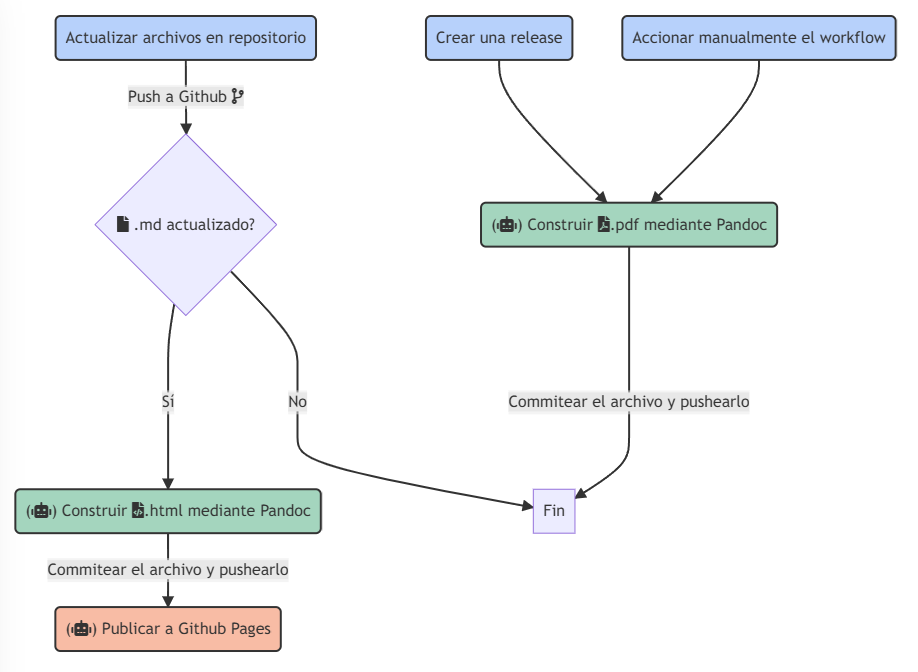

Cuando hayamos acabado con la teoría física y matemática, será el momento de producir la aplicación. El capítulo 4 cubirá la construcción de un motor de renderizado físicamente realista. Presentaremos algunas herramientas clave en la resolución del problema; entre las que se encuentran Vulkan, una interfaz de programación de aplicaciones gráfica, y el framework para Vulkan Ray tracing de Nvidia DesignWorks denominado nvpro-samples (NVIDIA 2022a).

Debido a la gran complejidad del problema, será necesario introducir algunas estructuras clave que habilitan la ejecución de ray tracing en tiempo real. Las dos más destacables son la Top y Bottom-Level Acceleration Structures (TLAS y BLAS, respectivamente), que albergan información sobre la geometría de una escena; y la Shader Binding Table (SBT), una estructura que permite seleccionar shaders dinámicamente a partir de la intersección de los rayos.

Será entonces cuando hablemos de cómo funciona la ray tracing pipeline, qué tipos de shaders existen y cómo podemos usarlos para renderizar una escena. Además, hablaremos sobre cómo hemos representado los materiales y las fuentes de iluminación. Finalmente, veremos algunas técnicas adicionales que hemos usado para reducir el ruido de la imagen, como la corrección de gamma y acumulación temporal de frames.

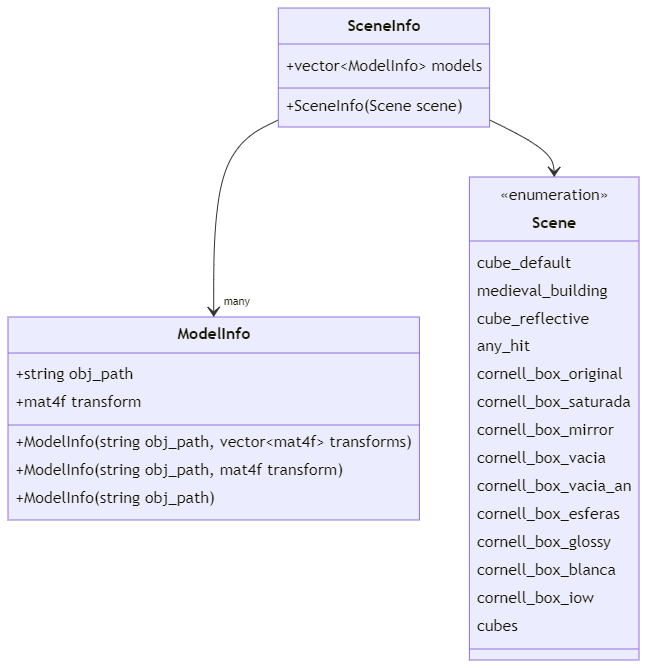

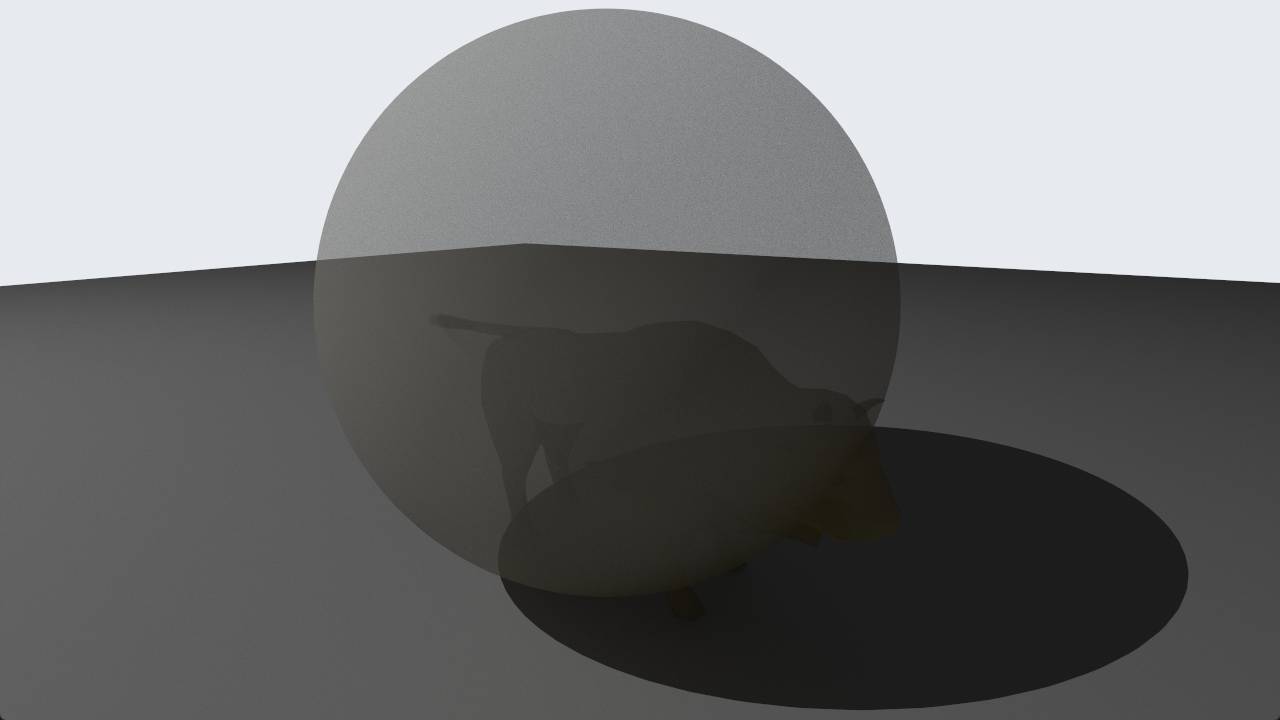

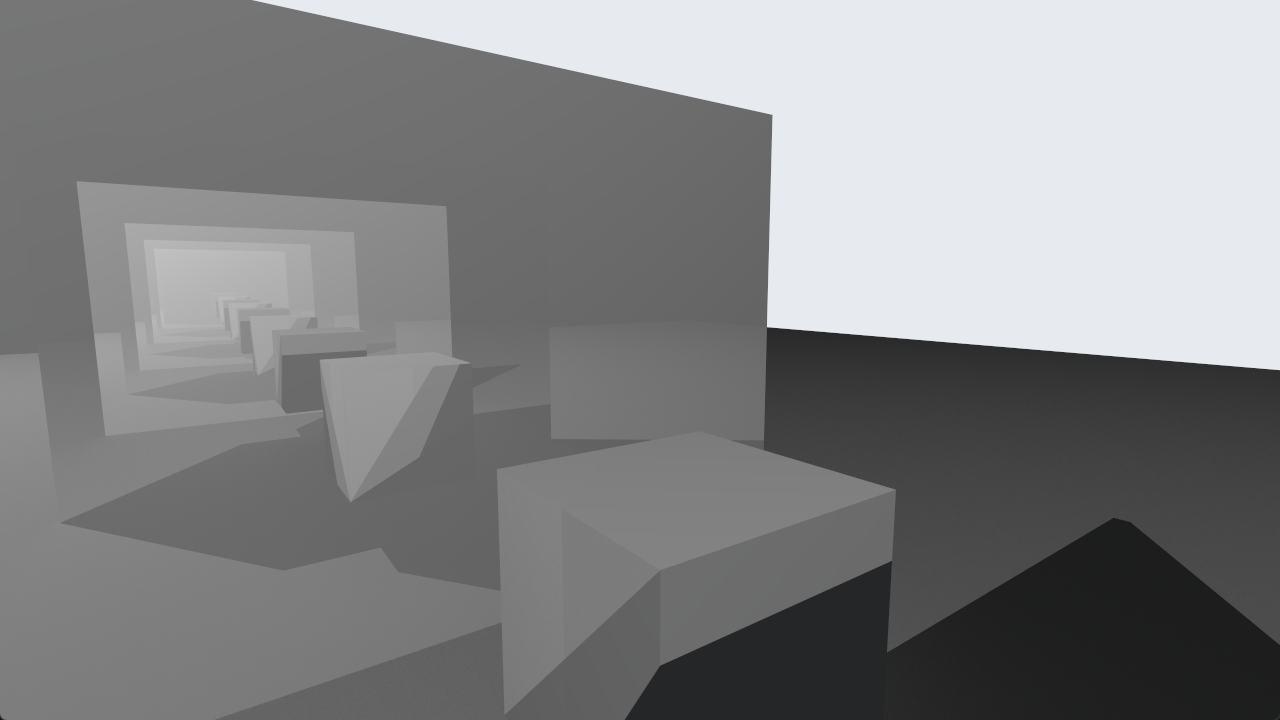

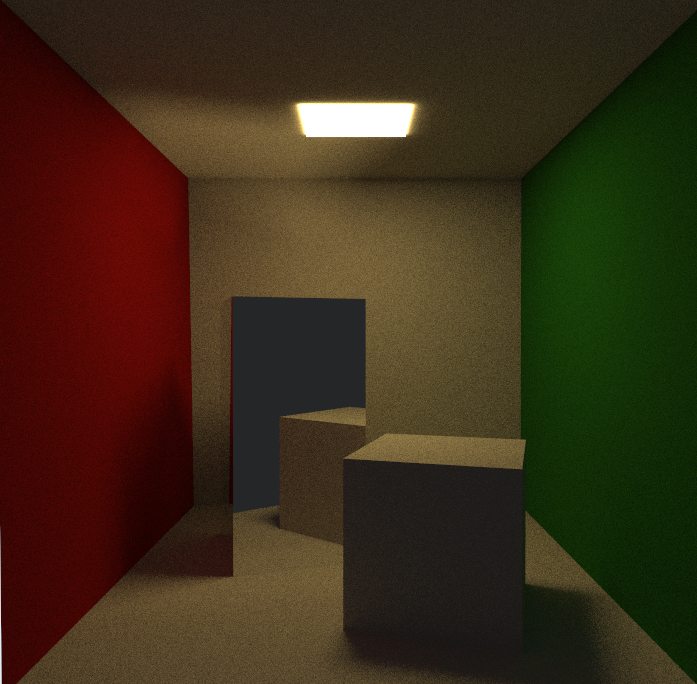

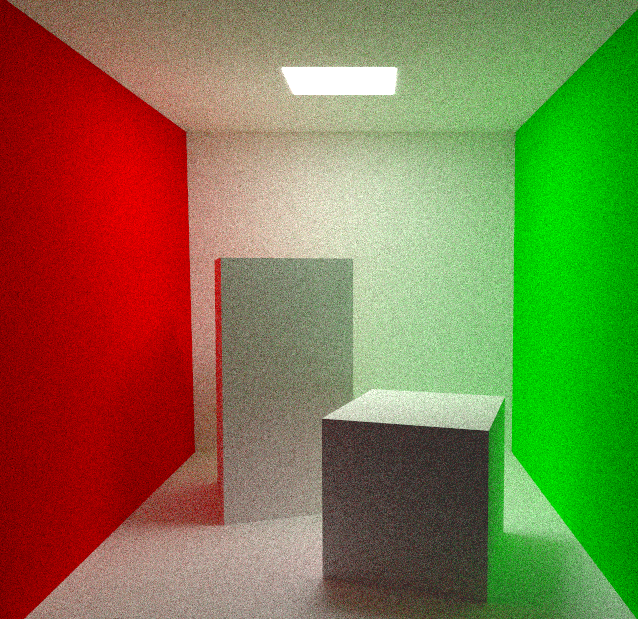

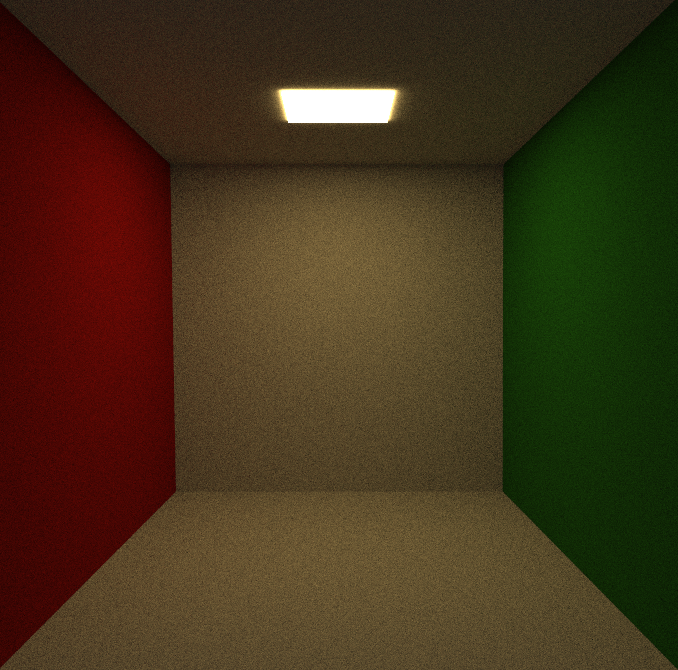

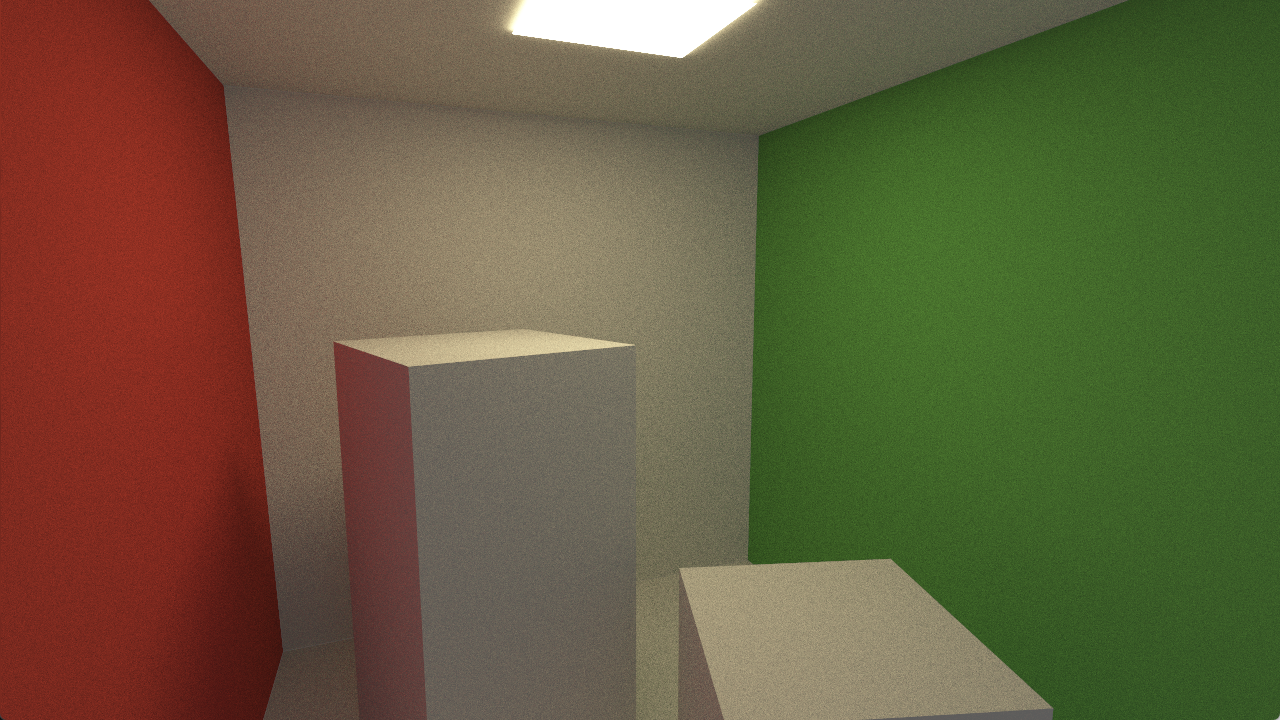

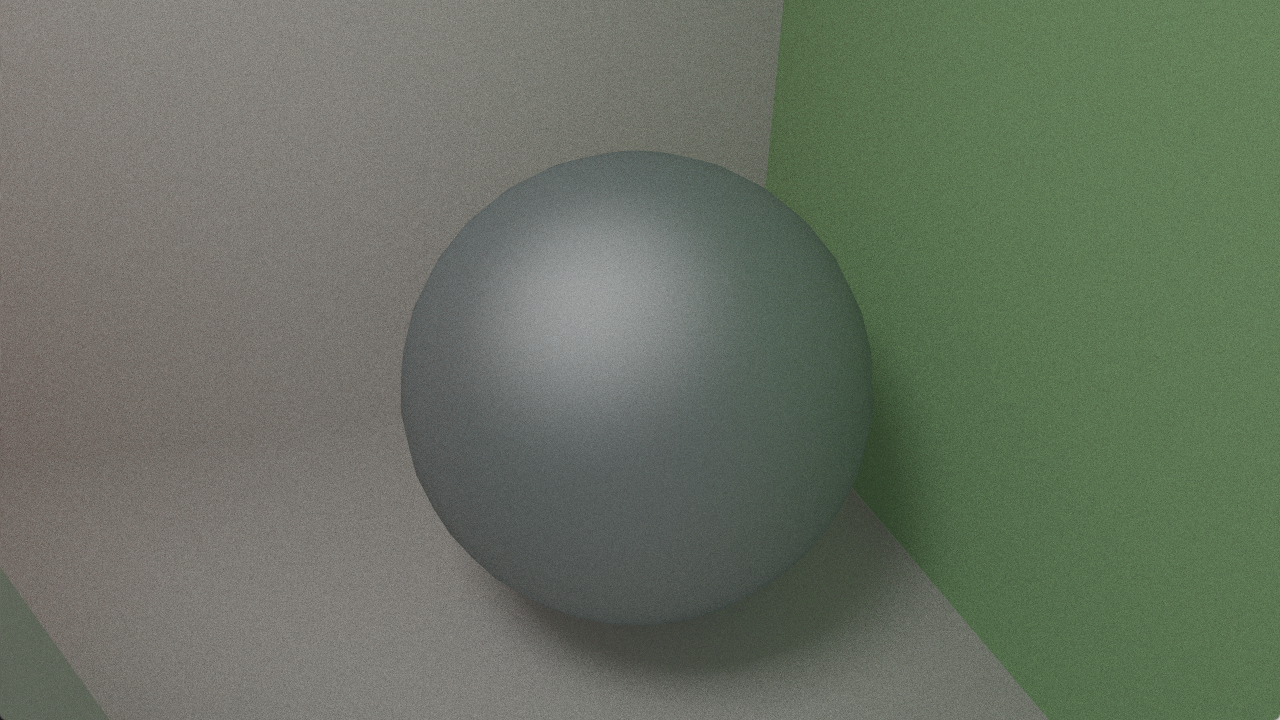

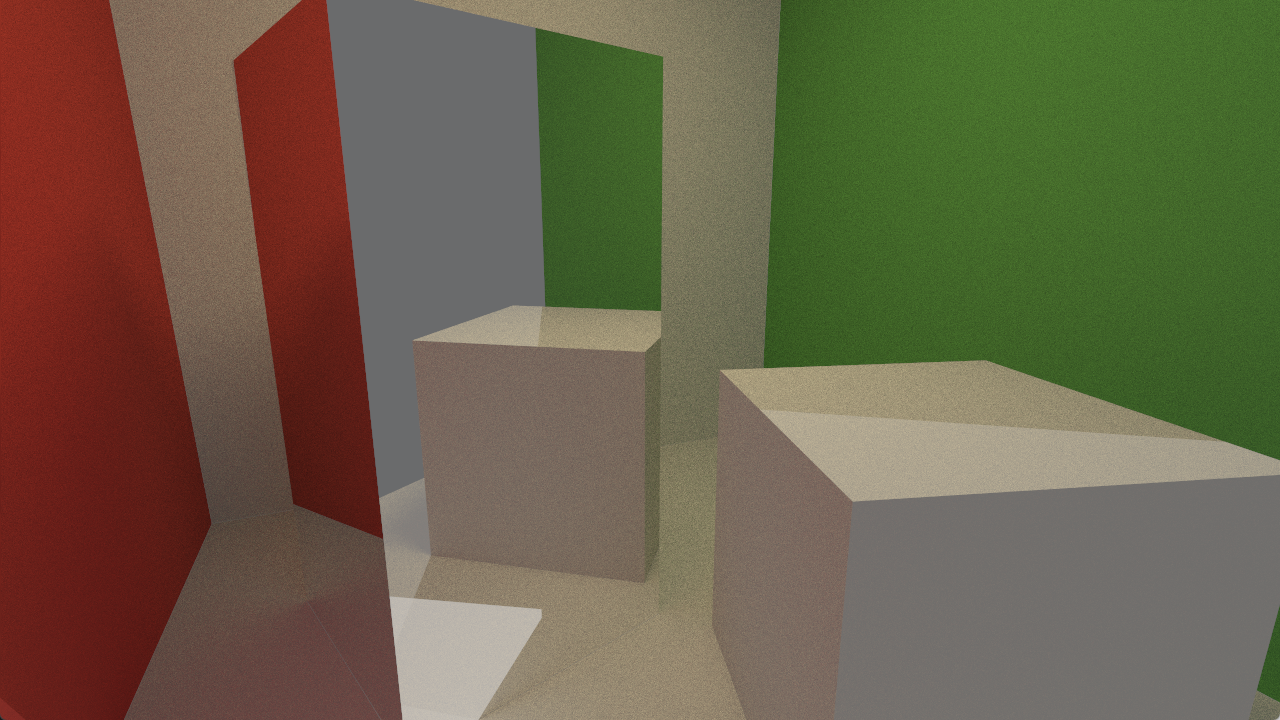

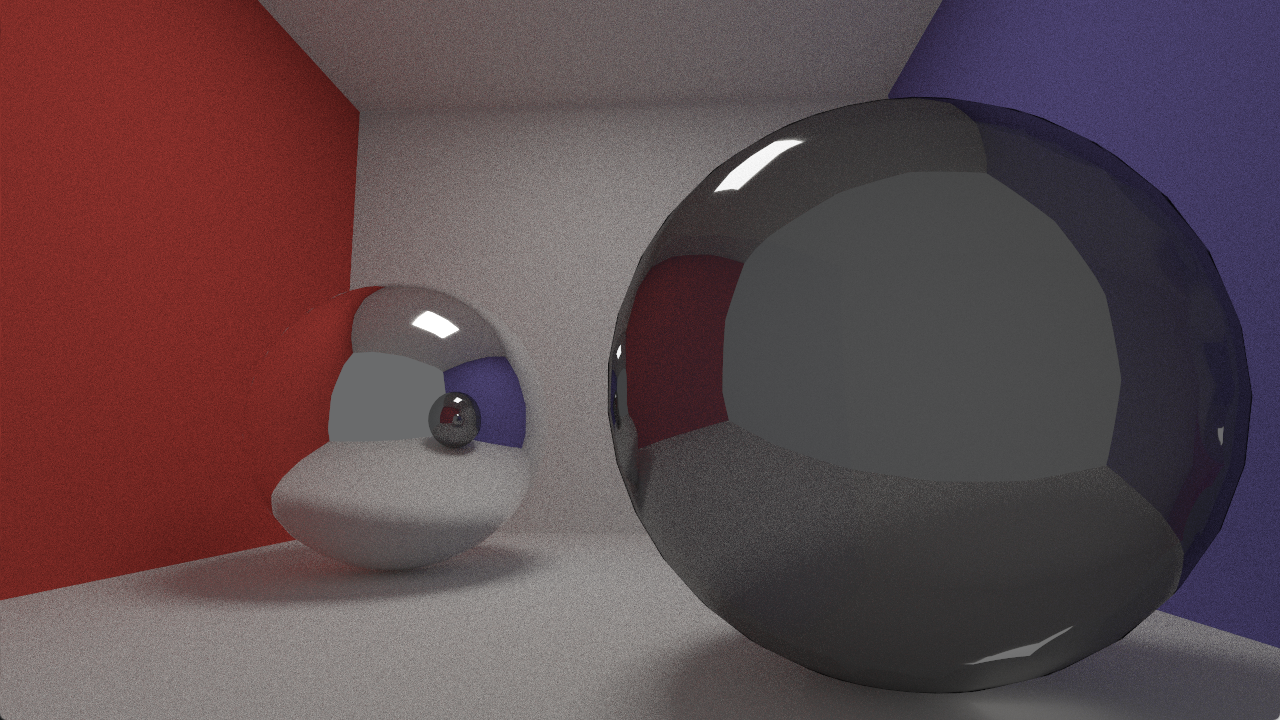

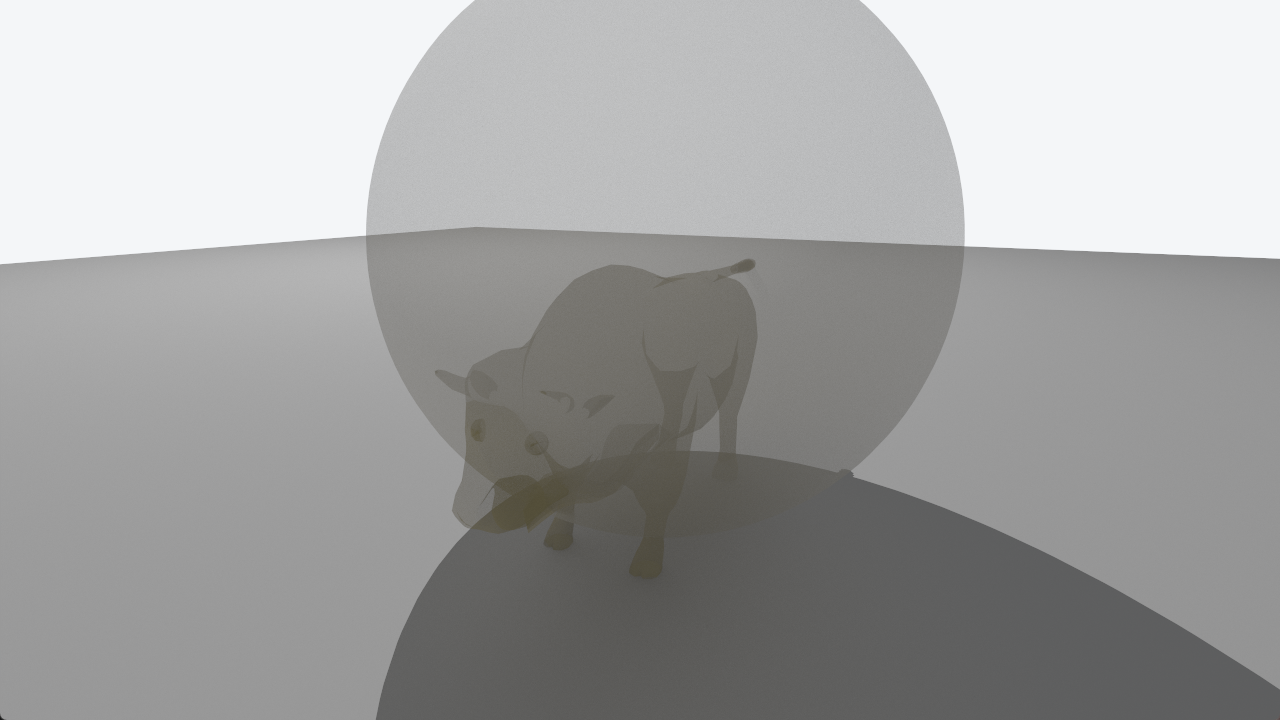

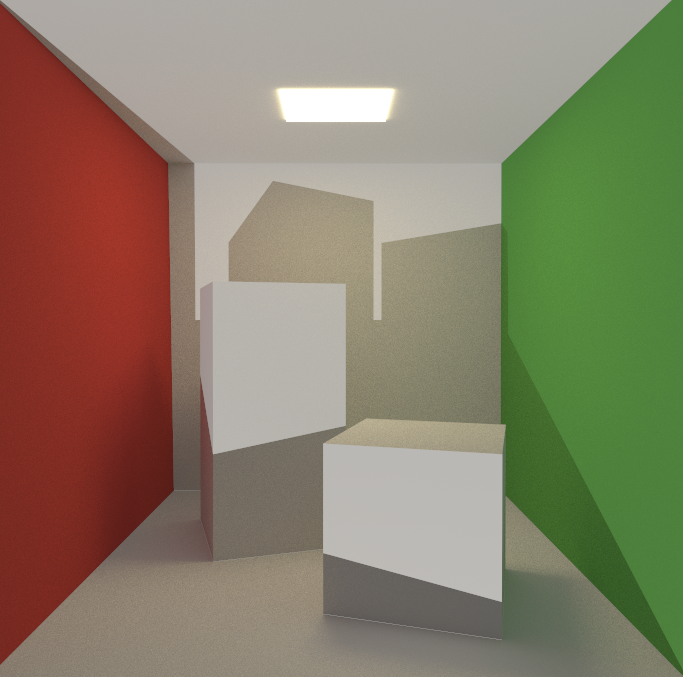

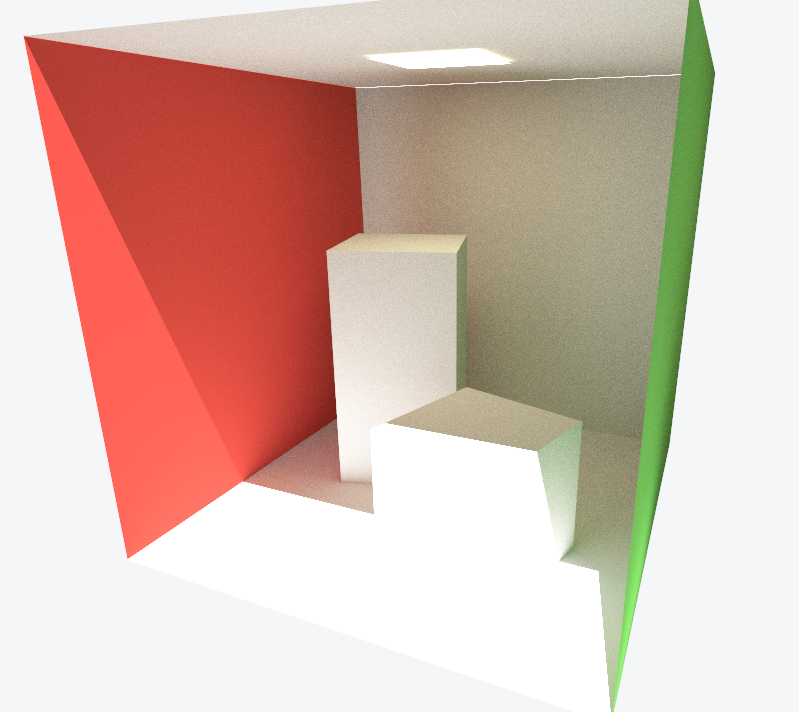

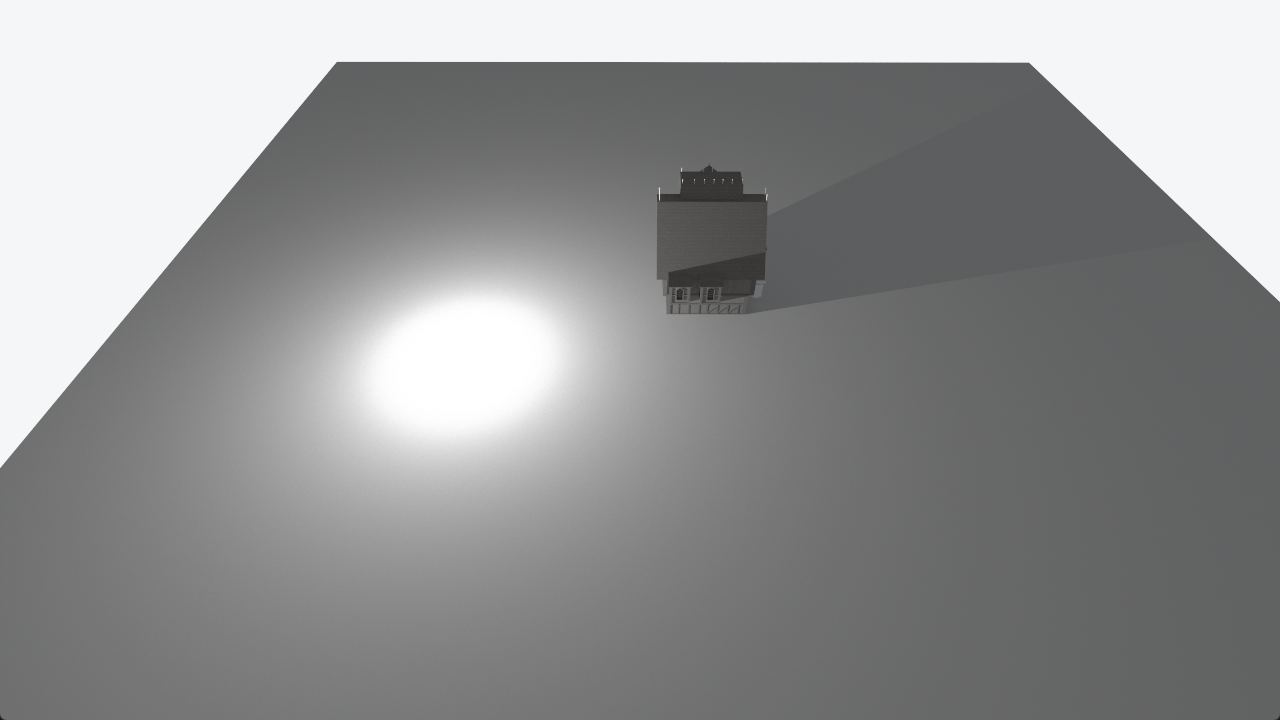

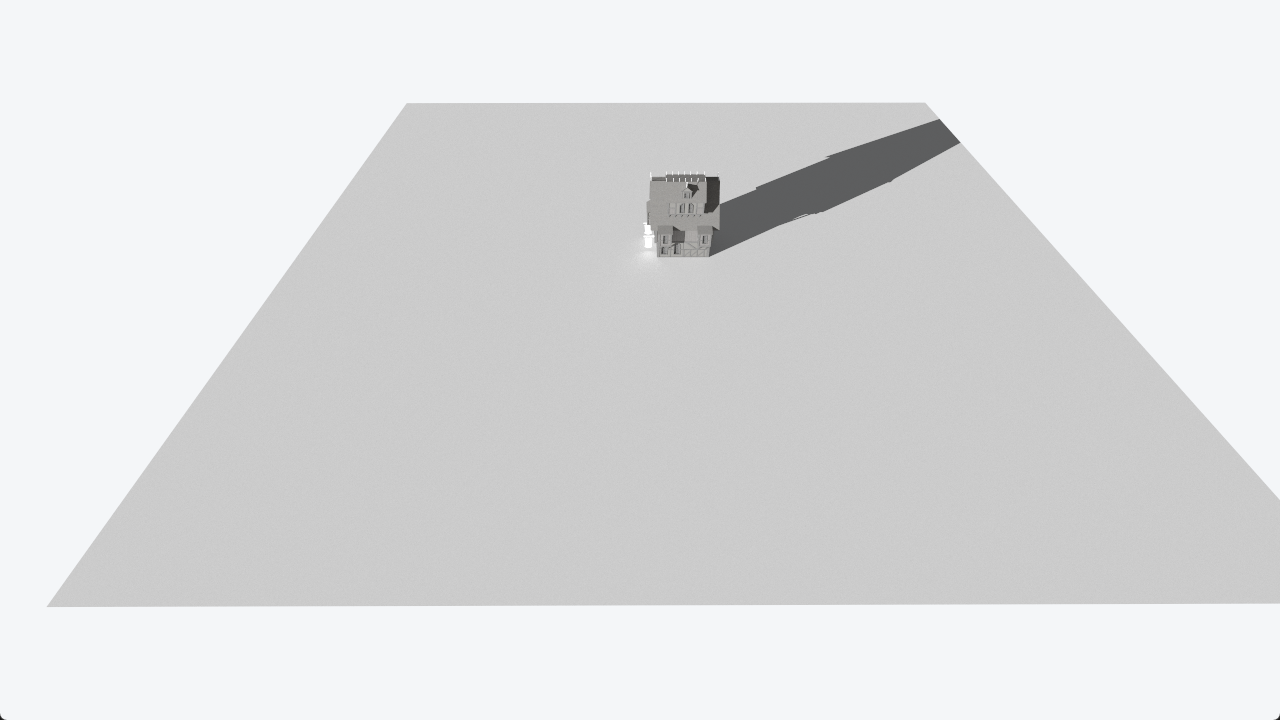

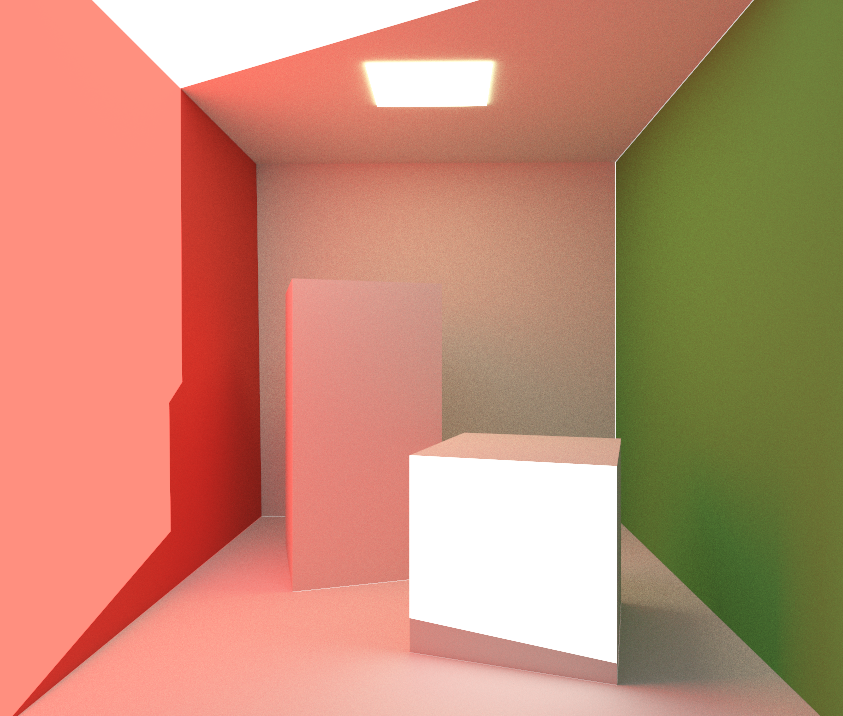

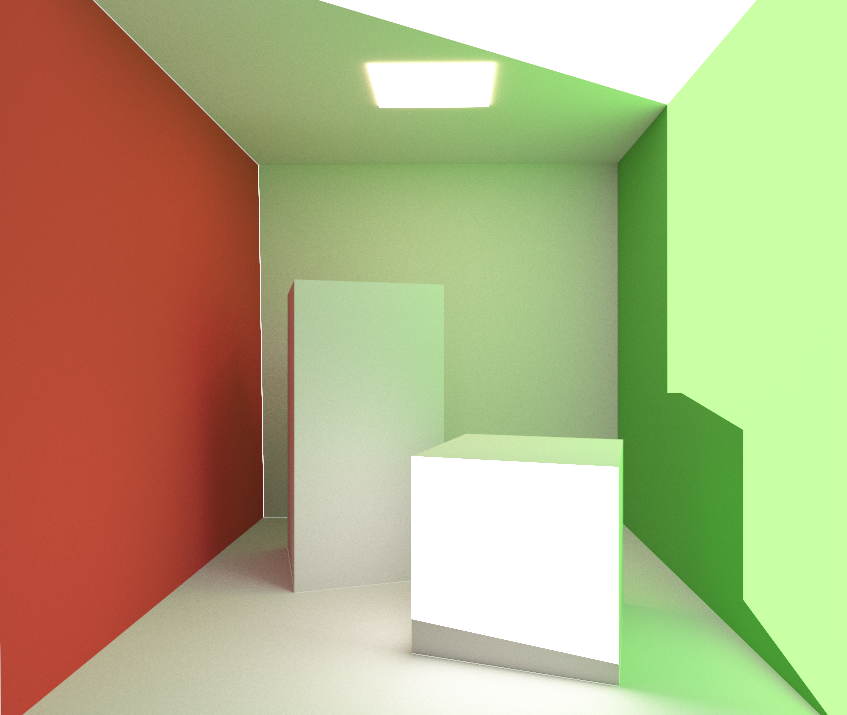

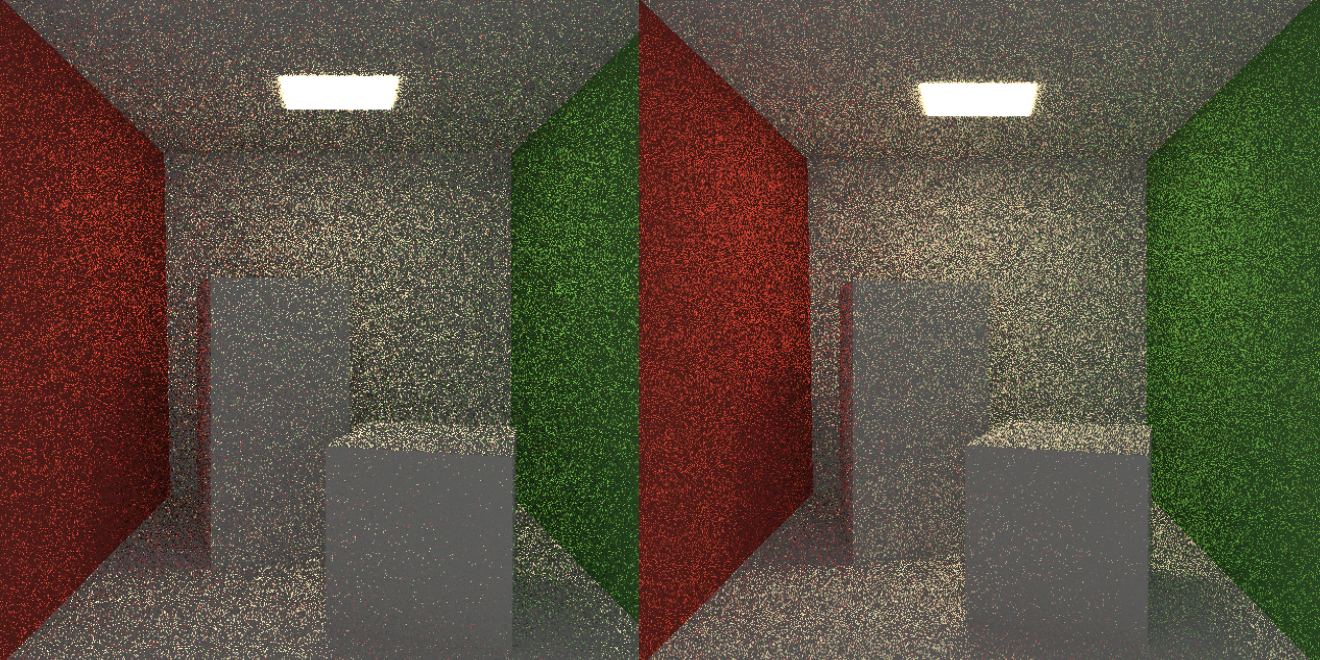

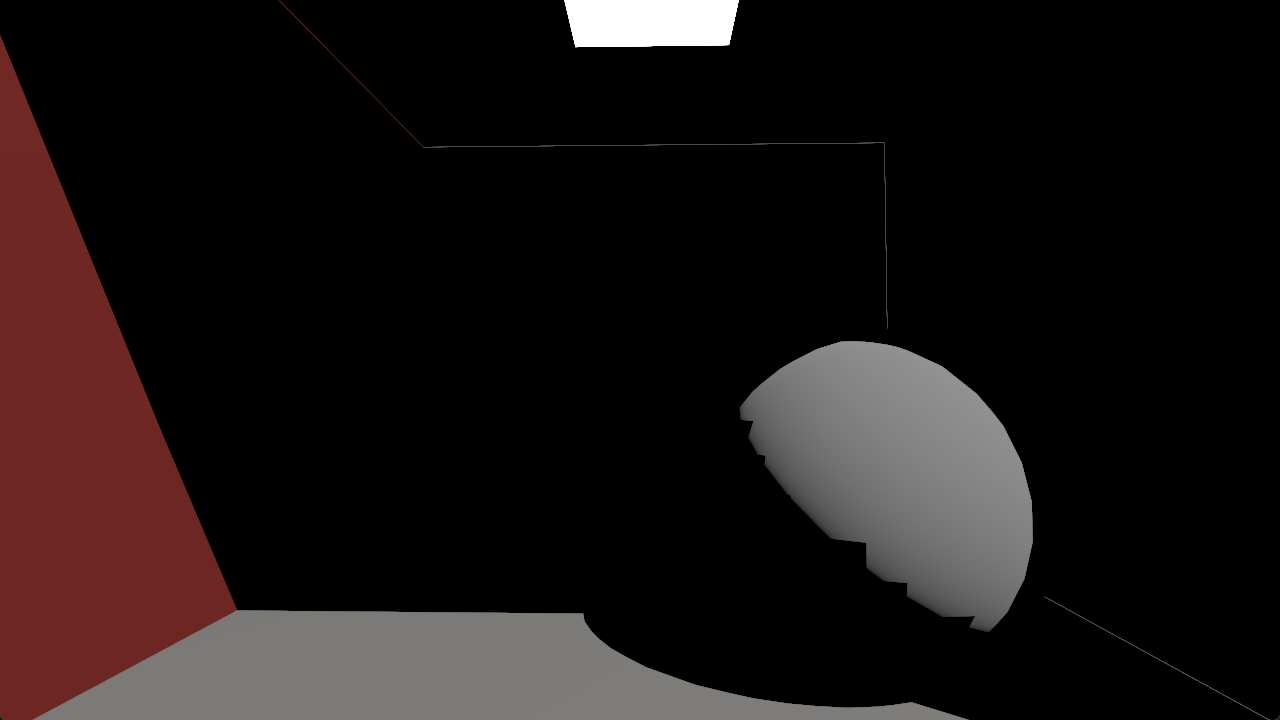

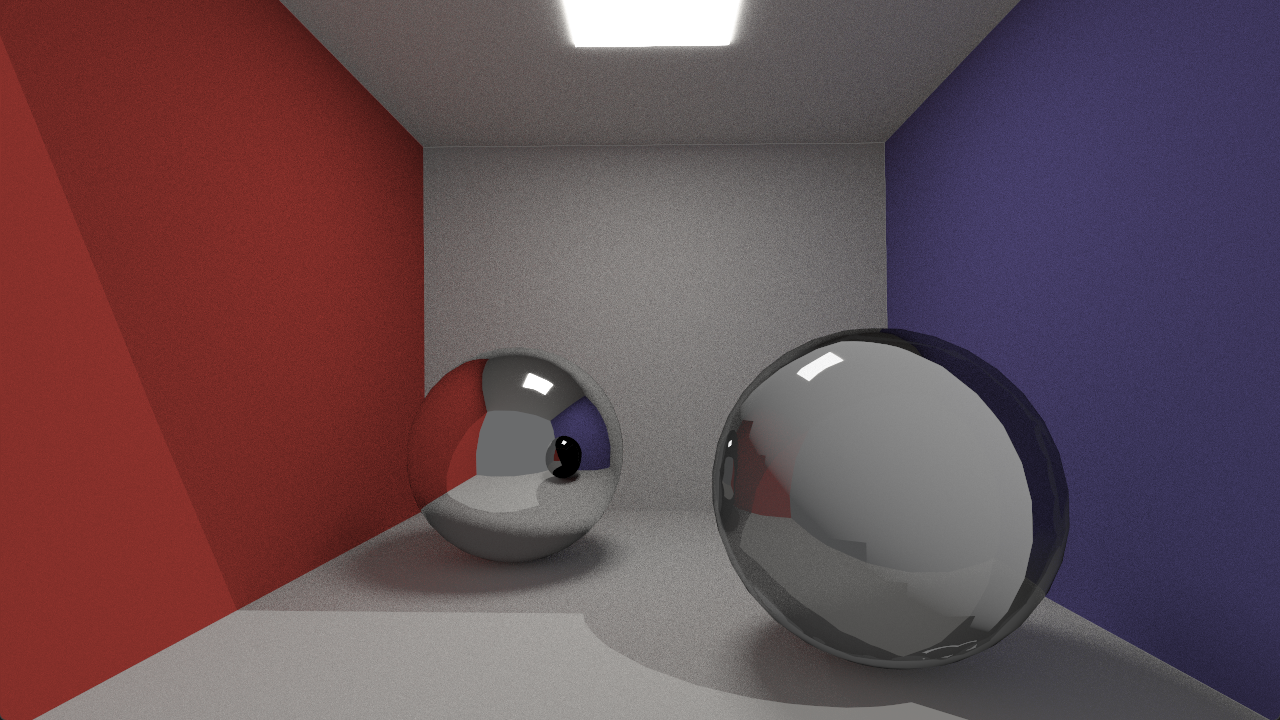

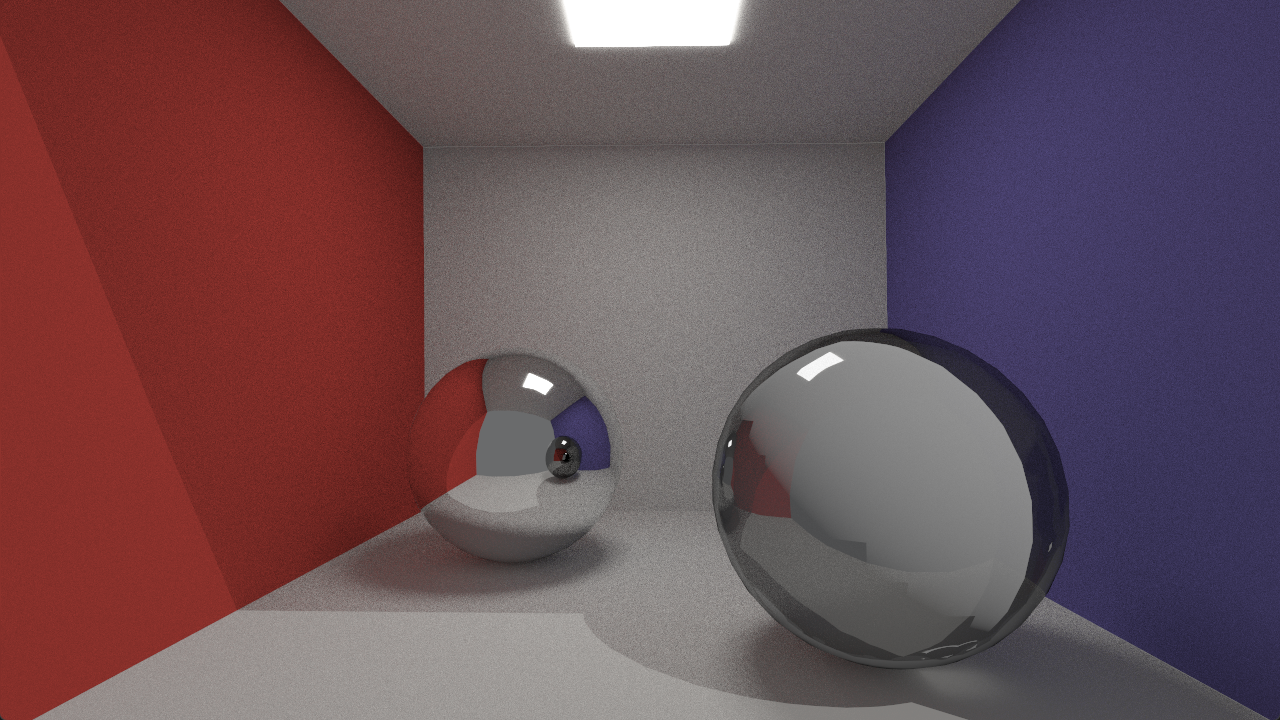

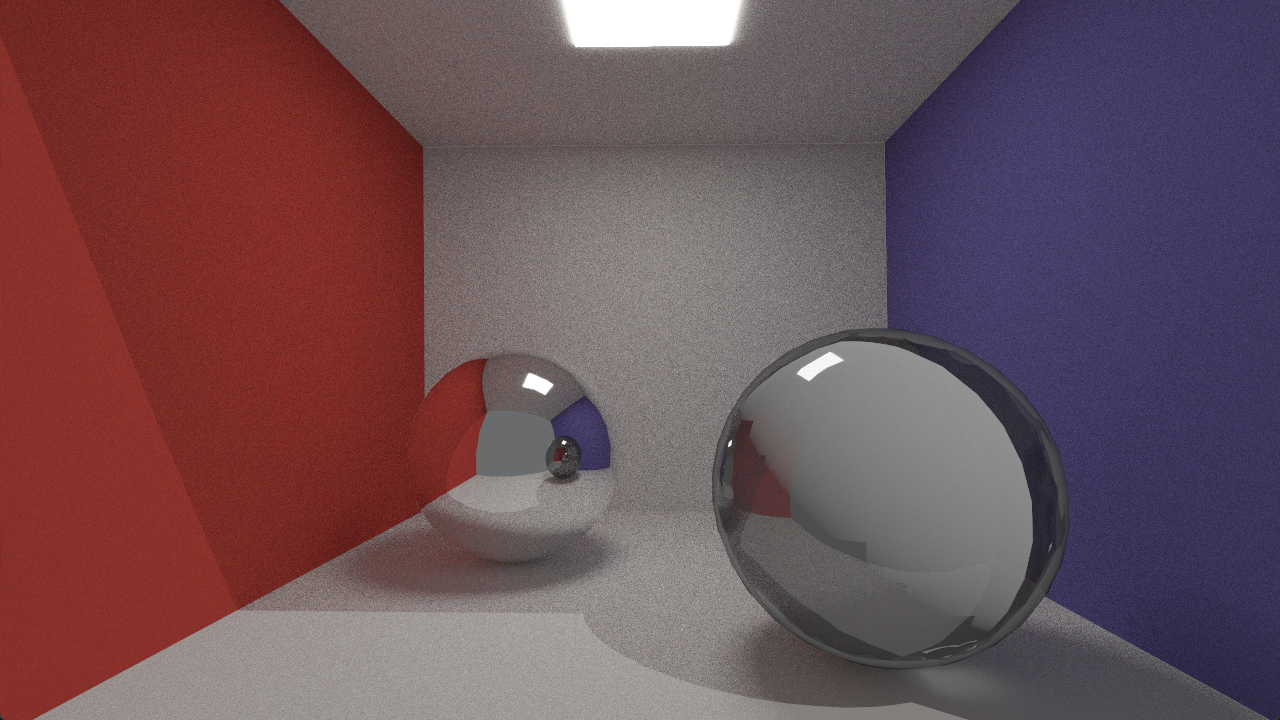

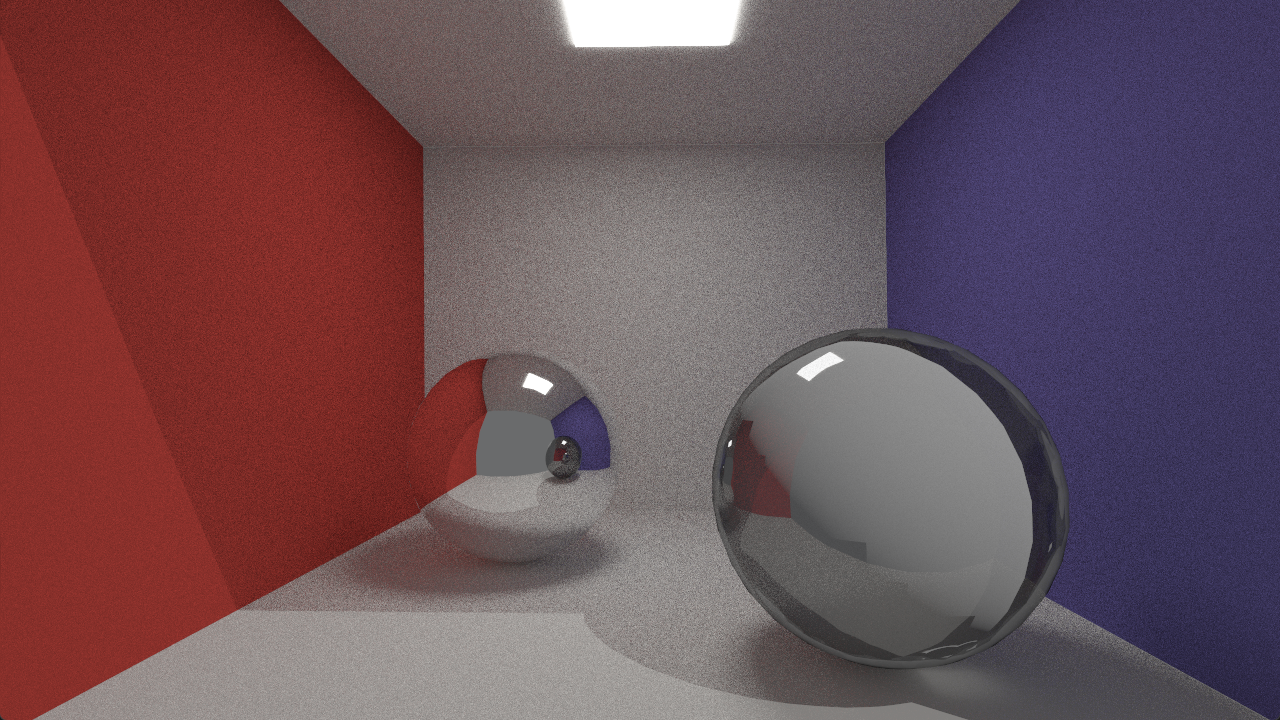

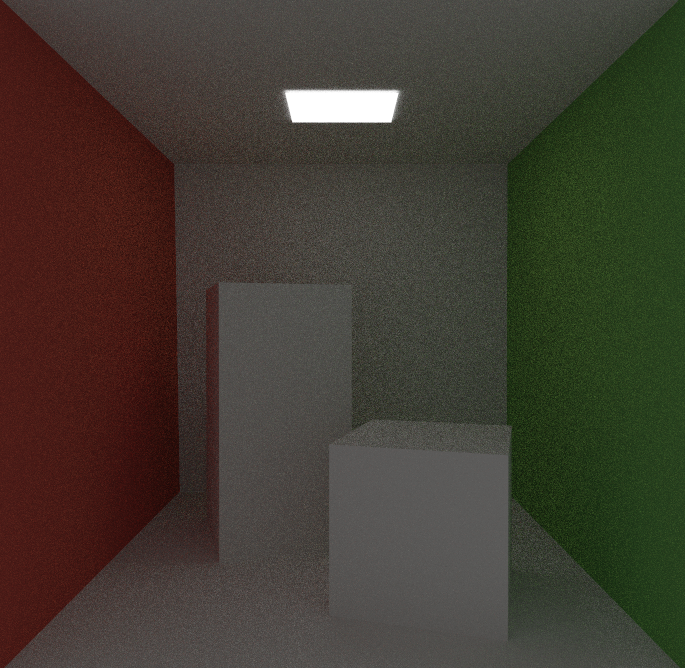

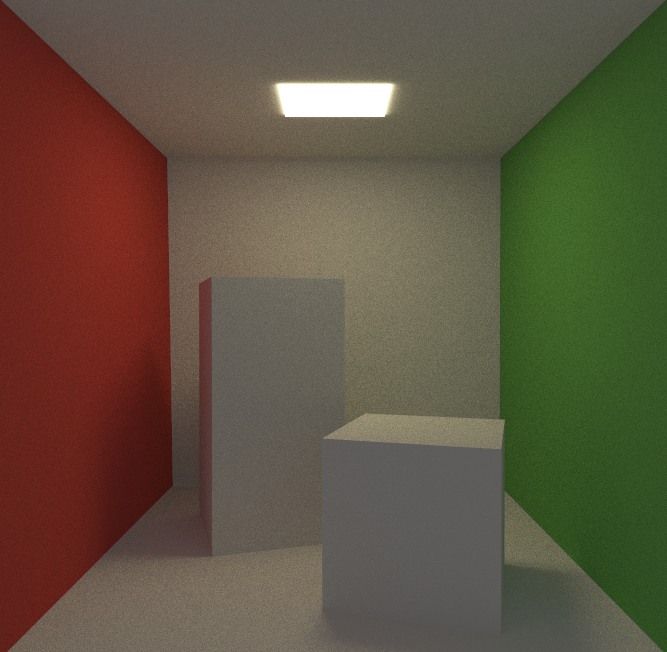

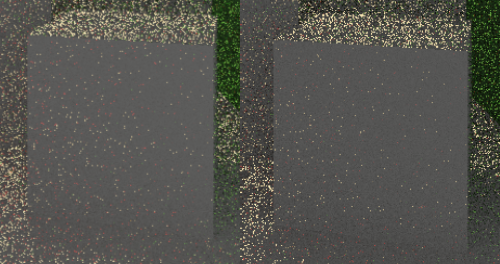

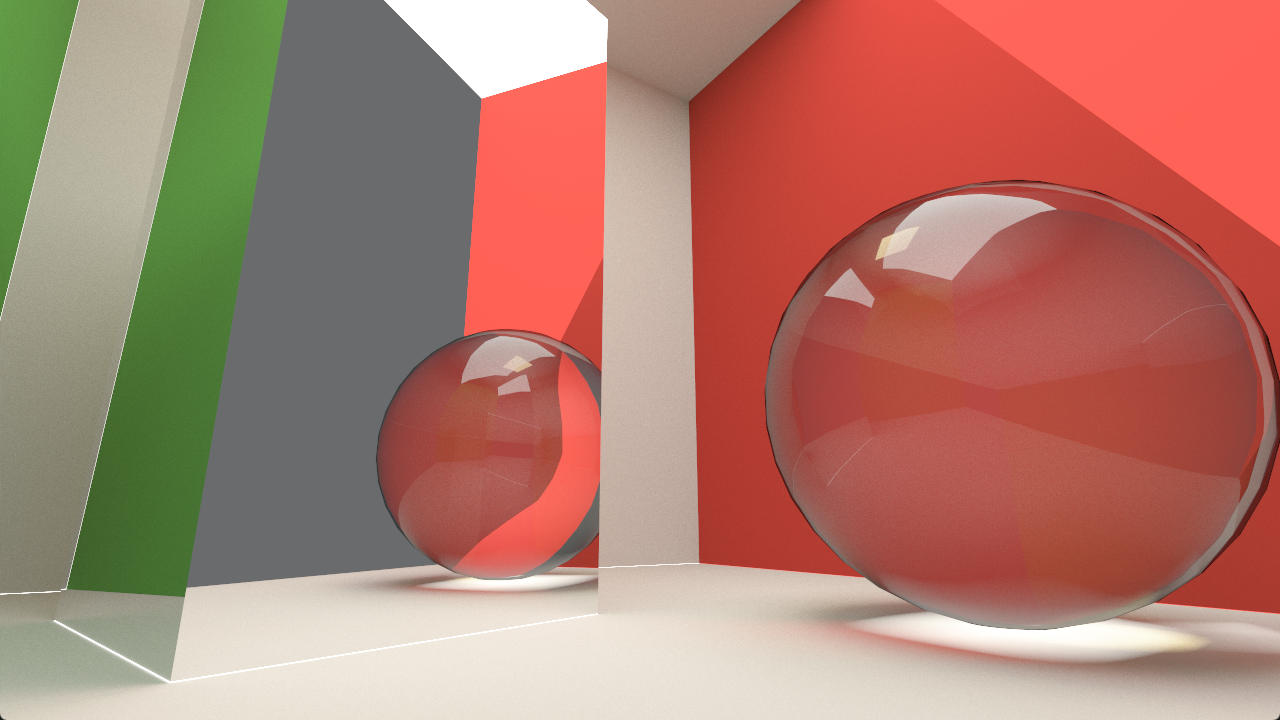

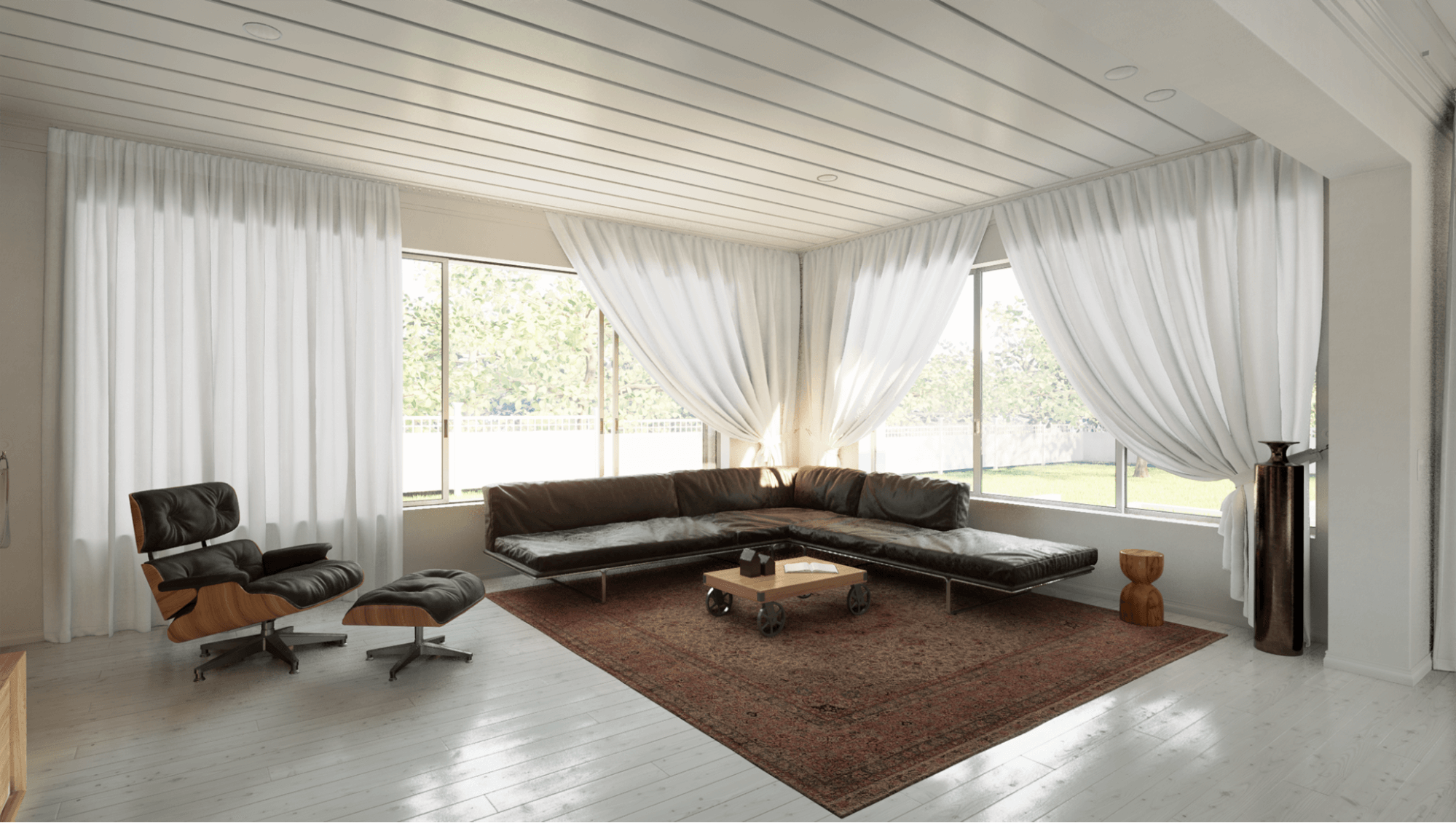

Una vez tengamos un motor funcional, será hora de jugar con él. El capítulo 5 mostrará los resultados de nuestro trabajo. Visualizaremos algunos fenómenos físicos que hemos estudiado a lo largo de la memoria. Estos serán encapsulados en aproximadamente una docena de escenas, centrándose cada una en cierta particularidad; como puede ser la iluminación global, la refracción y reflexión, o el comportamiento de materiales específicos.

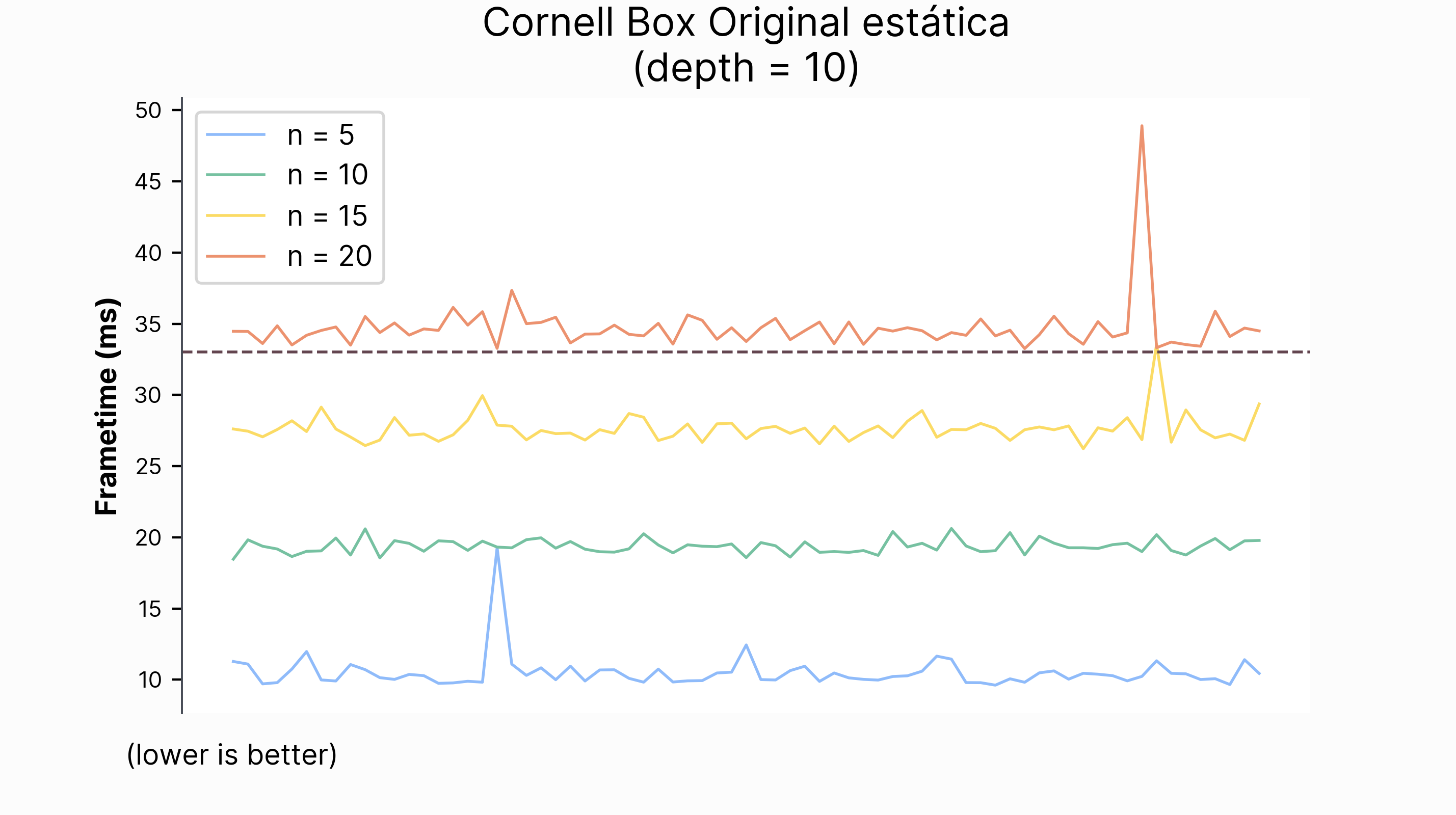

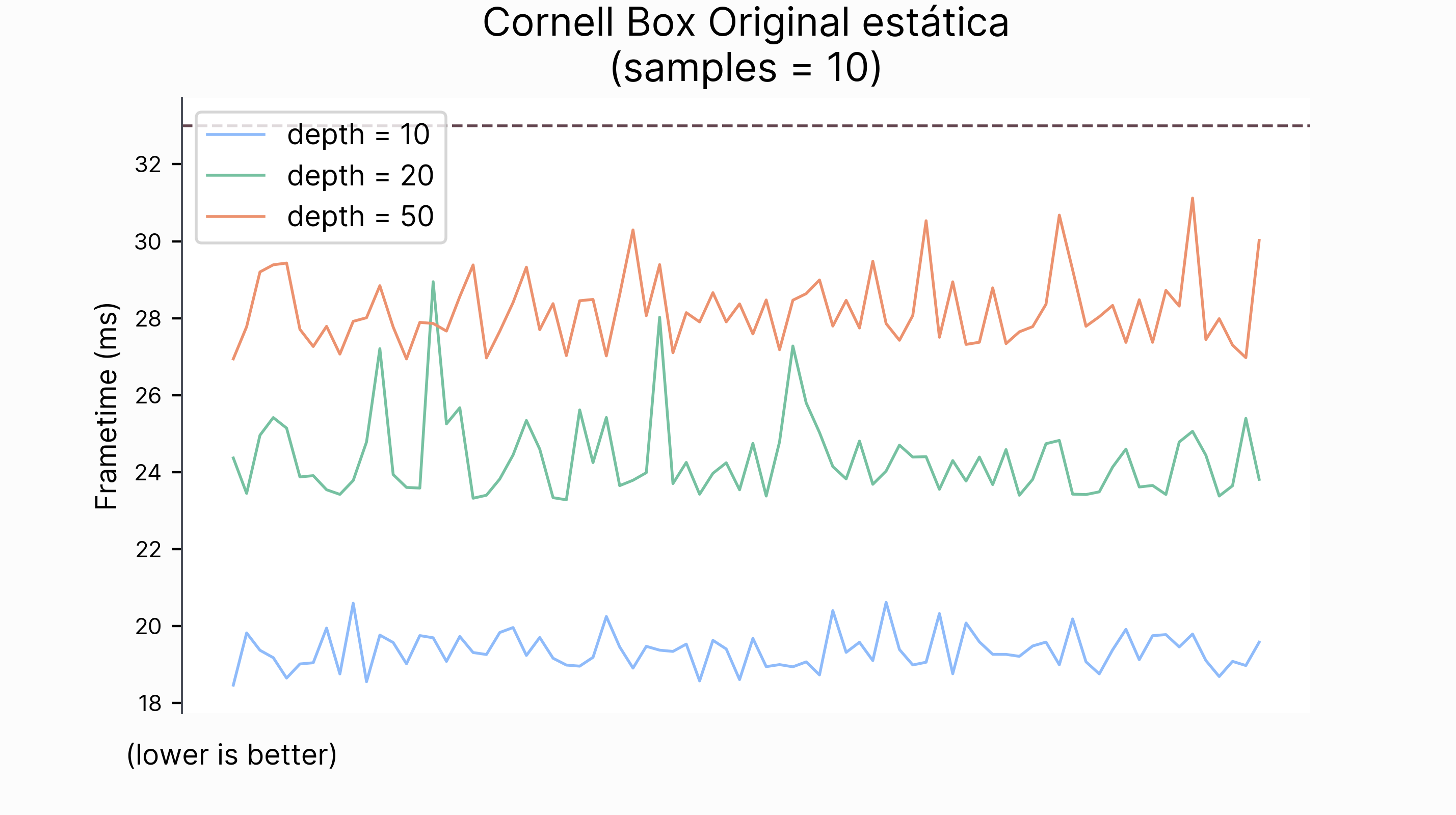

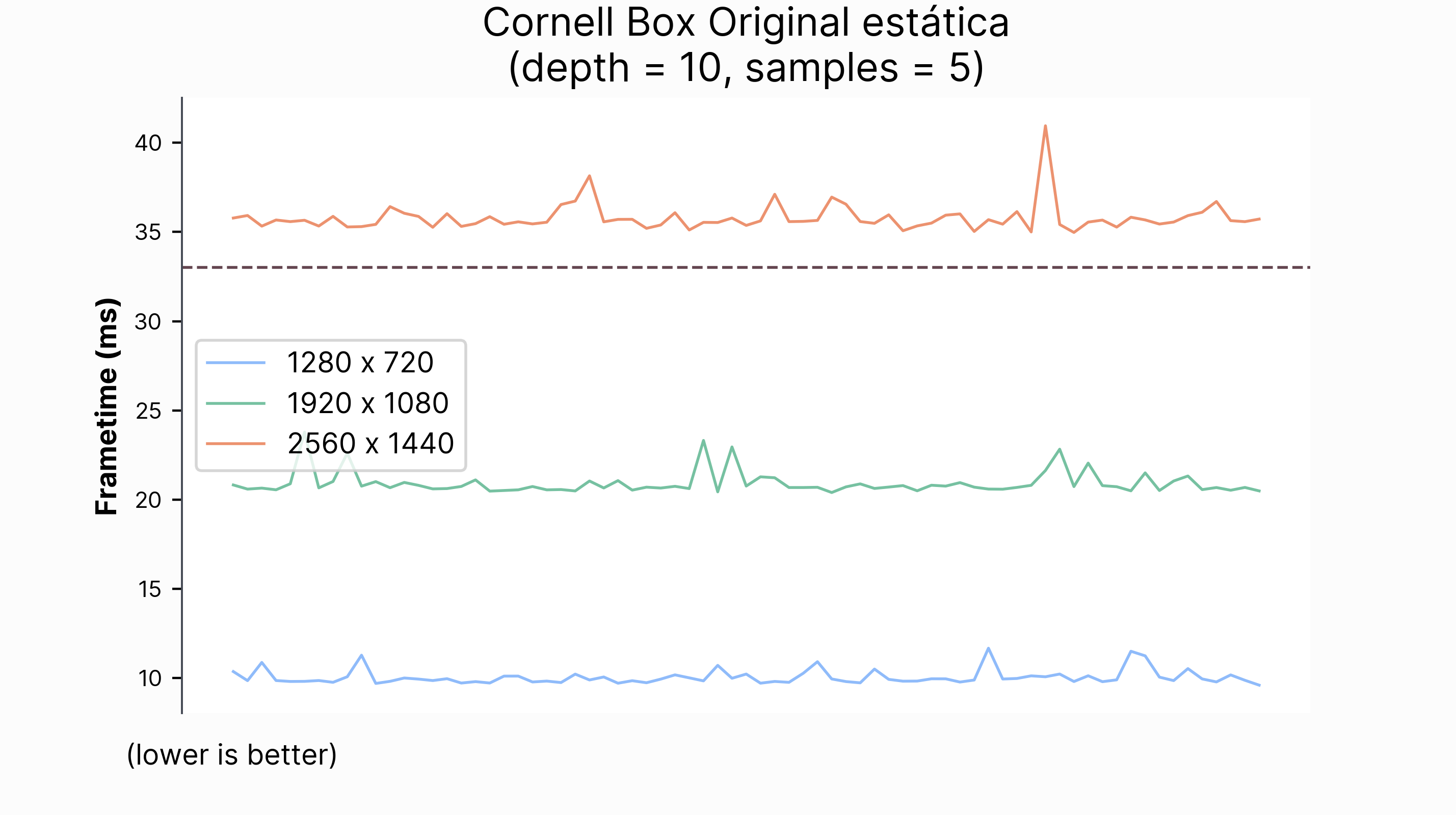

También analizaremos cómo rinde el motor en términos de calidad visual de imagen y tiempo de renderizado. Para ello, comprobaremos cómo varían estas dos métricas al cambiar los parámetros del algoritmo path tracing y las técnicas de reducción de ruido. Entre estos parámetros, se encuentran el número de muestras del estimador de Monte Carlo, la profunidad de rebotes de un rayo, la acumulación temporal y la resolución.

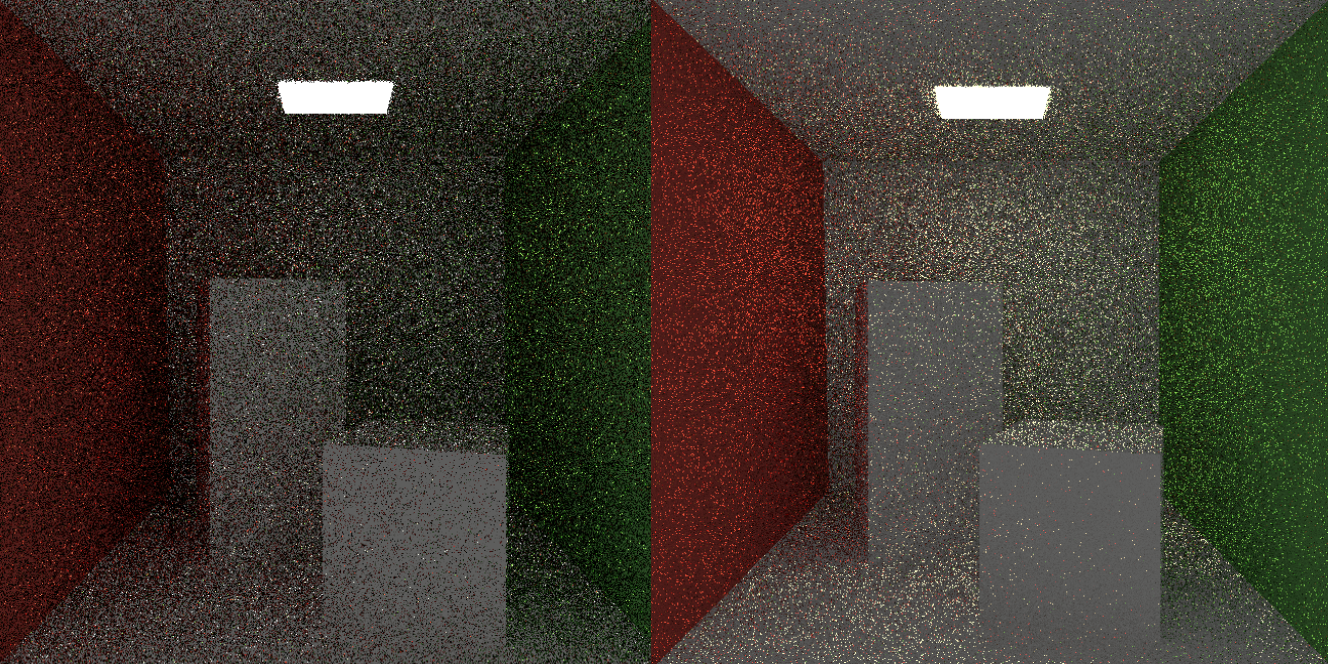

Para poner en contexto el rendimiento, compararemos nuestra implementación con el path tracer desarollado en los libros de Peter Shirley Ray Tracing In One Weekend series (Shirley 2020a) (Shirley 2020b) (Shirley 2020a).

Terminaremos el grueso del trabajo con el capítulo de conclusiones. Reflexionaremos sobre todo lo que hemos aprendido; desde los éxitos logrados hasta las dificultades que presenta este complejo algoritmo. Además, explicaremos cómo se podría mejorar este trabajo, analizando de qué pie cojea la implementación.

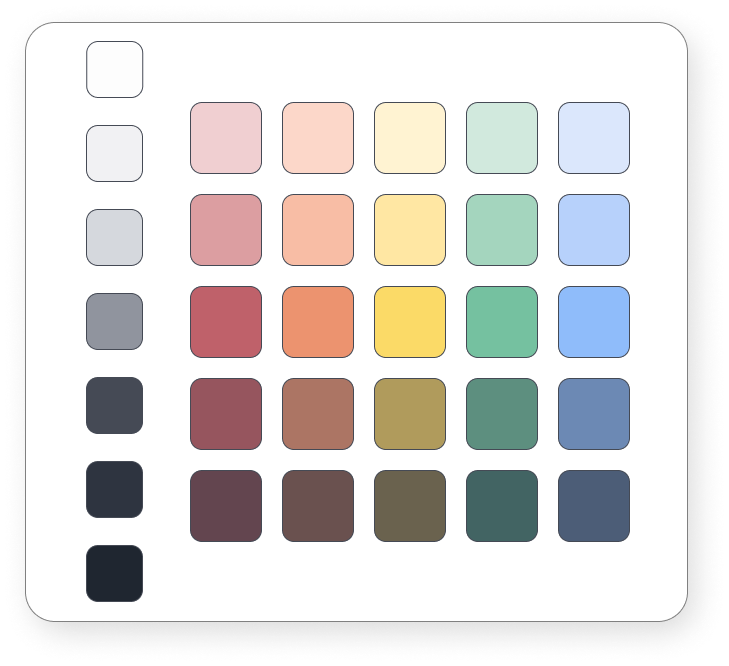

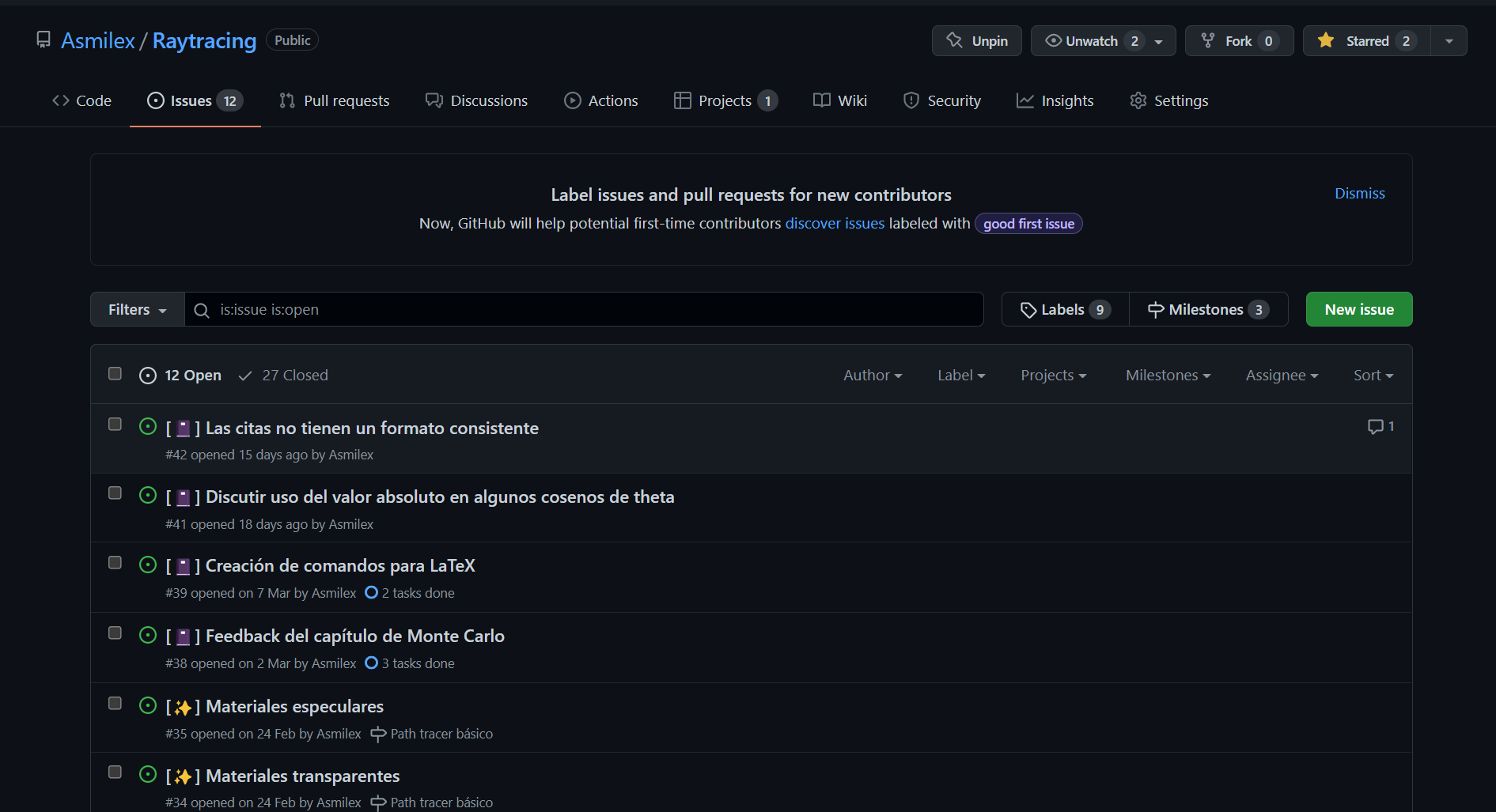

En los anexos se puede encontrar contenido adicional. El primer anexo cubre el estado del arte del área –aunque este trabajo es prácticamente estado del arte–. En el segundo hablaremos sobre cómo se ha realizado este trabajo: desde las principales influencias hasta el diseño gráfico; pasando por el presupeusto y los ciclos de desarrollo. Por último, se ha incluído un glosario de términos y conceptos para facilitar la lectura de este documento.

Aunque en la realización de este trabajo se han utilizado múltiples fuentes de información, destacan una serie de libros por encima del resto:

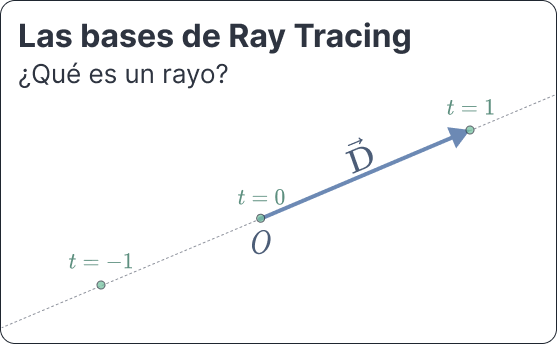

Empecemos por definir lo que es un rayo.

Un rayo (Shirley 2020a) es una función \(P(t) = \mathbf{\mathbf{o}} + t\mathbf{d}\), donde \(\mathbf{\mathbf{o}}\) el origen, un punto del espacio afín; \(\mathbf{d}\) un vector libre, y \(t \in \mathbb{R}\). Podemos considerarlo una interpolación entre dos puntos en el espacio, donde \(t\) controla la posición en la que nos encontramos.

Por ejemplo, si \(t = 0\), obtendremos el origen. Si \(t = 1\), obtendremos el punto correspondiente a la dirección. Usando valores negativos vamos hacia atrás.

Dado que estos puntos estarán generalmente en \(\mathbb{R}^3\), podemos escribirlo como

\[ P(t) = (o_x, o_y, o_z) + t (d_x, d_y, d_z) \](1)

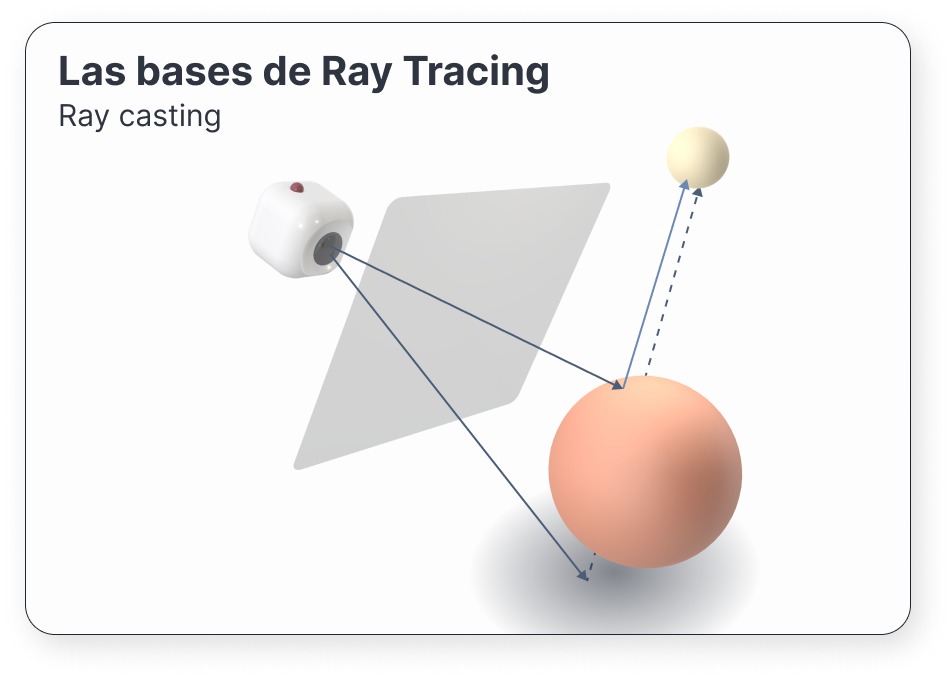

Estos rayos los dispararemos a través de una cámara virtual, que estará enfocando a la escena. De esta forma, los haremos rebotar con los objetos que se encuentren en el camino del rayo. a este proceso lo llamaremos ray casting.

Generalmente, nos quedaremos con el primer objeto que nos encontremos en su camino. Aunque, a veces, nos interesará saber todos con los que se encuentre.

Cuando un rayo impacta con un objeto, adquirirá parte de las propiedades lumínicas del punto de impacto. Por ejemplo, cuánta luz proporciona la lámpara que tiene encima la esfera de la figura anterior.

Una vez recojamos la información que nos interese, aplicaremos otro raycast desde el nuevo punto de impacto, escogiendo una nueva dirección determinada. Esta dirección dependerá del tipo de material del objeto. Y, de hecho, algunos serán capaces de invocar varios rayos.

Por ejemplo, los espejos reflejan la luz casi de forma perfecta; mientras que otros elementos como el agua o el cristal reflejan y refractan luz, así que necesitaremos generar dos nuevos raycast.

Usando suficientes rayos obtendremos la imagen de la escena. a este proceso de ray casting recursivo es lo que se conoce como ray tracing.

Como este proceso puede continuar indefinidamente, tendremos que controlar la profundidad de la recursión. a mayor profundidad, mayor calidad de imagen; pero también, mayor tiempo de ejecución.

Una de las partes más importantes de ray tracing, y a la que quizás dedicaremos más tiempo, es a la elección de la dirección.

Hay varios factores que entran en juego a la hora de decidir qué hacemos cuando impactamos con un nuevo objeto:

Estas cuestiones las exploraremos a fondo en las siguientes secciones.

Como dijimos al principio del capítulo, representaremos un rayo como

\[ \begin{aligned} P(t) & = (o_x, o_y, o_z) + t (d_x, d_y, d_z) = \\ & = (o_x + t d_x, o_y + t d_y, o_y + t d_z) \end{aligned} \]

Por ejemplo, tomando \(\mathbf{\mathbf{o}} = (1, 3, 2), \mathbf{d} = (1, 2, 1)\):

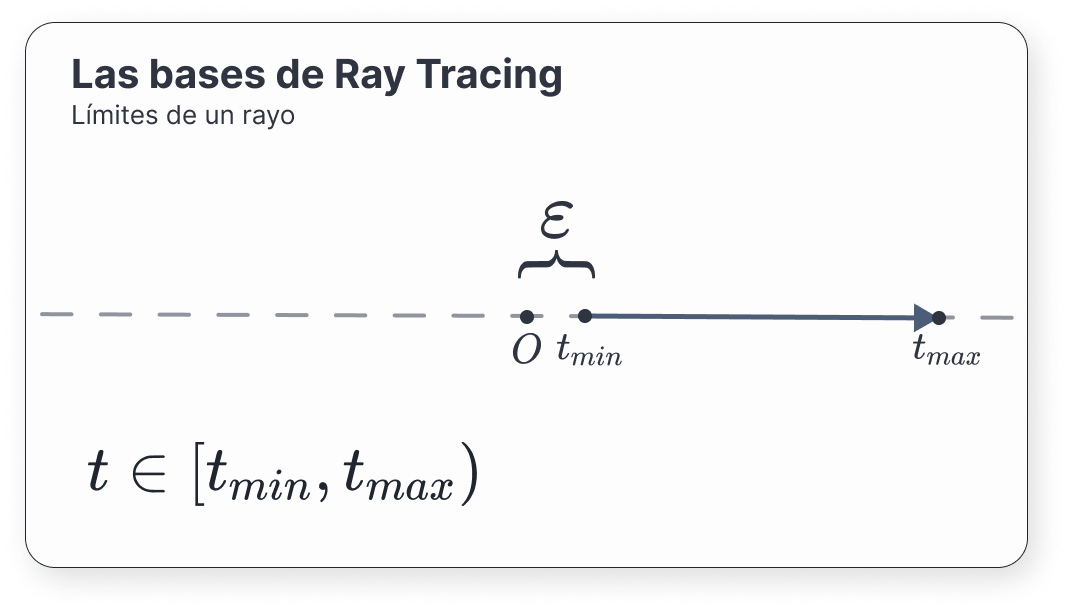

Nos resultará especialmente útil limitar los valores que puede tomar \(t\). Restringiremos los posibles puntos del dominio de forma que \(t \in [t_{min}, t_{max})\), con \(t_{min} < t_{max}\). En general, nos interesará separarnos de las superficies un pequeño pero no despreciable \(\varepsilon\) para evitar intersecar con el origen.

Una de las principales cuestiones que debemos hacernos es saber cuándo un rayo impacta con una superficie. Lo definiremos analíticamente.

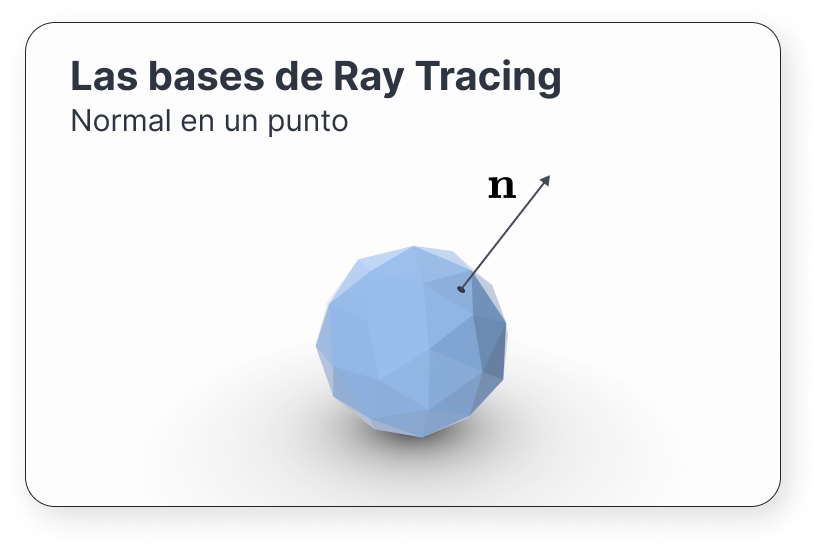

Generalmente, cuando hablemos de superficies, nos referiremos superficies diferenciables, pues nos interesará conocer el vector normal en cada punto.

Una superficie implícita es una superficie en un espacio euclidiano definida como

\[ F(x, y, z) = 0 \]

Esta ecuación implícita define una serie de puntos del espacio \(\mathbb{R}^3\) que se encuentran en la superficie. Por ejemplo, la esfera se define como \(x^2 + y^2 + z^2 - 1 = 0\).

Consideremos una superficie \(S\) y un punto regular \(\mathbf{\mathbf{p}}\) de ella; es decir, un punto tal que el gradiente de \(F\) en \(\mathbf{\mathbf{p}}\) no es 0. Se define el vector normal \(\mathbf{n}\) a la superficie en ese punto como

\[ \mathbf{n} = \nabla F(\mathbf{p}) = \left( \frac{\partial F(\mathbf{p})}{\partial x}, \frac{\partial F(\mathbf{p})}{\partial y}, \frac{\partial F(\mathbf{p})}{\partial z}\right ) \](2)

Dado un punto \(\mathbf{q} \in \mathbb{R}^3\), queremos saber dónde interseca un rayo \(P(t)\). Es decir, para qué \(t\) se cumple que \(F(P(t)) = 0 \iff F(\mathbf{\mathbf{o}} + t\mathbf{d}) = 0\).

Este tipo de superficies suele requerir un cálculo numérico iterativo por lo general, pero algunos objetos presentan expresiones sencillas que permiten una resolución analítica.

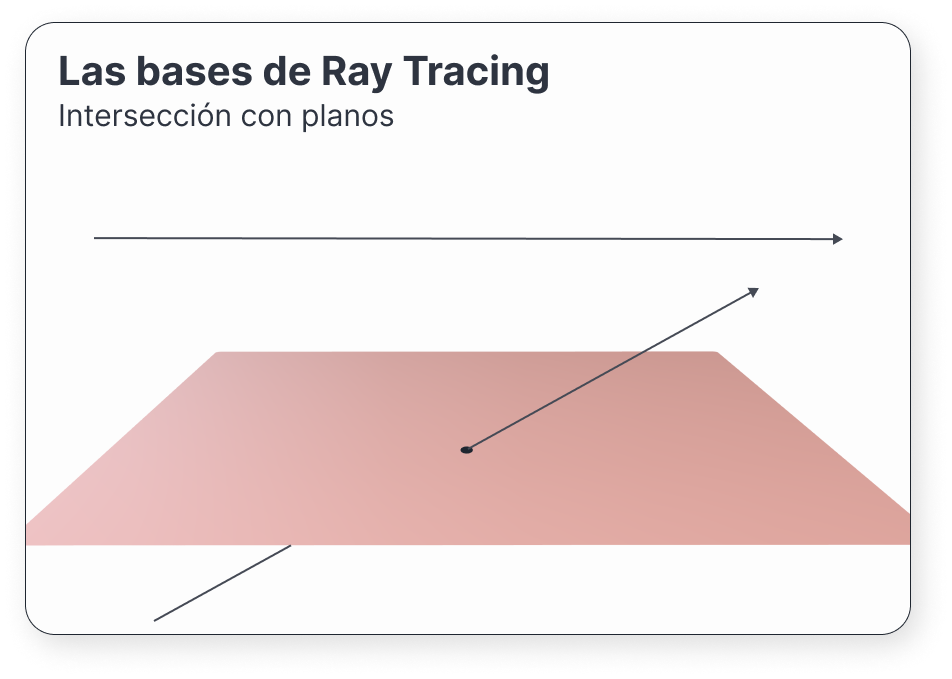

Este es el caso de los planos. Para comprobarlo, tomemos un punto \(\mathbf{q}_0\) de un cierto plano y un vector normal a la superficie \(\mathbf{n}\). La ecuación implícita del plano será (Shirley and Morley 2003)

\[ F(Q) = (\mathbf{q} - \mathbf{q}_0) \cdot \mathbf{n} = 0 \]

Si pinchamos nuestro rayo en la ecuación,

\[ \begin{aligned} F(P(t)) & = (P(t) - \mathbf{q}_0) \cdot \mathbf{n} \\ & = (\mathbf{\mathbf{o}} + t\mathbf{d} - \mathbf{q}_0) \cdot \mathbf{n} = 0 \\ \end{aligned} \]

Resolviendo para \(t\), esto se da si

\[ \begin{aligned} \mathbf{\mathbf{o}} \cdot \mathbf{n} + t\mathbf{d} \cdot \mathbf{n} - \mathbf{q}_0 \cdot \mathbf{n} & = 0 & \iff \\ t\mathbf{d} \cdot \mathbf{n} & = \mathbf{q}_0 \cdot \mathbf{n} - \mathbf{\mathbf{o}} \cdot \mathbf{n} & \iff \\ t & = \frac{\mathbf{q}_0 \cdot \mathbf{n} - \mathbf{\mathbf{o}} \cdot \mathbf{n}}{\mathbf{d} \cdot \mathbf{n}} \end{aligned} \]

Es decir, hemos obtenido el único valor de \(t\) para el cual el rayo toca la superficie.

Debemos tener en cuenta el caso para el cual \(d \cdot \mathbf{n} = 0\). Esto solo se da si la dirección y el vector normal a la superficie son paralelos.

Otra forma de definir una superficie en el espacio es mediante un subconjunto \(S \subset \mathbb{R}^2\) y una serie de funciones, \(f, g, h: S \rightarrow \mathbb{R}^3\), de forma que

\[ (x, y, z) = \left( f(u, v), g(u, v), h(u, v) \right) \\ \]

En informática gráfica, hacemos algo similar cuando mapeamos una textura a una superficie. Se conoce como UV mapping.

Demos un par de ejemplos de superficies paramétricas:

El vector normal \(\mathbf{n}\) a la superficie en un punto \((u, v)\) del dominio viene dado por

\[ \mathbf{n}(u, v) = \left( \frac{\partial f}{\partial u}, \frac{\partial g}{\partial u}, \frac{\partial h}{\partial u} \right) \times \left( \frac{\partial f}{\partial v}, \frac{\partial g}{\partial v}, \frac{\partial h}{\partial v} \right) \]

El punto de intersección de una superficie paramétrica con un rayo viene dado por aquellos puntos de la superifice \((u, v)\) para los que

\[ \begin{aligned} \begin{cases} o_x + td_x = f(u, v) \\ o_y + td_y = g(u, v) \\ o_z + td_z = h(u, v) \end{cases} \end{aligned} \]

Con \(t \in \mathbb{R}\). Es posible que el rayo no impacte en ningún punto. En ese caso, el sistema de ecuaciones no tendría solución. Otra posibilidad es que intersequen en varios puntos.

Por regla general este tipo de superficies no permiten un cálculo fácil del punto de intersección, lo cual hace que se evitan en ray tracing. En su lugar se opta por otro tipo de estructuras como las mallas de triángulos.

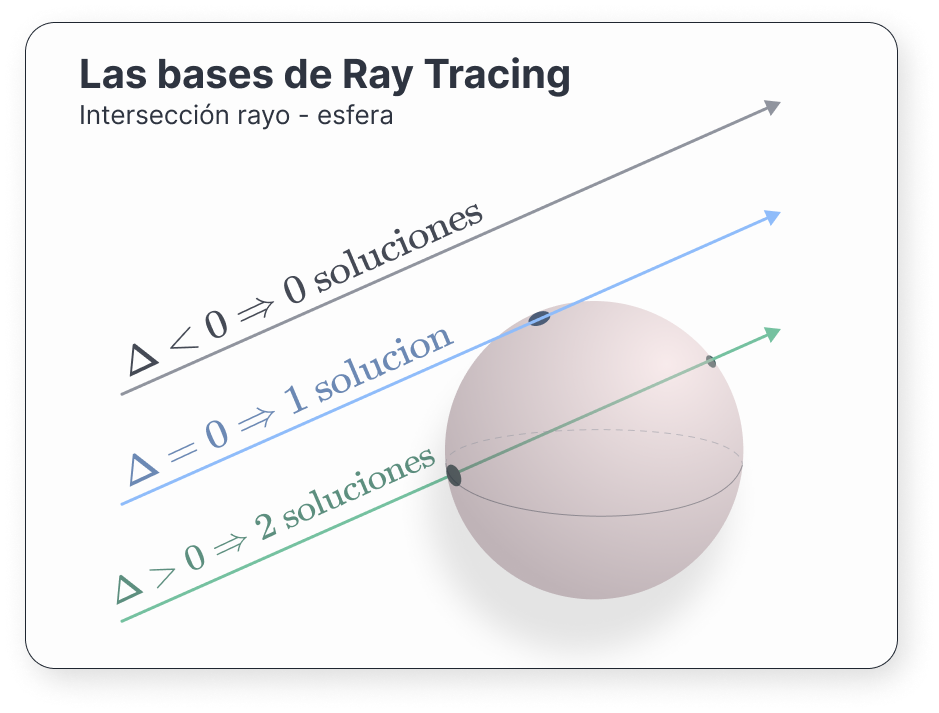

Estudiemos ahora cómo intersecan una esfera con nuestro rayo (Shirley and Morley 2003). Una esfera de centro \(\mathbf{c}\) y radio \(r\) viene dada por aquellos puntos \(\mathbf{p} = (x, y, z)\) que cumplen

\[ (\mathbf{p} - \mathbf{c}) \cdot (\mathbf{p} - \mathbf{c}) = r^2 \]

Podemos reescribir esta ecuación en términos de sus coordenadas para obtener

\[ (x - c_x)^2 + (y - c_y)^2 + (z - c_z)^2 = r^2 \]

Veamos para qué valores de \(t\) de nuestro rayo se cumple esa ecuación:

\[ \begin{aligned} (P(t) - \mathbf{c}) \cdot (P(t) - \mathbf{c}) & = r^2 & \iff \\ (\mathbf{o} + t\mathbf{d} - \mathbf{c}) \cdot (\mathbf{o} + t\mathbf{d} - \mathbf{c}) & = r^2 & \iff \\ \end{aligned} \]

Aplicando las propiedades del producto escalar de la conmutatividad (\(\mathbf{a} \cdot \mathbf{b} = \mathbf{b} \cdot \mathbf{a}\)) y la distributiva (\(\mathbf{a} \cdot (\mathbf{b} + \mathbf{c}) = \mathbf{a} \cdot \mathbf{b} + \mathbf{a} \cdot \mathbf{c}\)), podemos escribir

\[ \begin{aligned} ((\mathbf{o} - \mathbf{c}) + t\mathbf{d}) \cdot ((\mathbf{o} - \mathbf{c}) + t\mathbf{d}) & = r^2 & \iff \\ (\mathbf{o} - \mathbf{c})^2 + 2 \cdot (\mathbf{o} - \mathbf{c}) \cdot t\mathbf{d} + (t\mathbf{d})^2 & = r^2 & \iff \\ d^2t^2 + 2 d \cdot (\mathbf{o} - \mathbf{c})t + (\mathbf{o} - \mathbf{c})^2 - r^2 & = 0 & \iff \\ \end{aligned} \]

Así que tenemos una ecuación de segundo grado. Resolviéndola, nos salen nuestros puntos de intersección:

\[ t = \frac{ - d \cdot (\mathbf{o} - \mathbf{c}) \pm \sqrt{(d \cdot (\mathbf{o} - \mathbf{c}))^2 - 4 (\mathbf{d}^2)((\mathbf{o} - \mathbf{c})^2 - r^2)} }{ 2 \mathbf{d}^2 } \]

Debemos distinguir tres casos, atiendiendo al valor que toma el discriminante \(\Delta = \small{(\mathbf{d} \cdot (\mathbf{o} - \mathbf{c}))^2 - 4 (\mathbf{d}^2)((\mathbf{o} - \mathbf{c})^2 - r^2)}\):

Para estos dos últimos, si consideramos \(t_0\) cualquier solución válida, el vector normal resultante viene dado por

\[ \mathbf{n} = 2 (P(t_0) - \mathbf{c}) \]

o, normalizando,

\[ \hat{\mathbf{n}} = \frac{(P(t_0) - \mathbf{c})}{r} \]

Este tipo de intersecciones serán las más útiles en nuestro path tracer. Generalmente, nuestras geometrías estarán compuestas por mallas de triángulos, así que conocer dónde impacta nuestro rayo será clave. Empecemos por la base:

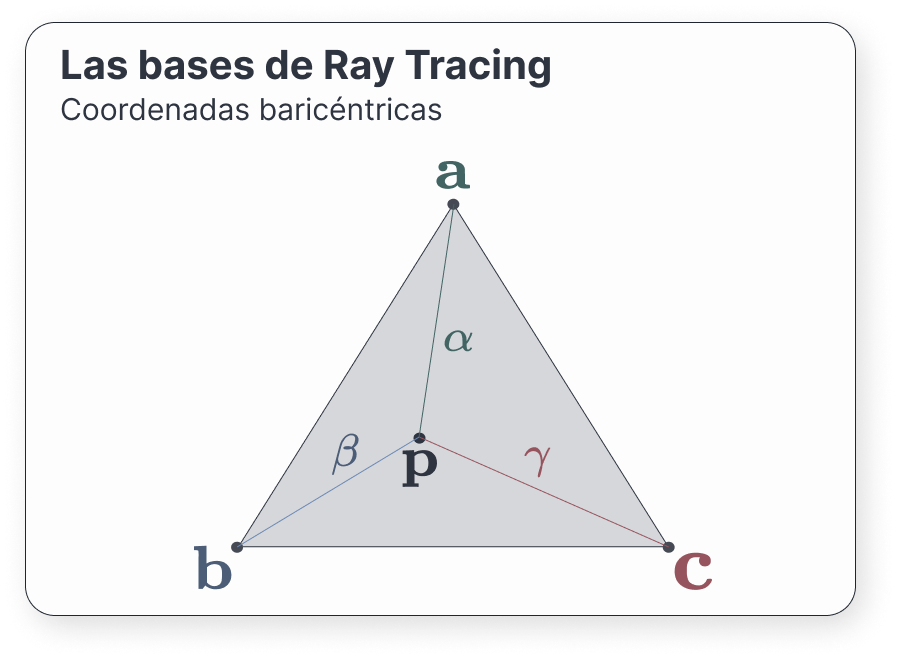

Un triángulo viene dado por tres puntos, \(a, \mathbf{b}\), y \(\mathbf{c}\); correspondientes a sus vértices. Para evitar casos absurdos, supongamos que estos puntos son afinmente independientes; es decir, que no están alineados.

Podemos describir los puntos contenidos en el plano que forman estos vertices mediante coordenadas baricéntricas. Este sistema de coordenadas expresa cada punto del plano como una combinación convexa de los vértices \(\mathbf{a}, \mathbf{b}, \mathbf{c}\) (Shirley and Morley 2003). Es decir, que para cada punto \(\mathbf{p}\) del triángulo existen \(\alpha, \beta\) y \(\gamma\) tales que \(\alpha + \beta + \gamma = 1\) y

\[ \mathbf{p} = \alpha a + \beta \mathbf{b} + \gamma \mathbf{c} \]

Debemos destacar que existen dos grados de libertad debido a la restricción de que las coordenadas sumen 1.

Una propiedad de estas coordenadas que nos puede resultar útil es que un punto \(\mathbf{p}\) está contenido en el triángulo si y solo si \(0 < \alpha, \beta, \gamma < 1\).

Esta propiedad y la restricción de que sumen 1 nos da una cierta intuición de cómo funcionan. Podemos ver las coordenadas baricéntricas como la contribución de los vértices a un punto \(\mathbf{p}\). Por ejemplo, si \(\alpha = 0\), eso significa que el punto viene dado por \(\beta \mathbf{b} + \gamma \mathbf{c}\); es decir, una combinación lineal de \(\mathbf{b}\) y \(\mathbf{c}\). Se encuentra en la recta que generan.

Por proponer otro ejemplo, si alguna de las coordenadas fuera mayor que 1, eso significaría que el punto estaría más allá del triángulo.

Podemos eliminar una de las varibales escribiendo \(\alpha = 1 - \beta - \gamma\), lo que nos dice

\[ \begin{aligned} \mathbf{p} & = (1 - \beta - \gamma) \mathbf{a} + \beta \mathbf{b} + \gamma \mathbf{c} \\ & = \mathbf{a} + (\mathbf{b} - \mathbf{a}) \beta + (\mathbf{c} - \mathbf{a}) \gamma \end{aligned} \]

bajo la restricción

\[ \begin{aligned} \beta + \gamma & < 1 \\ 0 & < \beta \\ 0 & < \gamma \end{aligned} \](3)

Un rayo \(P(t) = \mathbf{o} + t\mathbf{d}\) impactará en un punto del triángulo si se cumple

\[ P(t) = \mathbf{o} + t\mathbf{d} = \mathbf{a} + (\mathbf{b} - \mathbf{a}) \beta + (\mathbf{c} - \mathbf{a}) \gamma \]

cumpliendo [3]. Podemos expandir la ecuación anterior en sus coordenadas para obtener

\[ \begin{aligned} o_x + td_x & = a_x + (b_x - a_x) \beta + (c_x - a_x) \gamma \\ o_y + td_y & = a_y + (b_y - a_y) \beta + (c_y - a_y) \gamma \\ o_z + td_z & = a_z + (b_z - a_z) \beta + (c_z - a_z) \gamma \\ \end{aligned} \]

Reordenamos:

\[ \begin{aligned} (a_x - b_x) \beta + (a_x - c_x) \gamma+ td_x & = a_x - o_x \\ (a_y - b_y) \beta + (a_y - c_y) \gamma+ td_y & = a_y - o_y \\ (a_z - b_z) \beta + (a_z - c_z) \gamma+ td_z & = a_z - o_z \end{aligned} \]

Lo que nos permite escribir el sistema en forma de ecuación:

\[ \begin{pmatrix} a_x - b_x & a_x - c_x & d_x \\ a_y - b_y & a_y - c_y & d_y \\ a_z - b_z & a_z - c_z & d_z \end{pmatrix} \begin{pmatrix} \beta \\ \gamma \\ t \end{pmatrix} = \begin{pmatrix} a_x - o_x \\ a_y - o_y \\ a_z - o_z \end{pmatrix} \]

Calcular rápidamente la solución a un sistema de ecuaciones lineales es un problema habitual. En (Shirley and Morley 2003) se utiliza la regla de Cramer para hacerlo, esperando que el compilador optimice las variables intermedias creadas. Nosotros no nos tendremos que preocupar de esto en particular, ya que el punto de impacto lo calculará la GPU gracias a las herramientras aportadas por KHR (The Khronos Vulkan Working Group 2022, Ray Traversal).

Para obtener el vector normal, podemos hacer el producto vectorial de dos vectores que se encuentren en el plano del triángulo. como, por convención, los vértices se guardan en sentido antihorario visto desde fuera del objeto, entonces

\[ \mathbf{n} = (\mathbf{b} - \mathbf{a}) \times (\mathbf{c} - \mathbf{a}) \]

En este capítulo estudiaremos las bases de la radiometría. Esta área de la óptica nos proporcionará una serie de herramientas con las cuales podremos responder a la pregunta cuánta luz existe en un punto.

Antes de comenzar a trabajar, necesitamos conocer qué entendemos por luz. Aunque hay muchas formas de trabajar con ella (a fin de cuentas, todavía seguimos discutiendo sobre qué es exactamente la luz 1), nosotros nos quedaremos con la definición clásica y algunas pinceladas de la cuántica. Nos será suficiente utilizar el concepto de fotón.

Un fotón es aquella particula emitida por una fuente de iluminación. Estos fotones tienen una posición, una dirección de propagación y una longitud de onda \(\lambda\) (Shirley and Morley 2003); así como una velocidad \(c\) que depende del índice de refracción del medio, \(n\). La unidad de medida de \(\lambda\) es el nanómetro (\(\text{nm}\)).

Nota(ción): cuando usemos un paréntesis tras una ecuación, dentro denotaremos sus unidades de medida.

Necesitaremos también definir qué es la frecuencia, \(f\). Su utilidad viene del hecho de que, cuando la luz cambia de medio al propagarse, la frecuencia se mantiene constante.

\[ f = \frac{c}{\lambda} (\text{Hz}) \](4)

Un fotón tiene asociada una carga de energía, denotada por \(Q\):

\[ Q = hf = \frac{hc}{\lambda} (\text{J}) \](5)

donde \(h = 6.62607004 \times 10^{-34} \text{J} \cdot \text{s}\) es la constante de Plank y \(c = 299 792 458 \text{ m/s}\) la velocidad de la luz.

En realidad, todas estas cantidades deberían tener un subíndice \(\lambda\), puesto que dependen de la longitud de onda. La energía de un fotón \(Q\), por ejemplo, debería denotarse \(Q_\lambda\). Sin embargo, en la literatura de informática gráfica se suele optar por omitirla, puesto que la mayoría de motores no generalizan las particularidades de cada longitud de onda. ¡Tenlo en cuenta a partir de aquí!

A partir de la energía \(Q\), podemos estimar la cantidad total de energía que pasa por una región del espacio por unidad de tiempo. A esta tasa la llamaremos potencia, o flujo radiante \(\Phi\) (Pharr, Jakob, and Humphreys 2016, Radiometry). Esta medida nos resultará más útil que la energía total, puesto que nos permite estimar la energía en un instante:

\[ \Phi = \lim_{\Delta t \to 0}{\frac{\Delta Q}{\Delta t}} = \frac{dQ}{dt} (\text{J/s}) \](6)

Su unidad es julios por segundo, comúnmente denotado vatio (watts, \(\text{W}\)). También se utiliza el lumen. Podemos encontrar la energía total en un periodo de tiempo \([t_0, t_1]\) integrando el flujo radiante:

\[ Q = \int_{t_0}^{t_1}{\Phi(t)dt} \]

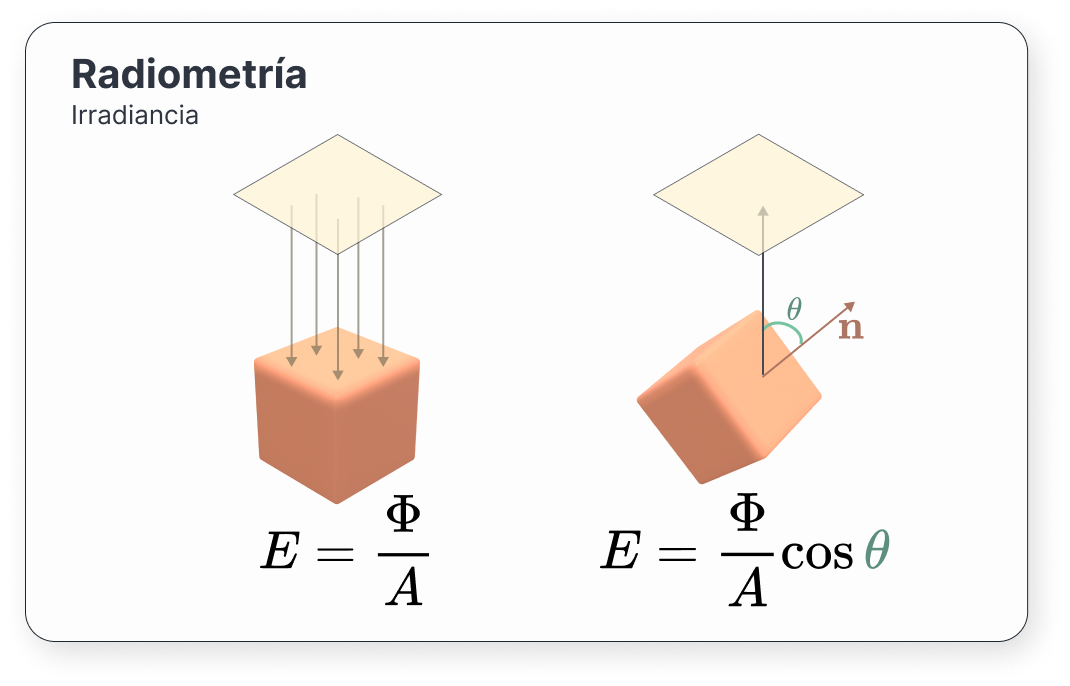

La irradiancia o radiancia emitida es la potencia por unidad de área que recibe una región de una superficie o un punto de la misma. Si \(A\) es el área de dicha superficie, la irradiancia se define como

\[ E = \frac{\Phi}{A} (\text{W/m}^2) \](7)

Ahora que tenemos la potencia emitida en una cierta área, nos surge una pregunta: ¿y en un cierto punto \(p\)?.

Tomando límites en la expresión anterior, encontramos la respuesta:

\[ E(p) = \lim_{\Delta A \to 0}{\frac{\Delta \Phi}{\Delta A}} = \frac{d\Phi}{dA} (\text{W/m}^2) \](8)

De la misma manera que con la potencia, integrando \(E(p)\) podemos obtener el flujo radiante:

\[ \Phi = \int_{A}{E(p)dp} \]

El principal problema de la irradiancia es que no nos dice nada sobre las direcciones desde las que ha llegado la luz.

Con estas tres unidades básicas, nos surge una pregunta muy natural: ¿cómo mido cuánta luz llega a una superficie?

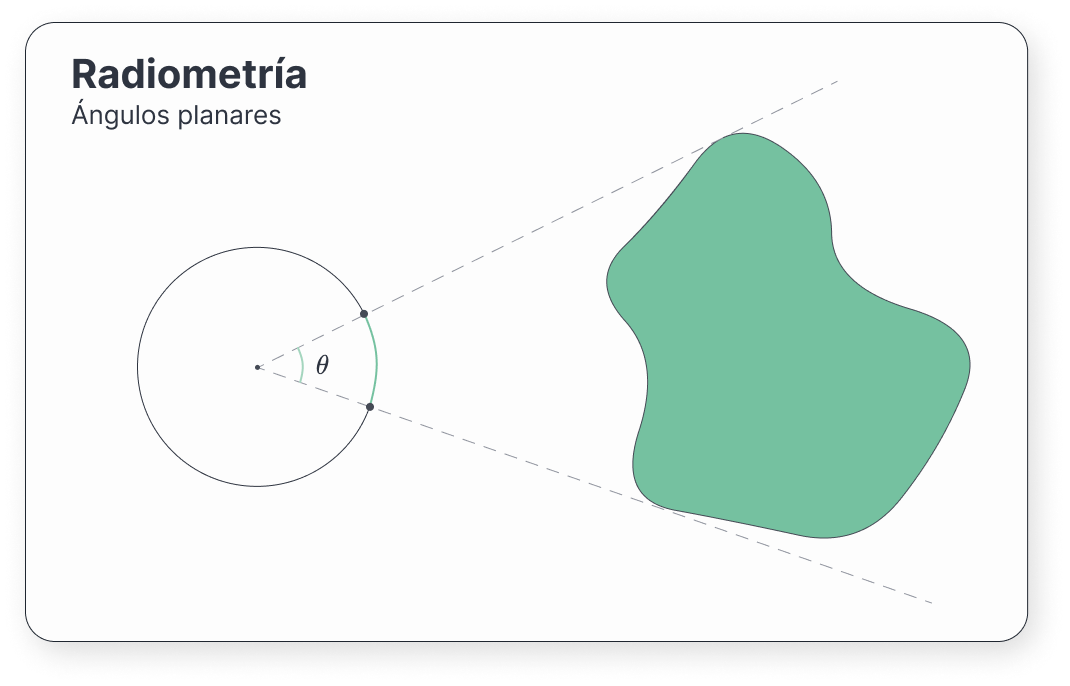

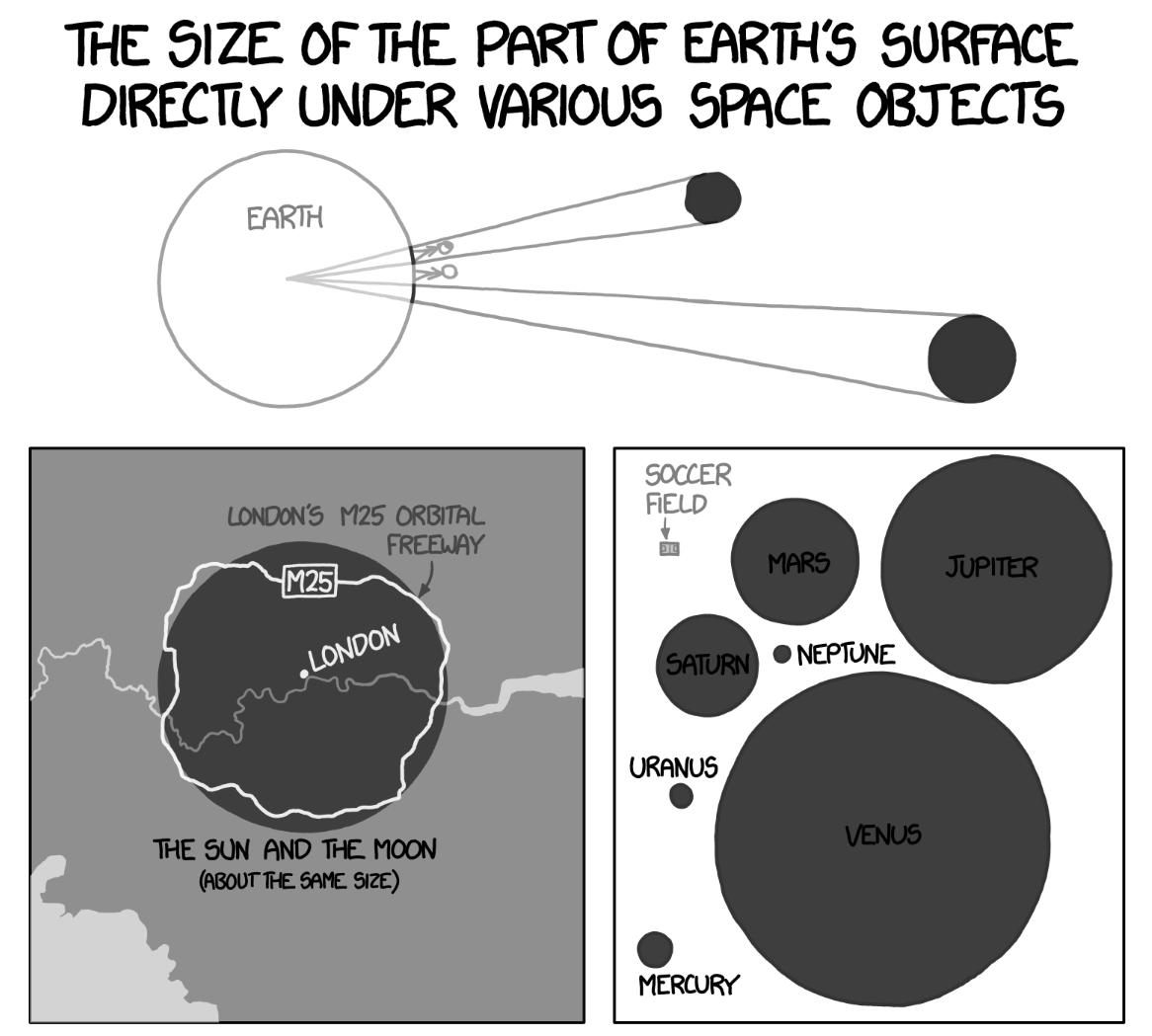

Para responder a esta pregunta, necesitaremos los ángulos sólidos. Son la extensión de los ángulos bidimensionales a los que estamos acostumbrados (llamados técnicamente ángulos planares).

Ilustremos el sentido de estos ángulos: imaginemos que tenemos un cierto objeto en dos dimensiones delante de nosotros, a una distancia desconocida. ¿Sabríamos cuál es su tamaño, solo con esta información? Es más, si entrara otro objeto en la escena, ¿podríamos distinguir cuál de ellos es más grande?

Parece difícil responder a estas preguntas. Sin embargo, sí que podemos determinar cómo de grandes nos parecen desde nuestro punto de vista. Para ello, describimos una circunferencia de radio \(r\) alrededor nuestra. Si trazamos un par de líneas desde nuestra posición a las partes más alejadas de este objeto, y las cortamos con nuestra circunferencia, obtendremos un par de puntos inscritos en ella. Pues bien, al arco que encapsulan dichos puntos le vamos a hacer corresponder un cierto ángulo: el ángulo planar.

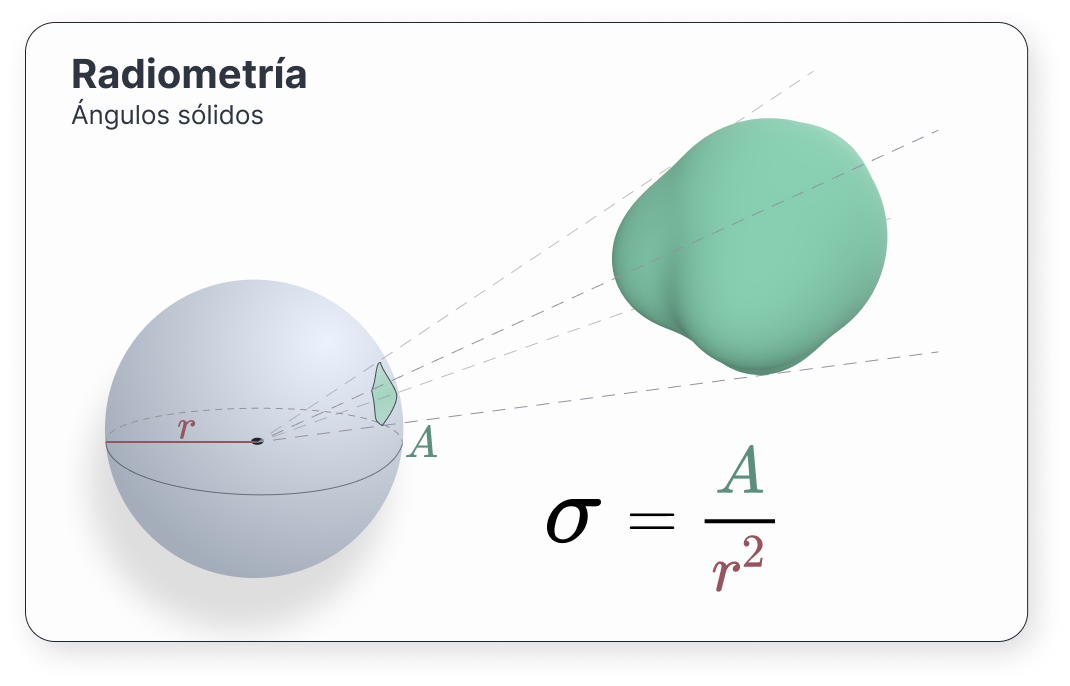

Llevando esta idea a las tres dimensiones es como conseguimos el concepto de ángulo sólido. Si en dos dimensiones teníamos una circunferencia, aquí tendremos una esfera. Cuando generemos las rectas proyectantes hacia el volumen, a diferencia de los ángulos planares, se inscribirá un área en la esfera. La razón entre dicha área \(A\) y el cuadrado del radio \(r\) nos dará un ángulo sólido:

\[ \sigma = \frac{A}{r^2} \text{(sr)} \](9)

Los denotaremos por \(\sigma\), aunque también se pueden encontrar en la literatura como \(\Omega\). Su unidad de medida es el estereorradián (\(\text{sr}\)). Se tiene que \(\sigma \in [0, 4\pi]\). Un esteorradián corresponde a una superficie con área \(r^2\): \(1 \text{sr} = \frac{r^2}{r^2}\).

Usaremos \(\omega\) para representar vectores dirección unitarios en la esfera alrededor de un punto \(p\).

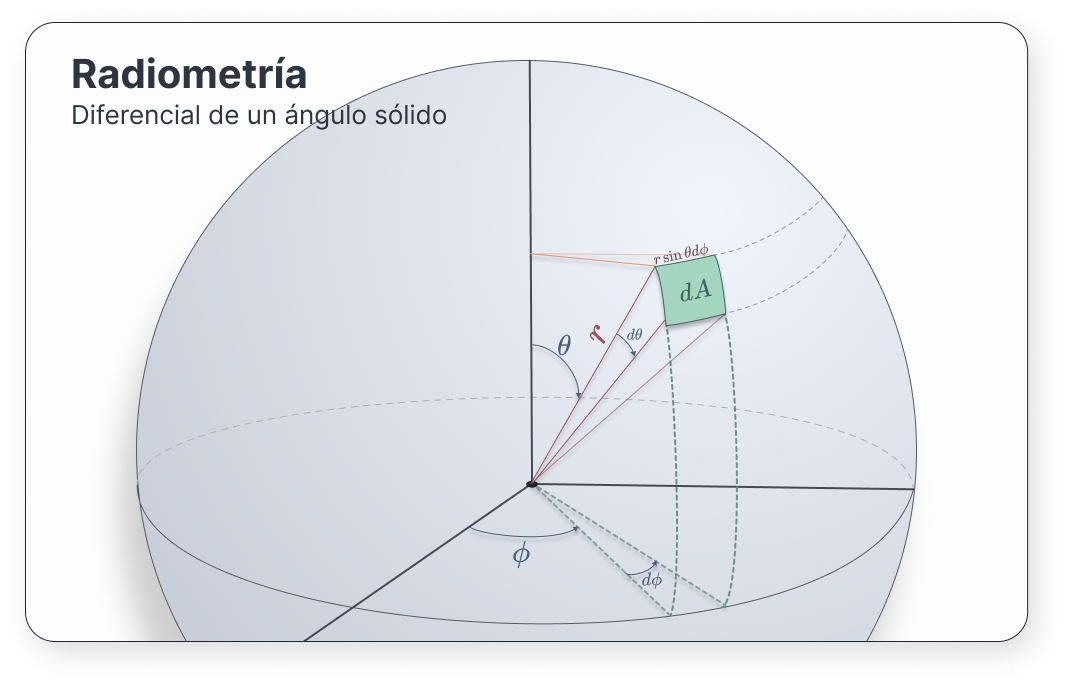

Puesto que estamos trabajando con esferas, nos resultará muy cómodo emplear coordenadas esféricas. Para un cierto punto de coordenadas \((x, y, z)\) de la esfera unitaria, se tiene que

\[ \begin{aligned} \begin{cases} x = \sin\theta\cos\phi \\ y = \sin\theta\sin\phi \\ z = \cos\theta \end{cases} \end{aligned} \](10)

A \(\theta\) se le denomina ángulo polar, mientras que a \(\phi\) se le llama acimut. Imaginémonos un punto en la esfera de radio \(r\) ubicado en una posición \((r, \theta, \phi)\). Queremos calcular un área chiquitita \(dA_h\), de forma que el ángulo sólido asociado a dicha área debe ser \(d\sigma\). Así, \(d\sigma = \frac{dA_h}{r^2}\). Si proyectamos el área, obtenemos \(d\theta\) y \(d\phi\): pequeños cambios en los ángulos que nos generan nuestra pequeña área (“Computer graphics and imaging” 2022, Radiometry & Photometry).

\(dA_h\) debe tener dos lados \(lado_1\) y \(lado_2\). Podemos hallar \(lado_1\) si lo trasladamos al eje \(z\) de nuevo. Así, \(lado_1 = r \sin d\phi\). De la misma manera, \(lado_2 = r d\theta\).

Poniendo estos valores en \(d\sigma\):

\[ \begin{aligned} d\sigma & = \frac{dA_h}{r^2} = \frac{lado_1 lado_2}{r^2} = \\ & = \frac{r \sin\theta\ d\phi\ r\ d\theta}{r^2} = \\ & = \sin\theta\ d\theta\ d\phi \end{aligned} \](11)

¡Genial! Acabamos de añadir un recurso muy potente a nuestro inventario. Esta expresión nos permitirá convertir integrales sobre ángulos sólidos en integrales sobre ángulos esféricos. Por ejemplo, este sería el caso de la esfera.

Supongamos que queremos encontrar el ángulo sólido correspondiente al conjunto de todas las direcciones sobre la esfera \(\mathbb{S}^2\). Se tiene que

\[ \begin{aligned} \sigma & = \int_{\mathbb{S}^2}{d\omega} = \int_{0}^{2\pi} \int_{0}^{\pi} {\sin\theta\ d\theta d\phi} = \\ & = 4\pi \text{ sr} \end{aligned} \]

Además, esto nos dice que un hemisferio de la esfera corresponde a \(2\pi\) estereorradianes.

En la práctica es muy común considerar el ángulo sólido asociado a una dirección en la esfera \(\omega\), el cual se denota por \(d\omega\). A partir de este punto usaremos esa notación.

Los ángulos sólidos nos proporcionan una variedad de herramientas nuevas considerable. Gracias a ellos, podemos desarrollar algunos conceptos nuevos. Uno de ellos es la intensidad radiante.

Imaginémonos un pequeñito punto de luz encerrado en una esfera, el cual emite fotones en todas direcciones (es decir, su ángulo sólido es el de la esfera, \(4\pi\)). Nos gustaría medir cuánta energía pasa por la esfera. Podríamos entonces definir

\[ I = \frac{\Phi}{4\pi} \text{(W/sr)} \]

Si en vez de utilizar toda la esfera, cerramos el ángulo lo máximo posible, nos estaríamos restringiendo a un área extremadamente pequeña, lo cual nos proporcionaría la densidad angular de flujo radiante:

\[ I = \lim_{\Delta\omega \to 0}{\frac{\Delta\Phi}{\Delta\omega}} = \frac{d\Phi}{d\omega} \](12)

De la misma manera que con los conceptos anteriores, podemos volver a la potencia integrando sobre un conjunto de direcciones \(\Omega\) de la esfera:

\[ \Phi = \int_{\Omega}{I(\omega)d\omega} \]

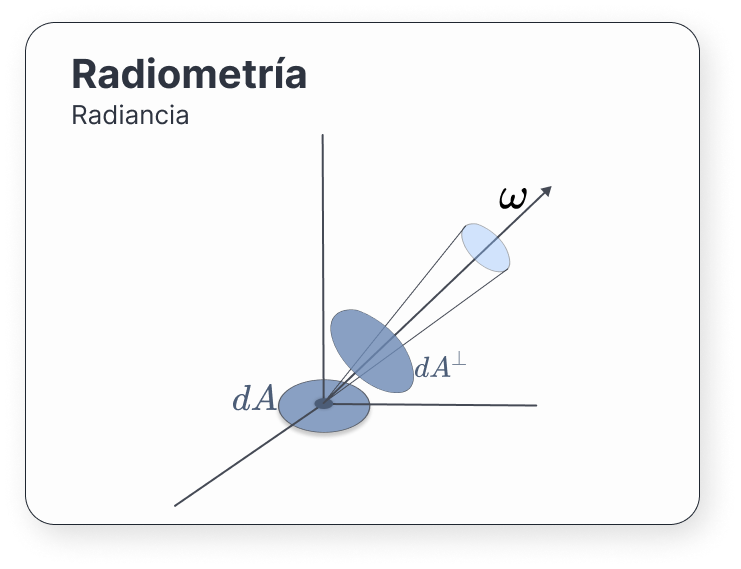

Finalmente, llegamos a uno de los conceptos más importantes de esta sección, el cual es una extensión de la radiancia emitida teniendo en cuenta la dirección de la luz. La radiancia espectral (o radiancia a secas2) (Pharr, Jakob, and Humphreys 2016, Radiometry), denotada por \(L(p, \omega)\), es la irradiancia por unidad de ángulo sólido \(d\omega\) asociado a una dirección \(\omega\):

\[ L(p, \omega) = \lim_{\Delta\omega \to 0}{\frac{\Delta E_\omega(p)}{\Delta\omega}} = \frac{dE_\omega(p)}{d\omega} \](13)

Expandiendo esta expresión, se tiene que la radiancia también es la potencia que pasa por un punto \(p\) y viaja en una dirección \(\omega\) por unidad de área (perpendicular a \(\omega\)) alrededor de \(p\), por unidad de ángulo sólido \(d\omega\):

\[ L(p, \omega) = \frac{d^2\Phi(p, \omega)}{d\omega\ dA^\bot} = \frac{d^2\Phi(p, \omega)}{d\omega\ dA\ \cos\theta} \](14)

donde \(dA^\bot\) es el área proyectada por \(dA\) en una hipotética superficie perpendicular a \(\omega\):

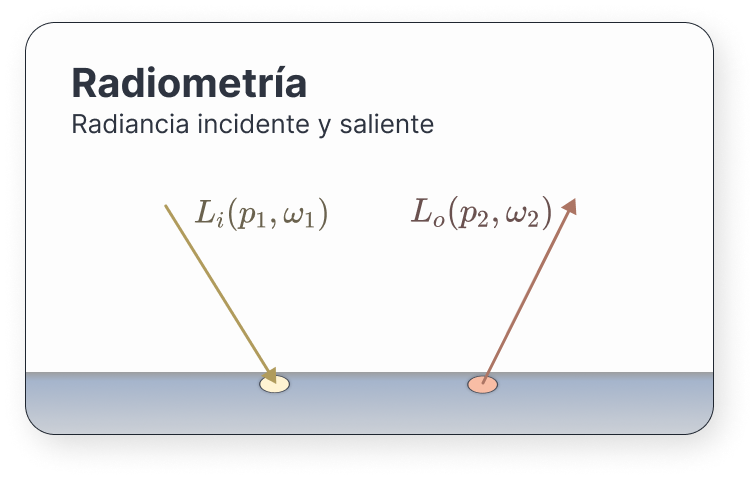

Cuando un rayo impacta en una superficie, \(L\) puede tomar valores muy diferentes en un lado y otro de esta. A fin de cuentas, necesitamos distinguir entre los fotones que llegan a la superficie y los que salen. Para solucionarlo podemos distinguir entre la radiancia que llega a un punto –la incidente–, y la saliente.

A la radiancia incidente o entrante la llamaremos \(L_i(p, \omega)\), mientras que la radiancia saliente se denomina \(L_o(p, \omega)\).

Es importante destacar que \(\omega\) apunta hacia fuera de la superficie. Para \(L_o(p, \omega)\) se tiene que la radiancia viaja en el sentido de \(\omega\), mientras que para \(L_i(p, \omega)\) se tiene que la radiancia viaja en el sentido contrario a \(\omega\); es decir, hacia el punto \(p\).

Una propiedad a tener en cuenta es que, si cogemos un punto \(p\) del espacio donde no existe ninguna superifcie, \(L_o(p, \omega) = L_i(p, -\omega) = L(p, \omega)\)

La importancia de la radiancia se debe a un par de propiedades:

La primera de ellas es que, dado \(L\), podemos calcular cualquier otra unidad básica mediante integración. Además, su valor se mantiene constante en rayos que viajan en el vacío en línea recta (Fabio Pellacini 2022). Esto último hace que resulte muy natural usarla en un ray tracer.

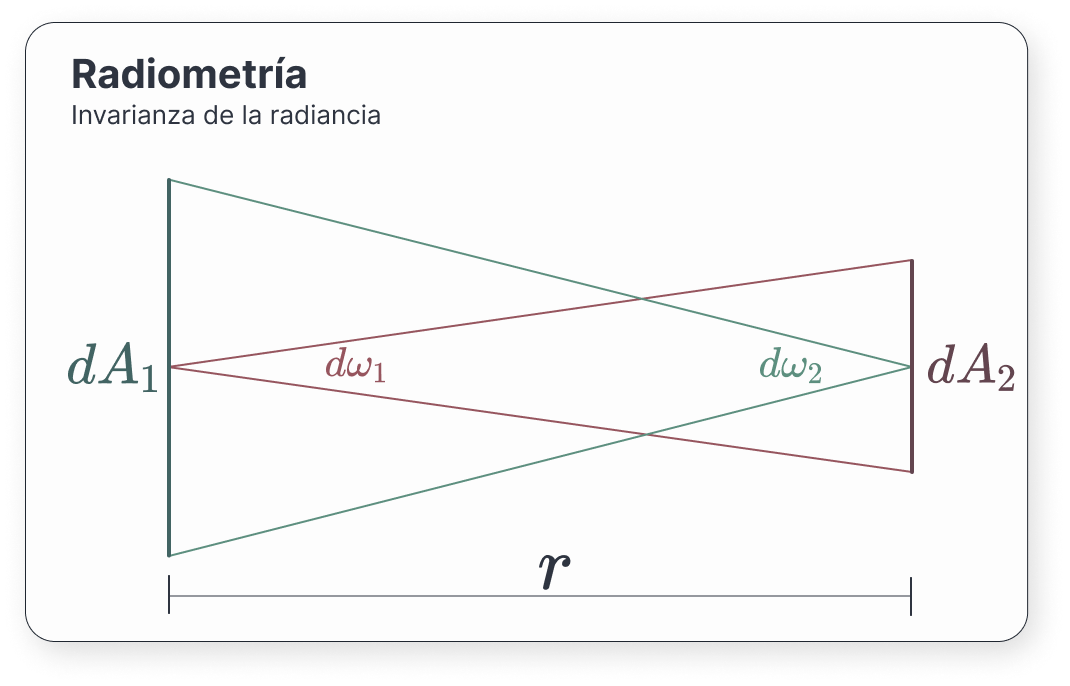

Veamos por qué ocurre esto:

Consideremos dos superficies ortogonales entre sí separadas una distancia \(r\). Debido a la conservación de la energía, cualquier fotón que salga de una superficie y se encuentre bajo el ángulo sólido de la otra debe llegar impactar en dicha superficie opuesta.

Por tanto:

\[ d^2\Phi_1 = d^2\Phi_2 \]

Sustituyendo en la expresión de la radiancia [14], y teniendo en cuenta que son ortogonales (lo que nos dice que \(\cos\theta = 1\)):

\[ L_1 d\omega_1 dA_1 = L_2 d\omega_2 dA_2 \]

Por construcción, podemos cambiar los ángulos sólidos:

\[ L_1 \frac{dA_2}{r^2} dA_1 = L_2 \frac{dA_1}{r^2} dA_2 \]

Lo que finalmente nos dice que \(L_1 = L_2\), como queríamos ver.

En esta sección, vamos a explorar las nuevas herramientas que nos proporciona la radiancia. Veremos también cómo integrar ángulos sólidos, y cómo simplificar dichas integrales.

Como dijimos al final de la sección de la irradiancia, esta medida no tiene en cuenta las direcciones desde las que llegaba la luz. A diferencia de esta, la radiancia sí que las utiliza. Dado que una de las ventajas de la radiancia es que nos permite obtener el resto de medidas radiométricas, ¿por qué no desarrollamos una nueva expresión de la irradiancia?

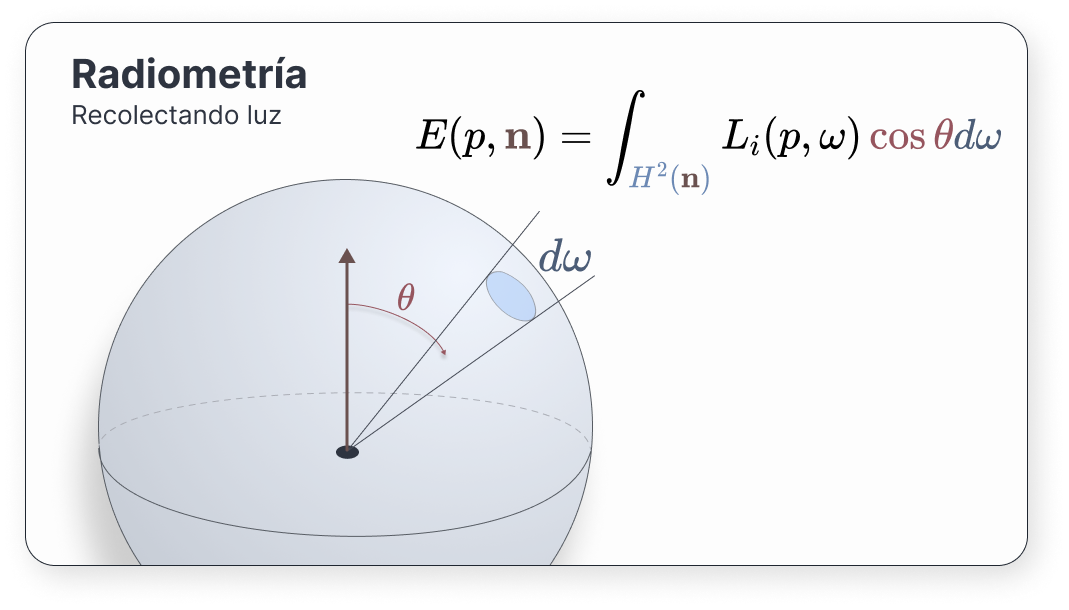

Para obtener cuánta luz llega a un punto, debemos acumular la radiancia incidente que nos llega desde cualquier dirección. Dado un punto \(p\) que se encuentra en una superficie con normal \(\mathbf{n}\) en dicho punto, la irradiancia se puede expresar como (Pharr, Jakob, and Humphreys 2016, Working with Radiometric Integrals)

\[ E(p, \mathbf{n}) = \int_{\Omega}{L_i(p, \omega) \left\lvert cos\theta \right\rvert d\omega} \](15)

Siendo \(\Omega\) un subcojunto de direcciones de la esfera \(\mathbb{S}^2\). El término \(\cos\theta\) aparece en la integral debido a la derivada del área proyectada, \(dA^\bot\). \(\theta\) es el ángulo entre la dirección \(\omega\) y la normal \(\mathbf{n}\).

Generalmente, la irradiancia se calcula únicamente en el hemisferio de direcciones asociado a la normal en el punto, \(H^2(\mathbf{n})\).

Podemos eliminar el \(\cos\theta\) de la integral mediante una pequeña transformación: proyectando el ángulo sólido sobre el disco alrededor del punto \(p\) con normal \(\mathbf{n}\), obtenemos una expresión más sencilla: como \(d\omega^\bot = \left\lvert \cos\theta \right\rvert d\omega\), entonces

\[ \begin{aligned} E(p, \mathbf{n}) = \int_{H^2(\mathbf{n})}{L_i(p, \omega) d\omega^\bot} \end{aligned} \]

Usando lo que aprendimos sobre la derivada de los ángulos sólidos [11], se puede reescribir la ecuación anterior como

\[ E(p, \mathbf{n}) = \int_{0}^{2\pi}\int_{0}^{\pi/2}{L_i(p, \theta, \phi) \cos\theta\ \sin\theta\ d\theta\ d\phi} \]

Si integramos esta expresión para todos los puntos de una superficie \(A\), obtenemos la potencia total saliente de esa superficie en todas las direcciones:

\[ \begin{aligned} \Phi & = \int_{A}\int_{H^2(\mathbf{n})}{L_o(p, \omega) \cos\theta\ d\omega dA} = \\ & = \int_{A}\int_{H^2(\mathbf{n})}{L_o(p, \omega) d\omega^\bot dA} \end{aligned} \]

Una herramienta más que nos vendrá bien será la capacidad de convertir integrales sobre direcciones en integrales sobre área. Hemos hecho algo similar en las secciones anteriores, así que no perdemos nada por generalizarlo.

Considera un punto \(p\) sobre una superficie con normal en dicho punto \(\mathbf{n}\). Supongamos que tenemos una pequeña área \(dA\) con normal \(\mathbf{n_{dA}}\). Sea \(\theta\) el ángulo entre \(\mathbf{n}\) y \(\mathbf{n_{dA}}\), y \(r\) la distancia entre \(p\) y \(dA\).

Entonces, la relación entre un ángulo sólido diferencial y un área diferencial es

\[ d\omega = \frac{dA\cos\theta}{r^2} \](16)

Esto nos permite, por ejemplo, expandir algunas expresiones como la de la irradiancia [15] si partimos de un cuadrilátero \(dA\):

\[ \begin{aligned} E(p, \mathbf{n}) & = \int_{\mathbb{S}^2}{L_i(p, \omega) \left\lvert \cos\theta \right\rvert d\omega} = \\ & = \int_{A}{L\cos\theta\ \frac{\cos\theta_o}{r^2}dA} \end{aligned} \]

siendo \(\theta_o\) el ángulo de la radiancia de salida de la superficie del cuadrilátero.

Existe un área de la física muy similar a la radiometría denominada fotometría. La fotometría se encarga de medir la luminosidad percibida, puesto que el ojo humano tiene una sensibilidad específica para cada longitud de onda (Zsolnai-Fehér and Celarek 2022). En vez de radiancia, se suele hablar de luminancia, y todas las unidades vistas durante este capítulo tienen su análogo.

| Radiometría | Símbolo y unidad | Fotometría | Símbolo y unidad |

|---|---|---|---|

| Energía radiante | \(Q_e\), julios \((\text{J})\) | Energía lumínica | \(Q_v\), lumen segundo \((\text{lm s})\) |

| Flujo radiante | \(\phi_e\), vatios \((\text{W})\) | Flujo luminoso | \(\phi_v\), lumen \((\text{lm} = \text{cd sr})\) |

| Intensidad radiante | \(I_e\), vatios por estereorradián \((\text{W/sr})\) | Intensidad luminosa | \(I_v\), candela \((\text{cd} = \text{lm/sr})\) |

| Radiancia | \(L_e\), \((\text{W sr}^{-1}\text{m}^{-1})\) | Luminancia | \(L_v\), candela por metro cuadrado \((\text{cd/m}^{2})\) |

| Irradiancia | \(E_e\), \((\text{W/m}^{2})\) | Iluminancia | \(E_v\), lux \((\text{lx} = \text{lm/m}^2)\) |

Cuando la luz impacta en una superficie, ocurren un par de sucesos: parte de los fotones se reflejan saliendo disparados hacia alguna dirección, mientras que otros se absorben. La forma en la que se comportan depende de cómo sea la superficie. Específicamente, del material del que esté hecha.

En informática gráfica se consideran tres tipos principales de dispersión de luz: dispersión y reflexión en superficies (surface scattering), dispersión volumétrica (volumetric scattering) y dispersión bajo superficie (subsurface scattering)

En este capítulo vamos a modelar la primera. Estudiaremos qué es lo que ocurre cuando los fotones alcanzan una superficie, en qué dirección se reflejan, y cómo cambia el comportamiento dependiendo de las propiedades del material.

La función de distribución de reflectancia bidireccional (en inglés, bidirectional reflectance distribution function, BRDF) (Pharr, Jakob, and Humphreys 2016, Surface Reflection) describe cómo la luz se refleja en una superficie opaca. Se encarga de informarnos sobre cuánta radiancia sale en dirección \(\omega_o\) debido a la radiancia incidente desde la dirección \(\omega_i\), partiendo de un punto \(p\) en una superficie con normal \(\mathbf{n}\). Depende de la longitud de onda \(\lambda\), pero, como de costumbre, la omitiremos.

Intuición: ¿cuál es la probabilidad de que, habiéndome llegado un fotón desde \(\omega_i\), me salga disparado hacia \(\omega_o\)?

Si consideramos \(\omega_i\) como un cono diferencial de direcciones, la irradiancia diferencial en \(p\) viene dada por

\[ dE(p, \omega_i) = L_i(p, \omega_i) \cos\theta_i\ d\omega_i \]

Debido a esta irradiancia, una pequeña parte de radiancia saldrá en dirección \(\omega_o\), proporcional a la irradiancia:

\[ dL_o(p, \omega_o) \propto dE(p, \omega_i) \]

Si lo ponemos en forma de cociente, sabremos exactamente cuál es la proporción de luz. A este cociente lo llamaremos \(f_r(p, \omega_o \leftarrow \omega_i)\); la función de distribución de reflectancia bidireccional:

\[ f_r(p, \omega_o \leftarrow \omega_i) = \frac{dL_o(p, \omega_o)}{dE(p, \omega_i)} = \frac{dL_o(p, \omega_o)}{L_i(p, \omega_i) \cos\theta_i\ d\omega_i} (\text{sr}^{-1}) \]

Nota(ción): dependiendo de la fuente que estés leyendo, es posible que te encuentres una integral algo diferente. Por ejemplo, en (Shirley and Morley 2003) se integra con respecto a los ángulos de salida \(\omega_o\), en vez de los incidentes.

Aquí, usaremos la notación de integrar con respecto a los incidentes, como se hace en (Pharr, Jakob, and Humphreys 2016).

Las BRDF físicamente realistas tienen un par de propiedades importantes:

\[ \int_{H^2(\mathbf{n})}{f_r(p, \omega_o \leftarrow \omega_i) \cos\theta_i\ d\omega_i} \leq 1 \]

Si la BRDF describe cómo se refleja la luz, la bidirectional transmittance distribution function (abreviada BTDF) nos informará sobre la transmitancia; es decir, cómo se comporta la luz cuando entra en un medio. Generalmente serán dos caras de la misma moneda: cuando la luz impacta en una superficie, parte de ella, se reflejará, y otra parte se transmitirá.

Puedes imaginarte la BTDF como una función de reflectancia del hemisferio opuesto a donde se encuentra la normal de la superficie.

Denotaremos a la BTDF por

\[ f_t(p, \omega_o \leftarrow \omega_i) \]

Al contrario que en la BRDF, \(\omega_o\) y \(\omega_i\) se encuentran en hemisferios diferentes.

Convenientemente, podemos unir la BRDF y la BTDF en una sola expresión, llamada la función de distribución de dispersión bidireccional (bidirectional scattering distribution function, BSDF). A la BSDF la denotaremos por

\[ f(p, \omega_o \leftarrow \omega_i) \]

Nota(ción): también se suele utilizar BxDF en vez de BSDF.

Usando esta definición, podemos obtener

\[ dL_o(p, \omega_o) = f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \left\lvert \cos\theta_i \right\rvert d\omega_i \]

Esto nos deja a punto de caramelo una nueva expresión de la randiancia en términos de la randiancia incidente en un punto \(p\). Integrando la expresión anterior, obtenemos

\[ L_o(p, \omega_o) = \int_{\mathbb{S}^2}{f(p, \omega_o \leftarrow \omega_i)L_i(p, \omega_i)\left\lvert \cos\theta_i \right\rvert d\omega_i} \](17)

siendo \(\mathbb{S}^2\) la esfera.

Intuición: la BSDF son todas las posibles direcciones en las que puede salir disparada la luz.

Esta forma de expresar la radiancia es muy importante. Generalmente se le suele llamar la ecuación de dispersión (scattering equation, en inglés), y en capítulos posteriores buscaremos formas de evaluarla rápidamente. ¡Los métodos de Monte Carlo nos vendrán de perlas!

Las BSDFs tienen unas propiedades interesantes:

\[ \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) \cos\theta_i\ d\omega_i} \le 1\ \forall \omega_o \]

Puede ser útil tomar el comportamiento agregado de las BRDFs y las BTDFs y reducirlo un cierto valor que describa su comportamiento general de dispersión. Sería algo así como un resumen de su distribución. Para conseguirlo, vamos a introducir dos nuevas funciones:

El albedo (Szirmay-Kalos 2000), también conocido como la reflectancia hemisférica-direccional (hemispherical-directional reflectance) (Pharr, Jakob, and Humphreys 2016, Reflection Models, Basic Interface) describe la radiancia saliente en la dirección \(\omega_o\), supuesto que la radiancia entrante desde cualquier dirección es constante e igual a la unidad:

\[ \rho_{hd}(\omega_o) = \int_{H^2(n)}{f_r(p, \omega_o \leftarrow \omega_i) \left\lvert \cos\theta_i \right\rvert\ d\omega_i} \]

Por otra parte, la reflectancia hemisférica-hemisférica (hemispherical-hemispherical reflectance) es un valor espectral que nos proporciona el ratio de luz incidente reflejada por una superficie, suponiendo que llega la misma luz desde todas direcciones:

\[ \rho_{hh} = \frac{1}{\pi} \int_{H^2(n)} \int_{H^2(n)}{f_r(p, \omega_o \leftarrow \omega_i) \left\lvert \cos\theta_o\ \cos\theta_i \right\rvert\ d\omega_o\ d\omega_i} \]

En la práctica, cada superficie tendrá una BSDF característica. Esto hace que la luz adquiera una dirección particular al incidir en cada punto de esta. En esta sección, vamos a tratar algunas BSDFs particulares e introduciremos las fórmulas fundamentales que se usan en los modelos de materiales (también conocidos como modelos de shading).

Los tipos de materiales que trataremos son los más básicos. Entre ellos, se encuentran los difusos lambertianos, materiales dieléctricos, espejos y algunas BSDFs compuestas. Un repertorio de implementaciones se encuentra en el repositorio de BRDFs de Walt Disney Animation Studios (“BRDF explorer” 2019).

Prácticamente toda superficie, en mayor o menor medida, refleja parte de la luz incidente. Otros tipos de materiales reflejan y refractan a la vez, como puede ser un espejo o el agua.

En esencia, los reflejos se pueden clasificar en cuatro grandes tipos (McGuire 2021, Materials):

Ten en cuenta que es muy difícil encontrar objetos físicos que imiten a la perfección un cierto modelo. Suelen recaer en un híbrido entre dos o más modelos.

Fijado un cierto modelo, la función de distribución de reflectancia, BRDF, puede ser isotrópica o anisotrópica. Los materiales isotrópicos son aquellos cuya BRDF \(f_r(p, \omega_o \leftarrow \omega_i)\) no cambia cuando se rotan los vectores \(\omega_o, \omega_i\) un mismo ángulo alrededor de \(p\). La mayor parte de los materiales son de este tipo.

Por el contrario, si la BRDF sí cambia cuando se aplica dicha rotación, entonces nos encontramos ante un material anisotrópico. Esto suele ocurrir cuando tratamos con superficies pulidas con surcos. Algunos ejemplos son los discos de vinilo y los metales pulidos en una dirección.

Primero, tratemos con materiales que únicamente reflejan luz; es decir, su BSDF es una BRDF.

Para un material especular perfecto (es decir, espejos), la dirección reflejada \(\omega_o\) dado un rayo incidente \(\omega_i\) es (Haines 2021, 105; Pharr, Jakob, and Humphreys 2016, Specular Reflection and Transmission; McGuire 2021, Materials):

\[ \omega_o = 2 \mathbf{n} (\omega_i \cdot \mathbf{n}) -\omega_i \]

siendo \(\mathbf{n}\) la normal en el punto incidente. Con esta expresión, se necesita que \(\mathbf{n}\) esté normalizado. Para los otros dos vectores no es necesario; la dirección de salida tendrá la misma norma que la de entrada.

La BRDF de un material especular perfecto se describe en términos de la proporción de radiancia reflejada hacia \(\omega_o\) dependiente del vector incidente \(\omega_i\), la cual puede viene descrita por \(\rho_{hd}(\omega_i)\). Se da la relación

\[ \rho_{hd}(\omega_i) = \int_{\mathbb{S}^2} {f_r(p, \omega_o \leftarrow \omega_i)\ d\omega_o} \]

Puesto que en los espejos perfectos no se pierde energía, necesariamente \(\rho_{hd} = 1\).

Debemos tener en cuenta que la probabilidad de que un rayo tenga una dirección diferente a la del reflejo es 0, por lo que

\[ f_r(p, \omega_o \leftarrow \omega_i) = 0 \qquad \forall\ \omega_0 \ne 2 \mathbf{n} (\omega_i \cdot \mathbf{n}) -\omega_i \]

La función de densidad evaluada en el vector reflejado es problemática. Está claro que debe integrar \(\rho_{hd}\), pero el ángulo sólido en el que se integra tiene medida cero, pues toda la radiancia se refleja hacia una única dirección. Esto significa que

\[ f_r(\omega_o \leftarrow \omega_i ) = \frac{\rho_{hd}(\omega_i)}{0 \left\lvert \omega_i \cdot \mathbf{n} \right\rvert} \]

Podemos solucionar este problema utilizando una Delta de Dirac, obteniendo finalmente la BRDF de los materiales especulares perfectos:

\[ \begin{aligned} f_r(\omega_o \leftarrow \omega_i ) & = \frac{\delta(\omega_o, \omega_i) \rho_{hd}(\omega_i)}{\left\lvert \omega_i \cdot \mathbf{n} \right\rvert} = \\ & = \frac{\delta(\omega_o, \omega_i) \left\lvert \omega_i \cdot \mathbf{n} \right\rvert k_r}{\left\lvert \omega_i \cdot \mathbf{n} \right\rvert} \end{aligned} \](18)

siendo \(\rho_{hd}(\omega_i) = \left\lvert \omega_i \cdot \mathbf{n} \right\rvert k_r\) el albedo, con \(k_r\) el coeficiente de reflectividad, cuyo valor se encuentra entre 0 y 1, dependiendo de la energía que se pierda.

Este es uno de los modelos más sencillos. Es conocido también como el modelo lambertiano. Se asume que la superficie es completamente difusa, lo cual implica que la luz se refleja en todas direcciones equiprobablemente, independientemente del punto de vista del observador (McGuire 2021, Materials). Esto significa que

\[ f_r(\omega_o \leftarrow \omega_i) = \frac{\rho_{hd}}{\pi} \]

El albedo \(0 \le \rho_{hd} \le 1\) es la reflectividad de la superficie. El denominador es aquel coeficiente tal que se normalice la BRDF:

\[ \int_{\mathbb{S}^2} {\max(\mathbf{n} \cdot \omega_i, 0)\ d\omega_i} = \pi \]

En la práctica no se utiliza mucho, pues está muy limitado.

El modelo de Phong se basa en la observación de que, cuando el punto de vista se alinea con la dirección del vector de luz reflejado, aparecen puntos muy iluminados, lo que se conoce como resaltado especular.

Su BRDF es

\[ f_r(p, \omega_o \leftarrow \omega_i) = \frac{\alpha + 2}{2\pi} \max{(0, \omega_i \cdot \omega_o)}^\alpha \]

donde \(\alpha\) es índice del brillo del material, y \(\omega_o\) el vector reflejado teniendo en cuenta \(\omega_i\) y \(\mathbf{n}\). El coeficiente \(\frac{\alpha + 2}{2\pi}\) se utiliza para normalizarla (Giesen 2009)

Este modelo de iluminación se suele usar en rasterización y no es común encontrarlo en ray tracing físicamente realista. En su versión de rasterización hace falta definir los coeficientes ambientales y difusos. Aquí solo hemos optado por el especular.

Este es una pequeña modificación al de Phong. En vez de usar el vector reflejado de luz, se define un vector unitario entre el observador y la luz, \(\mathbf{h} = \frac{\omega + \mathbf{l}}{\left\lVert \omega + \mathbf{l} \right\rVert}\). Resulta más fácil calcularlo. Además, este modelo es más realista.

\[ f_r(p, \omega_o \leftarrow \omega_i) = \frac{8 \pi(2^{-\alpha/2} + \alpha)}{(\alpha + 2)(\alpha + 4)} \max\{0, \mathbf{h} \cdot \mathbf{n}\}^\alpha \]

De la misma manera que en Phong, \(\frac{8 \pi(2^{-\alpha/2} + \alpha)}{(\alpha + 2)(\alpha + 4)}\) es el coeficiente de normalización de la BRDF (Giesen 2009).

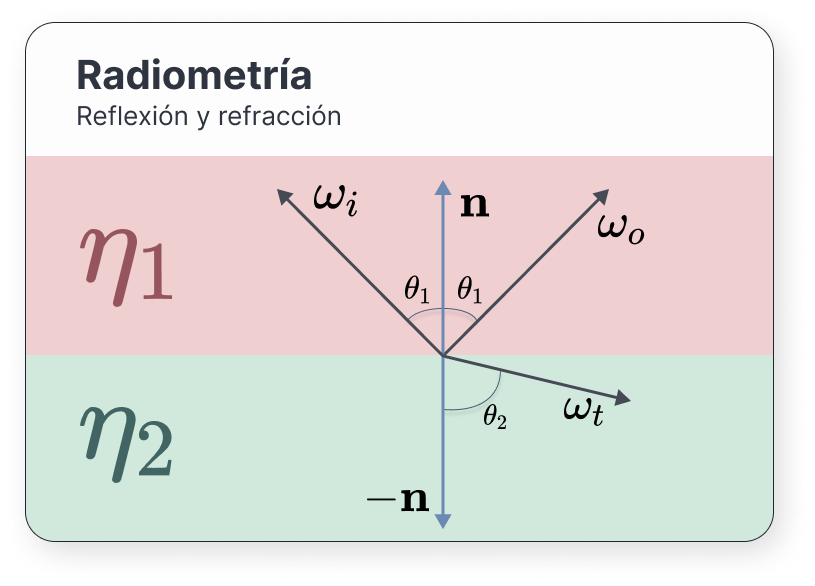

Algunos materiales permiten que la luz los atraviese –conocido como transmisión–. En estos casos, decimos que se produce un cambio en el medio. Para conocer cómo de rápido viajan los fotones a través de ellos, se utiliza un valor denominado índice de refracción, usualmente denotado por \(\eta\):

\[ \eta = \frac{c}{\nu} \]

siendo \(c\) la velocidad de la luz en el vacío y \(\nu\) la velocidad de fase del medio, la cual depende de la longitud de onda. Sin embargo, como hemos comentado varias veces, no tendremos en cuenta la longitud de onda en nuestro ray tracer, por lo que no nos tenemos que preocupar de esto.

Algunos materiales como el aire tienen un índice de refracción \(\eta_{\text{aire}} = 1.0003\), mientras que el del agua vale \(\eta_{\text{agua}} = 1.333\), y el del cristal vale \(\eta_{\text{cristal}} = 1.52\).

La ley de Snell nos proporciona una ecuación muy sencilla que relaciona el cambio de un medio con índice de refracción \(\eta_1\) a otro con índice de refracción \(\eta_2\):

\[ \eta_1 \sin\theta_1 = \eta_2 \sin\theta_2 \](19)

siendo \(\theta_1\) y \(\theta_2\) los ángulos de entrada y salida respectivamente.

Usualmente, los índices de refración son conocidos, así como el ángulo de incidencia \(\theta_1\), por lo que podremos calcular el ángulo del vector refractado con facilidad:

\[ \theta_2 = \arcsin{\left(\frac{\eta_1}{\eta_2}\sin\theta_2\right)} \]

Cuando cambiamos de un medio con índice de refracción \(\eta_1\) a otro con \(\eta_2 < \eta_1\), podemos encontrarnos ante un caso de reflexión interna total. Analíticamente, lo que ocurre es que

\[ \sin\theta_2 = \frac{\eta_1}{\eta_2}\sin\theta_1 > 1 \]

lo cual no puede ocurrir. Se denomina el ángulo crítico a aquel \(\theta_1\) para la cual \(\frac{\eta_1}{\eta_2}\sin\theta_1 > 1\):

\[ \theta_1 = \arcsin{\left(\frac{\eta_2}{\eta_1}\right)} \]

Por ejemplo, si un haz de luz viaja desde un cristal hacia un cuerpo de agua, entonces \(\theta_1 = \arcsin{(1.333/1.52)} \approx 1.06\) radianes \(= 61.04\textdegree\).

Lo que ocurre en estos casos es que, en vez de pasar al segundo medio, los fotones vuelven al primero; creando un reflejo como si de un espejo se tratara.

El vector refractado \(\omega_t\) puede conseguirse a partir de la siguiente expresión (McGuire 2021):

\[ \omega_t = - \frac{\eta_1}{\eta_2}\left(\omega_i - (\omega_i \cdot \mathbf{n})\mathbf{n}\right) - \left( \sqrt{1 - \left(\frac{\eta_1}{\eta_2}\right)^2 \left(1 - (\omega_i \cdot \mathbf{n}^2)\right)} \right) \cdot \mathbf{n} \]

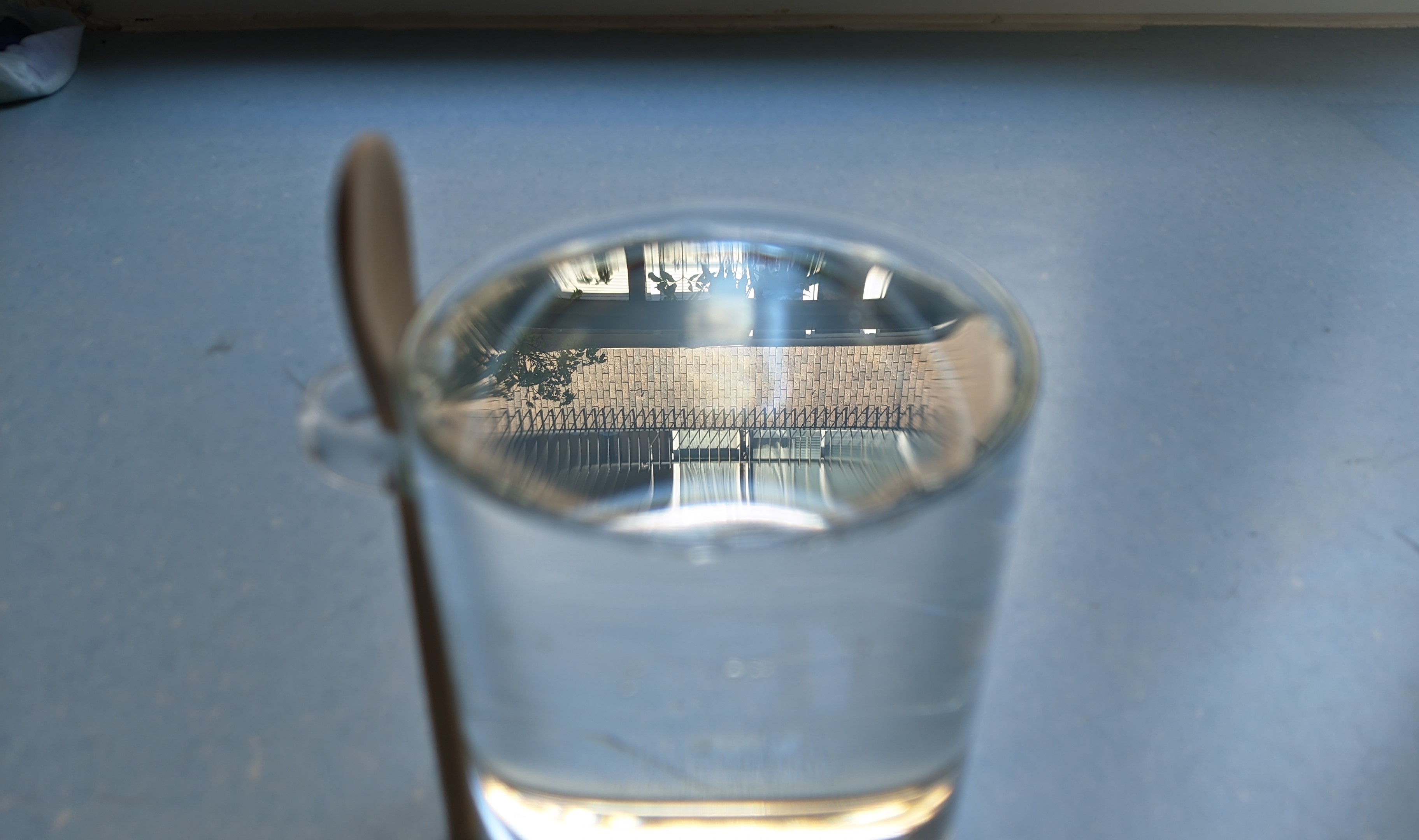

Aquellos materiales que refractan y reflejan luz (como el agua de la foto anterior) no pueden generar energía de la nada; por lo que la combinación de ambos efectos debe ser proporcional a la luz incidente. Es decir, una fracción de luz es reflejada, y otra es refractada. Las ecuaciones de Fresnel nos permiten conocer esta cantidad.

La proporción de luz reflejada desde un rayo que viaja por un medio con índice de refracción \(\eta_1\) y ángulo de incidencia \(\theta_1\) a otro medio con índice de refracción \(\eta_2\) es (Majercik 2021, 109):

\[ \begin{aligned} R_s & = \left\lvert \frac {\eta_1 \cos\theta_1 - \eta_2 \sqrt{1 - \left( \frac{\eta_1}{\eta_2}\sin\theta_1\right) ^2}} {\eta_1 \cos\theta_1 + \eta_2 \sqrt{1 - \left( \frac{\eta_1}{\eta_2}\sin\theta_1\right) ^2}} \right\rvert^2 \\ R_p & = \left\lvert \frac {\eta_1 \sqrt{1 - \left( \frac{\eta_1}{\eta_2}\sin\theta_1\right)^2} - \eta_2\cos\theta_1} {\eta_1 \sqrt{1 - \left( \frac{\eta_1}{\eta_2}\sin\theta_1\right)^2} + \eta_2\cos\theta_1} \right\rvert^2 \end{aligned} \](20)

donde los subíndices \(s\) y \(p\) denotan la polarización de la luz: \(s\) es perpendicular a la dirección de propagación, mientras que \(p\) es paralela.

Generalmente en los ray tracers se simula luz no polarizada, así que se deben promediar ambos valores. Por lo tanto, se debe usar el valor \(R\) definido de la siguiente manera:

\[ R = \frac{R_s + R_p}{2} \](21)

Como podemos imaginarnos, calcular las expresiones de Fresnel [20] no es precisamente barato. En la práctica, todo el mundo utiliza una aproximación creada por Schlick, la cual funciona sorprendentemente bien. Viene dada por

\[ R(\theta_1) = R_0 + (1 - R_0)(1 - \cos\theta_1)^5 \](22)

siendo \(R_0 = R(0)\); es decir, el valor que toma \(R\) cuando el rayo incidente es paralelo al medio. Su valor es

\[ R_0 = \left(\frac{\eta_1 - \eta_2}{\eta_1 + \eta_2}\right)^2 \]

Esta aproximación es 32 veces más rápida de calcular que las ecuaciones de Fresnel, generando un error medio inferior al 1% (Schlick 1994)

La mayor parte de las superficies no son puramente lisas a nivel microscópico. En la mayoría de materiales existen microfacetas, las cuales producen que la luz no se refleje de forma especular. Esto hace que la luz pueda salir en direcciones muy diferentes dependiendo de la rugosidad de la superficie. Este tipo de materiales suele necesitar una función que caracterice la distribución de las normales de las microfacetas (denotada por \(\mathbf{n_f}\)).

Un modelo que utiliza esta idea es el de Oren-Nayar, el cual describe la reflexión difusa de una superficie. Se basa en la idea de que las superficies rugosas aparentan ser más brillantes conforme la dirección de la luz se aproxima a la dirección de la vista. La BRDF de Oren-Nayar es (Pharr, Jakob, and Humphreys 2016, Microfacet Models)

\[ f_r(p, \omega_o \leftarrow \omega_i) = \frac{\rho}{\pi} \left(A + B\max{(0, \cos(\phi_i - \phi_o))}\sin\alpha\tan\beta\right) \]

donde, si \(\theta\) está en radianes,

\[ \begin{aligned} A & = 1 - \frac{\theta^2}{2(\theta^2 + 0.33)} \\ B & = \frac{0.45 \theta^2}{\theta^2 + 0.09} \\ \alpha & = \max{(\theta_i, \theta_o)} \\ \beta & = \min{(\theta_i, \theta_o)} \end{aligned} \]

En la actualidad, el modelo más utilizado de microfacetas es el GGX. Motores modernos como Unreal Engine 4 y Unity lo utilizan en sus pipelines físicamente realistas. La BRDF se define de la siguiente manera (McGuire 2021):

\[ \begin{aligned} f_r(p, \omega_o, \omega_i) & = \frac { D(p, \omega_h) F(p, \omega_i, \omega_o) G_{1}(p, \omega_i, \omega_h) G_{1}(p, \omega_o, \omega_h) } { 4\pi (\mathbf{n} \cdot \omega_i) (\mathbf{n} \cdot \omega_o) } = \\ & = \frac { 4 \alpha^2_p \left(F_0 + (1 - F_0)(1 - \max{(0, \omega_h \cdot \omega_i})^5\right)(\mathbf{n} \cdot \omega_i)(\mathbf{n} \cdot \omega_o) } { \pi \left(1 + (\alpha^2_p - 1) \cdot (\mathbf{n} \cdot \omega_h)^2\right)^2 A_1 A_2 } \end{aligned} \]

siendo

\[ \begin{aligned} A_1 & = \left((\mathbf{n} \cdot \omega_i) + \sqrt{\alpha^2_p + (1 - \alpha^2_p)(\mathbf{n} \cdot \omega_i)^2}\right) \\ A_2 & = \left((\mathbf{n} \cdot \omega_o) + \sqrt{\alpha^2_p + (1 - \alpha^2_p)(\mathbf{n} \cdot \omega_o)^2}\right) \end{aligned} \]

y donde

Y, finalmente, tras esta introducción de los principales conceptos radiométricos, llegamos a la ecuación más importante de todo este trabajo: la rendering equation; también llamada la ecuación del transporte de luz.

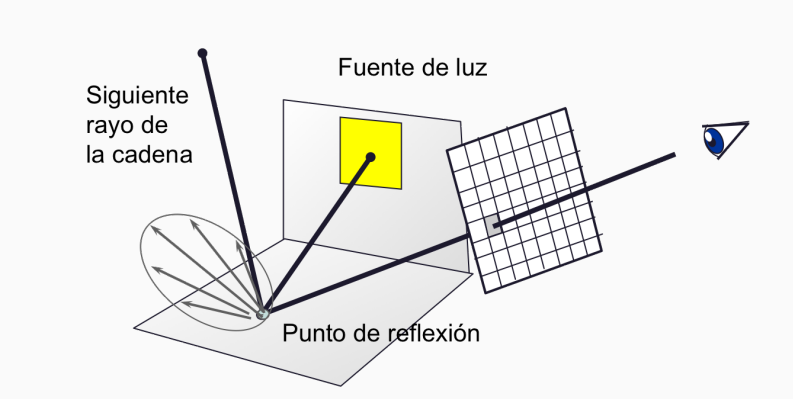

Antes de comenzar, volvamos a plantear de nuevo la situación: nos encontramos observando desde nuestra pantalla una escena virtual mediante la cámara. Queremos saber qué color tomará un pixel específico. Para conseguirlo, dispararemos rayos desde nuestro punto de vista hacia el entorno, haciendo que reboten en los objetos. Cuando un rayo impacte en una superficie, adquirirá parte de las propiedades del material del objeto. Además, de este rayo surgirán otros nuevos (un rayo dispersado y otro refractado), que a su vez repetirán el proceso. La información que se obtiene a partir de estos caminos de rayos nos permitirá darle color al píxel. Con dicha ecuación, describiremos analíticamente cómo ocurre esto.

Un último concepto más: denotemos por \(L_e(p, \omega_o)\) a la radiancia producida por los materiales emisivos. En esencia, estos materiales son fuentes de luz, pues emiten radiancia por sí mismos.

La rendering equation viene dada por la siguiente expresión:

\[ L_o(p, \omega_o) = L_e(p, \omega_o) + \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \cos\theta_i\ d\omega_i} \](23)

Esta ecuación nos proporciona una forma de calcular la radiancia total saliente \(L_o\) en un punto. Esta puede ser hallada como la suma de la radiancia producida por la superficie en dicho punto, \(L_e\) y la radiancia reflejada por el entorno, a la que llamaremos \(L_r\).

\[ L_r(p, \omega_o) = \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \cos\theta_i\ d\omega_i} \](24)

Esta radiancia reflejada se calcula integrando \(f(p, \omega_o \leftarrow \omega_i) L_i(p, \omega_i) \cos\theta_i\) sobre todas las posibles direcciones de luz. Este integrando viene dado por la BSDF \(f(p, \omega_o \leftarrow \omega_i)\), que describe el comportamiento del material en el punto \(p\); la radiancia incidente \(L_i\) en dicho punto; y el ángulo de incidencia \(\theta_i\) de la dirección de entrada con respecto a la normal.

En la ecuación [23], si el material no emite luz, entonces \(L_e = 0\); y la radiancia total de salida coincide con la radiancia total reflejada [24].

Para hacerla operativa en términos computacionales podemos transformarla un poco. Bien, partamos de la ecuación de para la radiancia reflejada:

Buscamos expresar la radiancia incidente en términos de la radiancia reflejada. Para ello, usamos la propiedad de que la radiancia a lo largo de un rayo no cambia.

Si a una superficie le llega un fotón desde alguna parte, debe ser porque “alguien” ha tenido que emitirlo. El fotón necesariamente ha llegado a partir de un rayo. La propiedad nos dice que la radiancia no ha podido cambiar en el camino.

Pues bien, consideremos una función \(r: \mathbb{R}^3 \times \Omega \to \mathbb{R}^3\) tal que, dado un punto \(p\) y una dirección \(\omega\), devuelve el siguiente punto de impacto en una superficie. En esencia, es una función de ray casting (Fabio Pellacini 2022, Path Tracing).

Esta función nos permite expresar el punto anterior de la siguiente forma:

\[ L_i(p, \omega) = L_o(r(p, \omega), -\omega) \]

Esto nos permite cambiar la expresión de \(L_i\) en la integral anterior:

\[ L_r(p, \omega_o) = \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_o(r(p, \omega_i), -\omega_i) \cos\theta_i\ d\omega_i} \]

Finalmente, la radiancia total vendrá dada por la suma de la radiancia emitida y la reflejada:

\[ L_o(p, \omega_o) = L_e(p, \omega_o) + \int_{H^2(\mathbf{n})}{f(p, \omega_o \leftarrow \omega_i) L_o(r(p, \omega_i), -\omega_i) \cos\theta_i\ d\omega_i} \](25)

Y con esto, hemos obtenido una expresión de la rendering equation únicamente en términos de la radiancia de salida.

Si quieres ver gráficamente cómo funciona, te recomiendo pasarte por (Arnebäck 2019). Es un vídeo muy intuitivo.

Si nos paramos a pensar, la ecuación [25] es muy similar a la primera [23]. Sin embargo, hay un par de matices que las hacen muy diferentes:

Este último matiz es importante. Para renderizar una imagen, se necesita calcular la radiancia de salida para aquellos puntos visibles desde nuestra cámara.

Como vimos en el capítulo anterior, la clave para conseguir una imagen en nuestro ray tracer es calcular la cantidad de luz en un punto de la escena. Para ello, necesitamos hallar la radiancia en dicha posición mediante la rendering equation. Sin embargo, es muy difícil resolverla; tanto computacional como analíticamente. Por ello, debemos atacar el problema desde otro punto de vista.

En este capítulo veremos los fundamentos de la integración de Monte Carlo, cómo muestrear distribuciones específicas y métodos para afinar el resultado final. Estas técnicas nos permitirán aproximar el valor que toman las integrales mediante una estimación. Utilizando muestreo aleatorio para evaluar puntos de una función, seremos capaces de obtener un resultado suficientemente bueno.

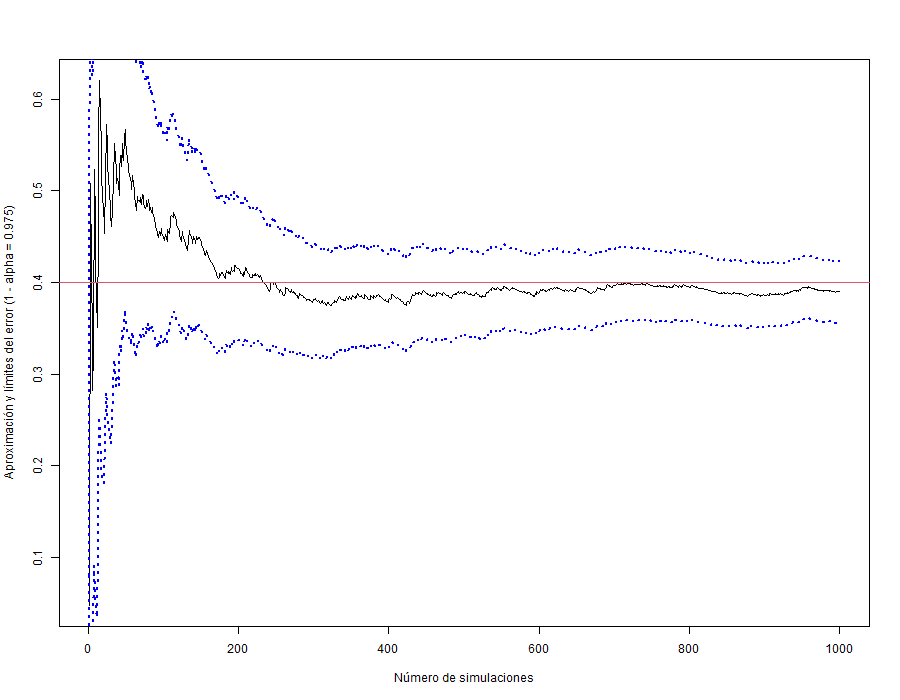

Una de las propiedades que hacen interesantes a este tipo de métodos es la independencia del ratio de convergencia y la dimensionalidad del integrando. Sin embargo, conseguir un mejor rendimiento tiene un precio a pagar. Dadas \(n\) muestras, la convergencia a la solución correcta tiene un orden de \(\mathcal{O}\left(n^{-1/2}\right) = \mathcal{O}\left(\frac{1}{\sqrt{n}}\right)\). Es decir, para reducir el error a la mitad, necesitaríamos 4 veces más muestras. Esto hará que busquemos otras formas de reducir la varianza del estimador.

Antes de comenzar a fondo, necesitaremos unas nociones de variable aleatoria para poder entender la integración de Monte Carlo, por lo que vamos a hacer un breve repaso.

Una variable aleatoria \(X\) (v.a.) es, esencialmente, una regla que asigna un valor numérico a cada posibilidad de un proceso de azar. Formalmente, es una función definida en un espacio de probabilidad \((\Omega, \mathcal{A}, P)\) asociado a un experimento aleatorio:

\[ X: \Omega \rightarrow \mathbb{R} \]

A \(\Omega\) lo conocemos como espacio muestral (conjunto de todas las posibilidades), \(\mathcal{A}\) es una \(\sigma\)-álgebra de subconjuntos de \(\Omega\) que refleja todas las posibilidades de eventos aleatorios, y \(P\) es una función probabilidad, que asigna a cada evento una probabilidad.

Una variable aleatoria \(X\) puede clasificarse atendiendo a cómo sea su rango \(R_X = \left\{x \in \mathbb{R} \,\middle|\, \exists \omega \in \Omega \text{ tal que } X(\omega) = x \right\}\): en discreta o continua, dependiendo de si \(X\) toma valores en un conjunto numerable o no numerable.

Las v.a. discretas son aquellas cuyo rango es un conjunto discreto.